自動運転カーの車載コンピューターの中でNVIDIAの次世代GPUが動きまくっている

NVIDIAカンファレンス レポート:CES2016

「今日はセルフドライビングカーについて話しましょう」

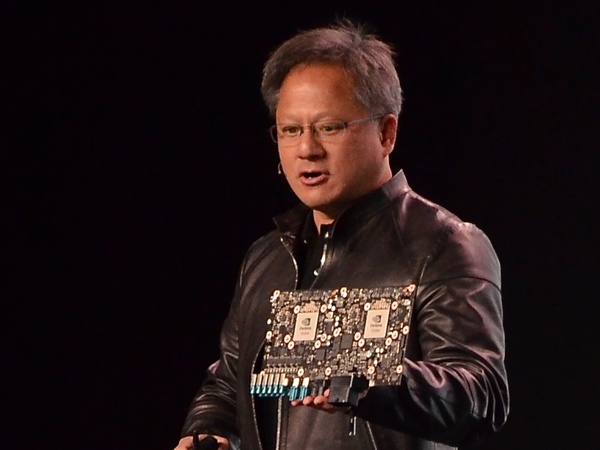

NVIDIAのジェンセン・フアン(Jen-Hsun Huang)CEOは開口一番こう切り出した。昨年のCES2015の基調講演もほぼすべてが自動車関連だったが、今年も同様に自動車関連。その裏のテーマは、自動運転カーの環境認識を急速に進化させているディープラーニング(深層学習)についてだ。

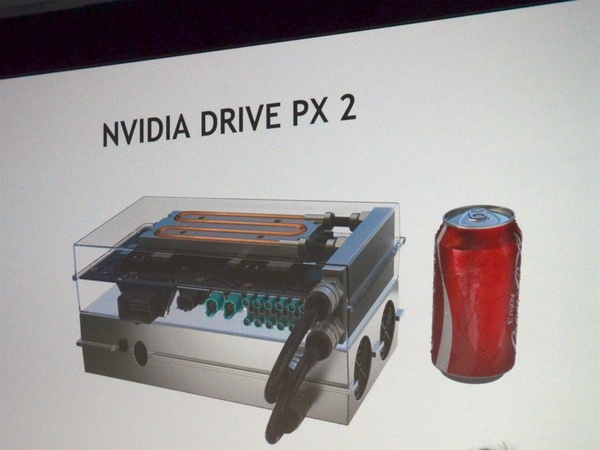

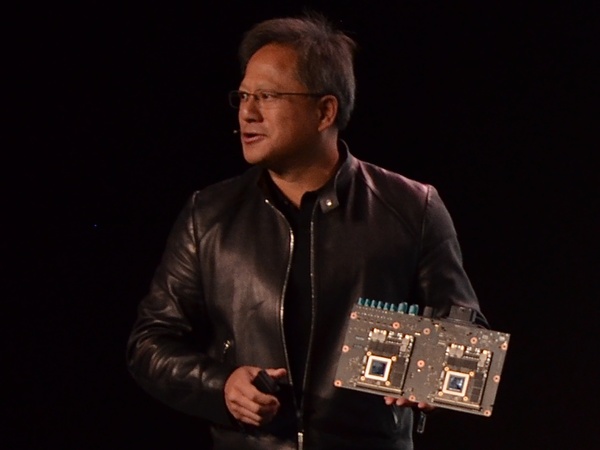

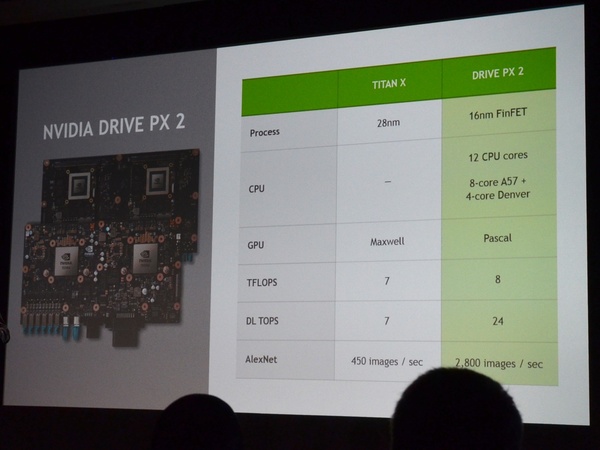

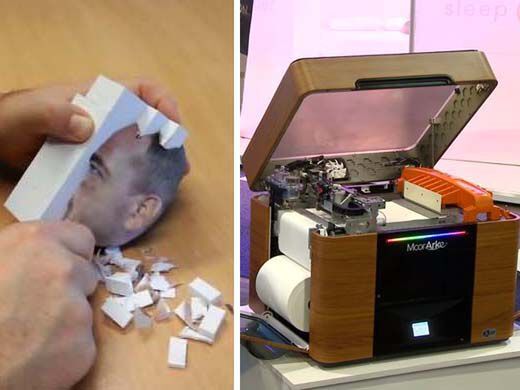

カンファレンスで発表された”製品”は、同社の車載人工知能エンジンの最新版、「DRIVE PX 2」。NVIDIAは「MacBook Pro 150台分のディープラーニング性能」「世界一パワフルな人工知能エンジン」と表現している。

内部には次世代のTegraを2基搭載するほか、背面にはPascalアーキテクチャ採用の次世代GPUを2基搭載。液冷クーラーを組み合わせて「ランチボックスサイズ、250W」というコンパクトなセットに仕上げている。DRIVE PX 2開発プラットフォームの一般販売は2016年第4四半期、つまりほぼ1年後だ。

カンファレンスの全体を割いて語ったのは、NVIDIAの自動車向けのディープラーニングへの取り組みのサマリーと、プラットフォームの整備についてだった。専門性の高い解説も多く理解が容易ではない内容もあるものの、「今ここまで来ている」という成果は一見に値する。

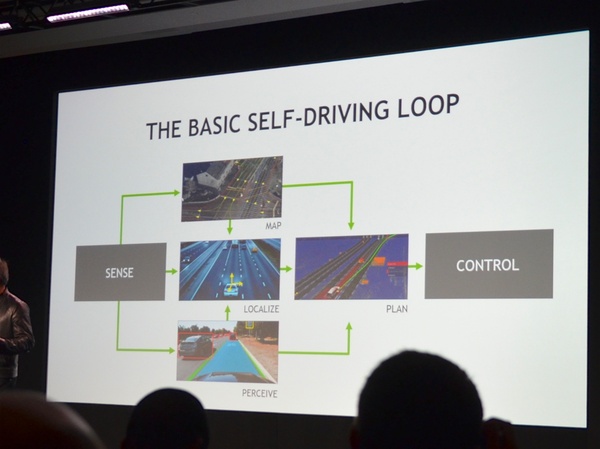

自動運転カーにおいて困難なチャレンジは、「各種センサーが吐き出すリアルタイムの情報と、おびただしい量の演算」(ジェンセン・フアンCEO)を実行しなければならないことだ。

その一端がわかるのが、カンファレンスのアーカイブ動画(記事末尾)の45分前後からの「DriveWorks」のスニークピーク(チラ見せ)だ。DriveWorksは、「OSであり、アルゴリズムであり、独自のミドルウェアであり、ストリーミングパイプラインでもある」というNVIDIAのリアルタイムグラフィックスの技術の結晶といえるソフトウェアで、Drive PX 2とセットで使う。

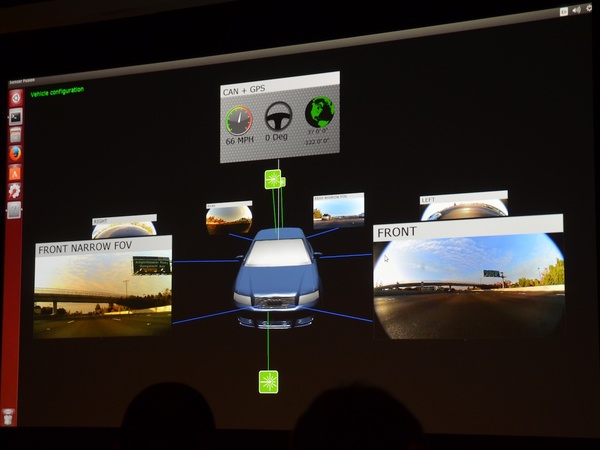

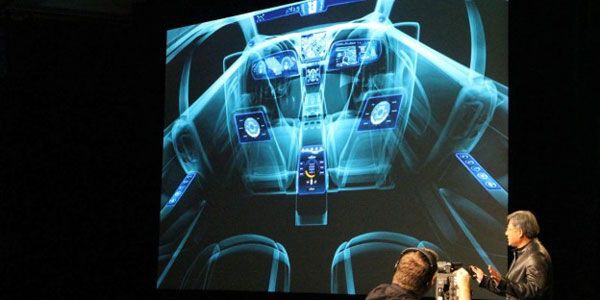

壇上では、6台の標準的な自動車グレードの車載カメラと4基のLIDAR(レーザー検出測距センサー)と、一般的なGPSを搭載したデモカーで環境認識をするプロセスを見せた。つまり、自動運転カーに搭載されるコンピューターの中で何が起こってるか? がわかるデモということになる。

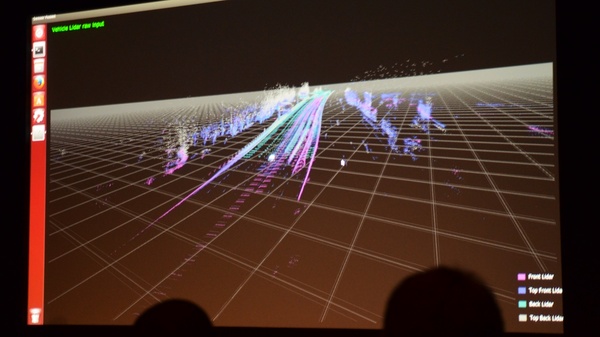

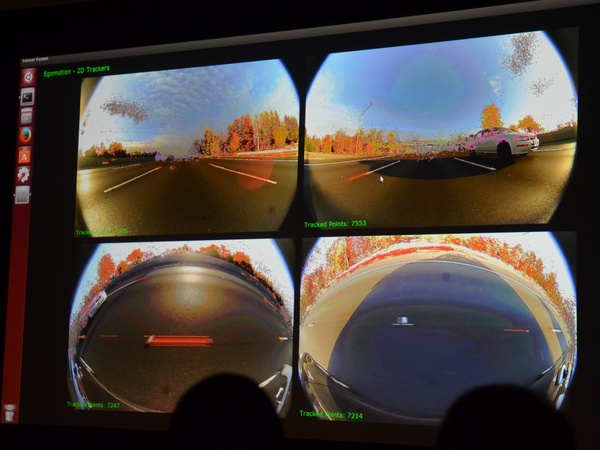

リアルタイムに処理する情報量は、6台のカメラが各100万画素あり、それを1秒間に30フレームで取り込んで処理している。加えて、LIDARのデータは4基合わせて1秒間に160万サンプルに相当するそうだ。

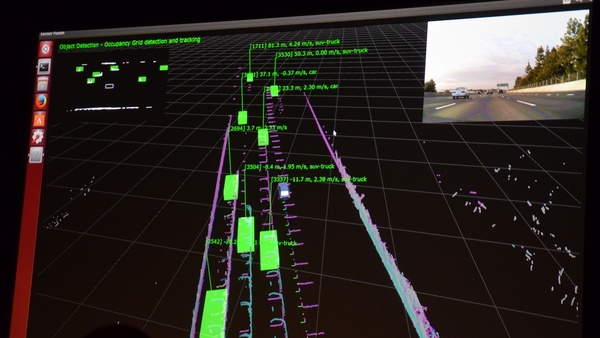

デモではLIDARセンサー1台ずつが認識している空間をそれぞれ見せ、次にそこに魚眼レンズなどのカメラ映像の画像認識やGPSの位置情報など段階を追ってを重ね合わせていく。すると、(かなり端折った説明をすると)車の周囲の環境(奥行きも含めた3D空間)と車両や人物や標識といった対象物を認識する様子が姿を現してくるという仕掛けだ。

我々が自動運転カーのデモ映像で目にする「車の周囲を認識している分かりやすいナビゲーション表示(インフォテイメントシステム)」の裏側には、こうしたリアルタイムの空間認識データが存在しているということになる。

最新の技術では、この精度の環境認識がリアルタイム処理でできるような時代が来てるということに驚く人は多いんじゃないだろうか。

●関連リンク

NVIDIA Accelerates Race to Autonomous Driving at CES(英語)