Midjourneyの生成画像にDepthを加えて背景にしてみた

そして、もう1つのアプローチは、生成した画像データにDepth情報を与えることで、3Dモデルとして扱える情報に変えてしまうというものです。一度3Dモデル化ができれば、ゲーム内で静的に扱うこともできます。

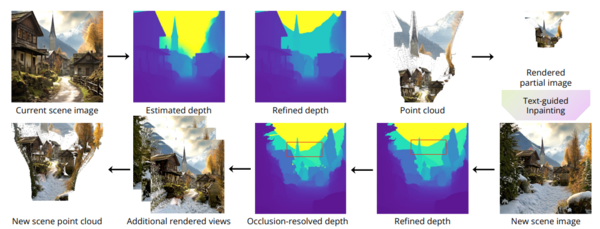

12月にスタンフォード大学とグーグルが発表した「WonderJourney」という研究では、入力されたプロンプトから連続的な3Dシーンを生成することができるとされています。

入力したプロンプトから大規模言語モデル(LLM)を使って関連要素を抽出し、Depth情報を生成。画像を立体化し、カメラ位置を動かしながら、画面に新たに入ってくるものをどんどん追加で生成していく方式です。計算量としてはかなり重いため、まだリアルタイムに動作させることはできませんが、一度生み出した世界であれば動けるようにできる可能性があります。残念ながら一般には未公開の技術なので、検証ができないのですが……。

Depthデータを利用して3Dモデルや3D空間を作ろうというアプローチは現在も続けられています。扱いが比較的簡単なためです。ただ、正面向きの画像からしか生成できないため、表示できる空間には限界があります。

#MidjourneyV6 で生成した画像をMarigoldを使ってDepthを生成、その後、Blenderで3D化。FBXにして #LumePad2 のLeiaViewerで3D表示。とてもしっかり3D立体視で出てる。これをやりたかった。 pic.twitter.com/IH5eAkMxBb

— 新清士@(生成AI)インディゲーム開発者 (@kiyoshi_shin) January 6, 2024

▲筆者が作成した、Midjourneyの画像にDepthデータを生成して、Blenderで3Dモデル化したケース。横顔の情報はないので、左頬は伸びてしまっている

空間をただ横に動くだけなどであればそれでもいいわけですが、移動をさせようと思うと、やっぱりDepthが必要です。そこでDepth情報をなんとかできるかと試してみたところ、今のBlenderの環境でも生成ができてしまいました。もちろん時間はかかりますが、そこも高速化すれば、最終的には立体空間ができてしまいます。

ということで、Midjourneyで生成した画像をもとにDepth情報を作り、3D化して、背景としてUE5に持ち込んでみたケースがこちらです。

#midjourneyV6 で背景も生成して、FBX化して #UE5 で歩けるように環境を整えてみた。Depthは結局は存在しないデータはないので、それなりに動けるようにしようとするとノビノビになってしまう。なので、直接行けない背景だと使えるけど、ゲームにそのまま取り込むのは難しいなあと改めて。 pic.twitter.com/3GbKk3rifp

— 新清士@(生成AI)インディゲーム開発者 (@kiyoshi_shin) January 7, 2024

無理やり引っ張っているので基本的に伸び伸びで、近寄ると非常に粗いんですが、そうしたアプローチを取れることはわかりました。ゲームなどに組み合わせるには使いどころが難しそうですが。

この連載の記事

-

第62回

AI

動画生成AI、映像制作の“民主化”目指して研究進む -

第61回

AI

画像生成AI“児童ポルノ”学習問題、日本では表現規制の議論にも -

第60回

AI

3Dアニメーション技術の革新が止まらない -

第59回

AI

政府、生成AI推進に向けて議論を加速 -

第58回

AI

画像生成AIで同じキャラクターが簡単に作れるようになってきた -

第57回

AI

日本発のリアルタイム画像生成AIサービスが熱い 大手にとっては“イノベーションのジレンマ”に -

第56回

AI

画像生成AIの著作権問題、文化庁議論で争点はっきり -

第55回

AI

動画生成AIの常識を破壊した OpenAI「Sora」の衝撃 -

第54回

AI

画像生成AI、安いPCでも高速に 衝撃の「Stable Diffusion WebUI Forge」 -

第53回

AI

日本発の画像生成AIサービスがすごい 無料アップスケーラー「カクダイV1」 -

第52回

AI

美少女イラスト、AI技術で立体化 ポケットサイズの裸眼立体視ディスプレーが人気に - この連載の一覧へ