Stability AIが画像生成AI「Stable Diffusion」を公開したのは2022年8月のこと。すさまじい勢いで発展してきた画像生成AIの1年を振り返ってみようと思います。

初めに見てもらいたいのは「これが無料でいいのか!? “爆速生成AI”がペイントソフトに革命を起こした」で紹介した、KritaとGenerative AI for Kritaを組み合わせて作成した設定資料的な画像です。

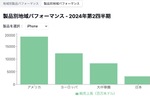

キャラクターの3面図のサンプル。Vroidで簡単な3Dで当たり(左)として、右の画像を作成する。それを元に、プロンプトや画像に描き込んだりして、最終画像を作成していく。2枚目には前面図の頭部のカチューシャや、胸部分のフリルがなかったりするが、そこに色を加筆して、プロンプトで指示すると、最終画像にそれが追加されるのをリアルタイムに確認しながら修正できる(筆者作成)

Stable Diffusionを使って同じキャラクターを多数の方向から作る技法は、今年の前半には確立されてきました。しかし、Stable Diffusionは確率によって画像が生成される仕組みである以上、データの仕上げに向けて何度も出力して修正を重ねる必要があり、とても面倒だったんです。ところが、リアルタイム修正ができるようになったことで、画像に一貫性を持たせたまま修正作業ができるようになりました。

何が言いたいかというと、次々に開発される新技術によって、制作者側が目指す意図に合わせて、狙った画像を作れる余地が広がった1年だったということなんです。

「LoRA」と「ControlNet」の衝撃

まず、去年11月に登場した追加学習技術「LoRA(ローラ)」が普及しはじめたのが今年1月のこと。LoRAは自分が生成したい画像を追加学習させる仕組みです。さまざまなモデルデータが登場し、アニメタッチから実写風まで、様々な画風の画像が登場するようになったのもこの頃です。

当時は画像から画像を生成する「image 2 image」しか制御する方法がなかったため、「AIトレパク」も問題になっていました。ただし、低ノイズimage 2 imageによる模倣のトラブルや、LoRAによる特定画家の画風の模倣の問題はいまだに続いています。

VRoidの公式3Dモデル(左)を低ノイズi2iでアニメ風にした例(右)

(「『AIトレパク』が問題に」より)

2月にはOpenAIのサム・アルトマンCEOが来日。赤松健議員を初めとして、自民党内で生成AIについて本格的に議論されるようになってきたのもこの頃でした。

この頃、画像生成AIにとって何よりも大きかったのがStable Diffusionを様々な方法でコントロールするツール「ControlNet」の登場です。ここから、Stable Diffusionの入力方法としてはテキストプロンプトよりも画像のほうが強力だということが知られるようになってきました。制御という意味では革命を起こしたと言ってもいいですよね。

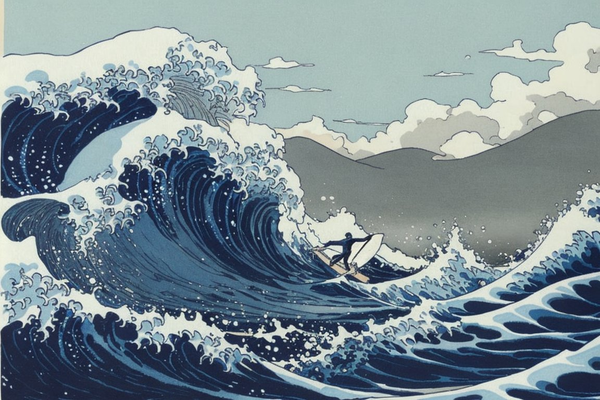

ControlNetの登場により、構図をコントロールしたり、特定のキャラクターの位置を制御して生成できるようになりました。5月にControlNet追加機能「ReferenceOnly」が登場したことで、画風やタッチも制御可能になり、画風は同じだけどまったく違う絵が生成できるようになりました。

葛飾北斎「神奈川沖浪裏」をReferenceOnlyで読み込ませ、サーファーを追加した画像(「画像生成AIに2度目の革命を起こした『ControlNet』」より )

この連載の記事

-

第72回

AI

人が絵を描く“工程”をAIで再現 タイムラプス風動画が炎上した「Paints-Undo」 -

第71回

AI

危機的状況の画像生成AI「Stable Diffusion 3」立て直しへ -

第70回

AI

イラストのペン入れと色塗り、AI使えばわずか1分 -

第69回

AI

AI動画の品質が仕事に使えるレベルになってきた -

第69回

AI

“革命”起こした画像生成AIに暗雲 「Stable Diffusion 3 Medium」の厳しい船出 -

第68回

AI

AIが作る3Dモデルの完成度が上がってきた 毎回異なるモンスターが生成されるゲームも実現か -

第67回

AI

アドビの画像生成AI機能がまた進化 白黒3Dモデルがリアルな都市に -

第66回

AI

有名人そっくり、増え続けるAI音声 “声の権利”どう守る -

第65回

AI

画像生成AIに照明革命 日本と世界で同時に“神ツール”登場 -

第64回

AI

自分好みのAIチャット相手を簡単に作れる「Dify」が面白い -

第63回

AI

まるで“いけない話ができるChatGPT” ローカルAI「Command R+」の爆発的な可能性 - この連載の一覧へ