サーバ仮想化の導入は、サーバのハードウエア削減により短期的にはコストの抑制が期待できる。しかし、日々の運用や将来の拡張まで考慮した長期的なコスト削減効果を維持するには、慎重な検討が必要である。その中でも、ストレージの選定は重要な選定要素となる。今回は、サーバ仮想化環境に有効なストレージのソリューションをいくつか紹介しよう。

ストレージの最適化がサーバ仮想化成功への近道

この数年間、サーバ仮想化技術に対する注目度がさらに高まり、分散しているサーバを仮想化し統合する企業が急増している。サーバ仮想化による統合のメリットは、ハードウェアコストの削減や保守コストの削減、サーバリソースの有効活用、運用管理の効率化などが挙げられる。しかし、単にサーバを仮想化するだけでは、一時的なコスト削減はできても、ITインフラ全体におけるリソースの有効活用や運用管理の効率化は困難である。

それを裏付けるのが、各調査会社やベンダーが行なっているアンケート結果である。どの結果を見てもサーバ仮想化技術を導入したあとに残る課題として、ストレージに関連する内容が上位に挙げられている。その中で特に以下の3つが重大な課題として認識されている。

- ストレージの性能維持

- データ容量増加に対する対応

- バックアップの効率化

これらの内容が課題として挙げられている背景について解説しよう。サーバの仮想化はストレージの共有環境が必須である。サーバやストレージが統合されている環境では、ストレージが多くのサーバに共有される。その結果、ストレージはI/Oの集中により負荷が高まる。したがって、ストレージには高い性能や信頼性が求められることは容易に想像がつくだろう。

また、仮想されたサーバ(仮想マシン)をホストする物理サーバのリソース不足が原因で想定時間内にバックアップ処理が終わらず、日中の業務に影響を与えてしまう場合がある。調査結果からも明らかではあるが、サーバ仮想化後にもこのような状況が依然続いているのだ。サーバだけではなく、増え続けるデータを保存・保護するストレージも最適化して、これらの課題を克服しなければ長期的な仮想化のメリットは享受できないことがおわかりいただけるだろう。

それでは、これらの課題とストレージのソリューションについて順を追って紹介していこう。ここでは、VMwareの製品「vSphere 4」を例に挙げながら解説したい。

重要なアプリケーションの性能を維持するには?

まず、1つ目の課題「ストレージの性能維持」について説明しよう。VMware vSphere 4には、ESXサーバ(仮想マシンをホストする物理サーバ)の負荷分散を行なう「DRS(Distributed Resource Scheduler)」という機能がある。これは、CPUやメモリなどハードウェアリソースの使用状況に応じて、クラスタ化されたESXサーバ上で仮想マシンを別のESXサーバへ自動的(または手動)で移動させ、リソースを分散して利用させるという機能である。一般的に、アプリケーションの性能はハードウェアリソースに大きく依存する。DRSは、ハードウェアリソースの利用を効率化するとともに、アプリケーションの性能維持に対して有効な機能だ。

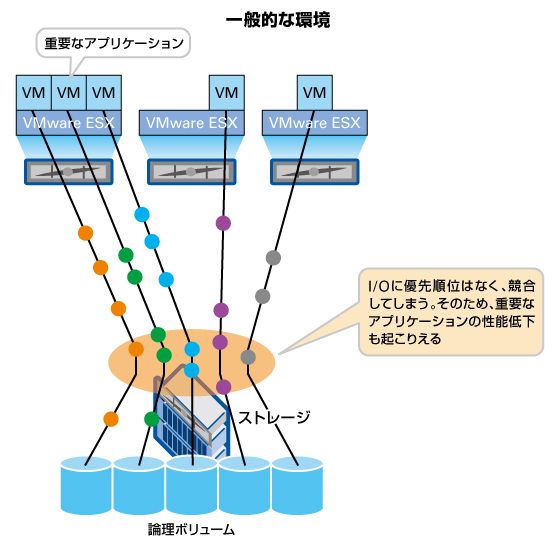

一方、ストレージに目を向けてみよう。まず図1をご覧いただきたい。ストレージは、接続されている仮想マシンのI/Oをすべて処理しなければならない。仮想マシンの台数が増加してストレージに対するI/O負荷が高まれば、ストレージ自体がボトルネックとなり仮想マシン全体のI/O性能が低下する事態に陥りやすくなる。この状況では、重要なアプリケーションの性能を維持するために厳しく性能監視を行ない、有事の際には何らかの対処も必要となってしまう。しかし、これは現実的ではない。

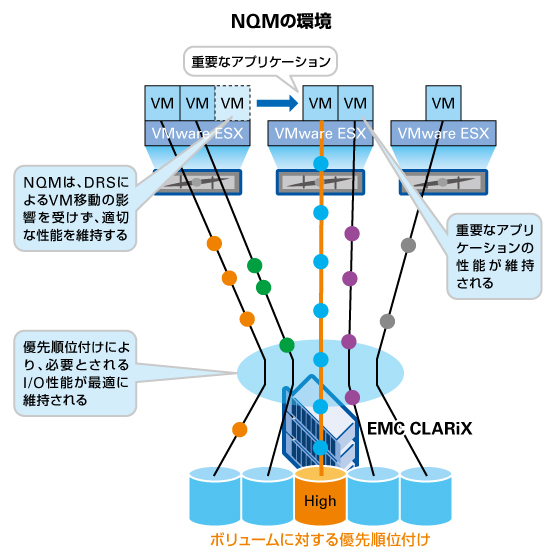

ストレージI/O負荷の高い環境においても、仮想マシンやアプリケーションの性能をストレージI/Oから維持するソリューションが、本連載の5回目で紹介したEMC CLARiXの「NQM(Navisphere Quality of Service Manager)」である。

図2に示した通り、仮想マシンが利用するストレージ上の論理ボリュームに対してNQMでI/Oの優先順位付けを定義することで、ストレージI/Oをコントロールできる。また、DRSによって仮想マシンがESXサーバ間を移動してもNQMは有効に機能する。その結果、I/O負荷が高い状況においても重要なアプリケーションの性能を維持し、より効率的な運用を実現できるのである。

(次ページ、「SANの性能を維持するには?」に続く)

この連載の記事

-

最終回

サーバー・ストレージ

クラウド時代に対応するストレージの最新技術 -

第15回

サーバー・ストレージ

ストレージを守るセキュリティ技術 -

第14回

サーバー・ストレージ

ストレージ管理を効率化するテクニック -

第12回

サーバー・ストレージ

シンプロビジョニングによるストレージ仮想化とは? -

第11回

サーバー・ストレージ

コスト削減を実現するストレージ階層化とは? -

第10回

サーバー・ストレージ

ストレージの災害対策テクノロジー -

第9回

サーバー・ストレージ

バックアップを高速化するレプリケーションの仕組み -

第8回

サーバー・ストレージ

ストレージを使ったバックアップの技術 -

第7回

サーバー・ストレージ

FC/iSCSIとNASの違いを知っていますか? -

第6回

サーバー・ストレージ

ストレージをネットワーク化するFCとiSCSI - この連載の一覧へ