マイクロソフトは4月23日、生成AI向けの小規模言語モデル(SLM)「Phi-3-mini」を発表した。

Phi-3-miniは、パラメーター数が38億の比較的小型軽量な言語モデル。単純なタスクに適しており、特定のニーズに合わせて容易に微調整できる点を特徴とする。スマートフォンや自動車のコンピューター、リモートカメラといったリソースの少ないデバイスでも利用できるほか、オフライン動作にも対応し、ネット接続が困難な地域でも生成AIの恩恵を受けられるという。

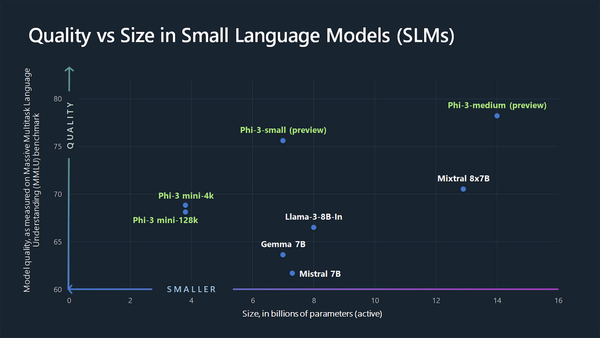

同社が実施したベンチマークテストでは、パラメーター数で勝るメタの「Llama 3-8B-in」(80億)や、グーグルの「Gemma 7B」(70億)に対して、より優れた性能を発揮。特にLlama 3に関しては、4月18日のリリースからわずか5日でPhi-3-miniに追い越される形となった。

ただしPhi-3-miniも万能ではなく、広範な推論や迅速な応答が必要となるケースでは、パラメーター数の多い本格的な大規模言語モデル(LLM)の方が優れている。

マイクロソフトのAI担当副社長Luis Vargas氏も「一部の顧客は小型モデルのみを必要とするかもしれませんが、一部の顧客は大型モデルを必要とし、多くの顧客はさまざまな方法で両方を組み合わせたいと考えているでしょう」と述べ、ニーズに合わせてSLMとLLMを使い分ける形が現実的との見方を示している。

4月23日現在、Phi-3-miniは同社の「Azure AIモデルカタログ」、AIモデルプラットフォーム「Hugging Face」、ローカル環境向けフレームワーク「Ollama」などで利用可能。同社は今後、パラメーター数70億の「Phi-3-small」、同140億の「Phi-3-medium」も公開予定だ。

※訂正:パラメーターの桁数に誤りがあったため訂正しました。(4月25日8時29分)