呪文や画像から音楽を自動生成

グーグルの研究部門Google Researchは1月26日(現地時間)、「ディストーションギターをバックに流れる落ち着いたバイオリンの旋律」といったテキストから新たな音楽を自動生成するAIモデル「MusicLM」の論文とデモページを発表。ただし一般公開する予定はないという。

論文によるとMusicLMは、条件付き音楽生成プロセスを階層的な配列間モデリングタスクとして捉えることにより、24kHzで数分間に渡って一貫性のある音楽を生成することに成功したという。

呪文(プロンプト)は、「melodic techno」、「swing」といったジャンル名や「grand piano」、「flute」といった楽器名、「club in the 80s」、「street performance」といった場所や年代、などのシンプルなもののほか、「レゲトンとEDMを合体させた、スペイシーで別世界のようなサウンド。宇宙に迷い込んだような体験を誘発し、不思議な感覚と畏敬の念を呼び起こすような音楽でありながらもダンサブル」といった複雑なものまで利用できる。

また、「瞑想」>「起床」>「運動」>「覚醒」の4パートを各15秒のパートで表現した組曲的なものを作成したり。「beginner piano player(ピアノ初心者)」と「crazy fast professional piano player(超絶プロピアニスト)」のようにテクニックの優劣を指示したりすることもできる。

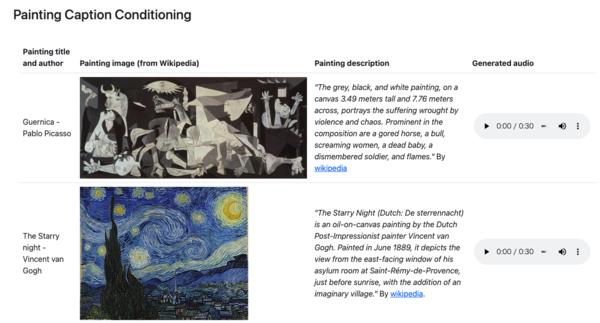

さらに呪文にはテキストだけではなく、音楽や画像を含めることも可能。たとえば鼻歌のメロディーをギター、ピアノ、オペラ歌手といった別の楽器で演奏させたり、ダリの代表作「記憶の固執」にインスパイアされた音楽を生成することも可能なのだ。

曲というよりは曲の断片

肝心の出来栄えだが、「guitar」や「piano」といった楽器や音色に関するものは概ね再現できているが、やはりあくまで曲の断片であり、1曲まるごと作曲という粋には達していない。とくにボーカルやラップなどの歌詞はデタラメであり、あくまで雰囲気を模倣してみたというレベルだ。

また、「big beat」、「trap hip hop」など一部のジャンル名から生成されたものの中には首を捻らざるを得ないものもある一方、「east coast hip hop」や「grunge」など、「あれ?これ誰の曲だっけ?」と考えてしまうほど“らしい”曲もいくつかあった。試しにそれを「Shazam」に聞かせてみたところ反応しなかったので、まちがいなくAIが作ったオリジナル(?)曲である。

学習データは公開中

MusicLMは、「high pitched female vocal melody(高音の女性ボーカルメロディー)」といった音色や楽器名などを記述したアスペクトリストと、「A low sounding male voice is rapping over a fast paced drums playing a reggaeton beat along with a bass. (レゲトンビートを奏でる速いテンポのドラムとベースの上で、低い音の男性の声がラップしている)」といったアーティストによって書かれたフリーテキストのキャプションでラベル付けされた、5521個のYouTube動画から取得された音楽サンプルで学習されている。音楽サンプルのデータセットは「AudioSet」、ラベル付け用キャプションのデータセットは「MusicCaps」という名前でそれぞれグーグルから公開されている。

論文によるとMusicLMは音質と正確性の両方において、従来のシステムを凌駕しているが、トレーニングデータに存在する文化的バイアスや、学習に使われたオリジナル楽曲の著作権侵害といったリスクが存在し、生成した楽曲の1%に近似的一致(オリジナルの模倣)が確認できたとしている。

他のAIモデル同様にグーグルは慎重姿勢を崩しておらず、現時点でモデルを一般公開する予定はないとしているが、Youtube動画のBGMなど著作権をクリアした楽曲データのニーズは高いため、安全な運用が期待される分野だ。