ロードマップでわかる!当世プロセッサー事情 第590回

Radeon Instinct MI100が採用するCDNAアーキテクチャーの内部構造 AMD GPUロードマップ

2020年11月23日 12時00分更新

メモリーはHBM2Eを採用

入手性に困難もなく妥当な選択

ダイの話はもう少し後にして、メモリーについて説明しよう。メモリーそのものはHBM2であるが、従来のHBM2ではなく、転送速度を2.4Gbpsに引き上げたHBM2Eが採用された。JEDECは2018年12月にJESD235を発表(最新はJESD235C)しており、最大でピンあたり2.4Gbpsとなったほか、最大で12スタックまでの積層が可能になっている。

HBM2Eについては今年2月にSamsungが量産開始を発表、7月にはSK HYnixも量産開始をアナウンス、Micronもすでに製品を提供中である。

したがって入手性には困難はなく、妥当な構成と言える。余談ながらNVIDIAも、HBM2Eの8スタックでスタックあたり16GB、トータルで80GBの容量となるNVIDIA A100 80GBを発表している。実際I/Fが2.4Gbpsに対応できれば、後はHBM2を入れ替えるだけで実装できるため、これは妥当な選択である。ひょっとすると今後AMDも64GBメモリー搭載のRadeon Instinct MI100を投入しても不思議ではない。

XGMI Linkを3つに増やして

I/F周りを276GB/秒に引きあげる

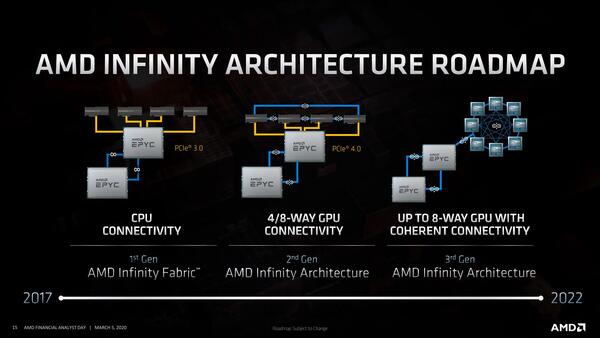

次にI/F周り。Radeon Instinctのインターコネクト(というよりインフィニティーファブリック)のロードマップは今年3月に公開されており、すでに現状のRadeon Instinct MI50/60で、ここで言う第2世代に対応しているのだが、CNDA 1.0でもまだこの第2世代の構成となる。つまり4枚のRadeon Instinct MI100をブリッジカードで接続できる格好だ。

ただし、Radeon Instinct MI50/60ではこのブリッジカード経由で184GB/秒での接続が可能だったが、Radeon Instinct MI100ではこれが276GB/秒に引きあがった。

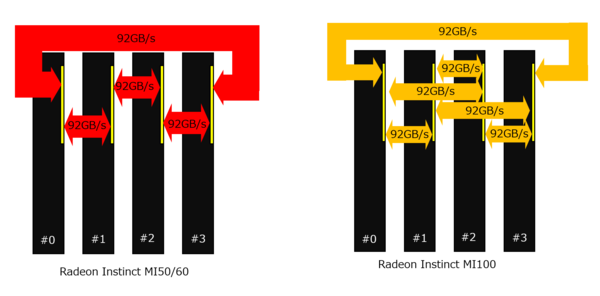

これはなにか? というと、Radeon Instinct MI50/60では23GT/秒の16bit幅で92GB/秒の帯域を持つXGMI Linkを2つ持つ。これを利用して4枚のRadeon Instinctを下図の左側のように接続する形だ。

対してRadeon Instinct MI100ではLinkの速度そのものは同じながら、XGMI Linkが3つに増やされた。このため、図の右側のようにすべてのRadeon Instinct MI100ボード同士が1:1で直接接続されるようになっている。

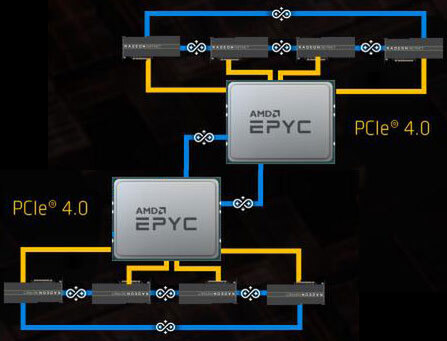

ちなみにEPYC1つに4つまでRadeon Instinctを接続できるので、2 SocketのEPYCだと8枚までRadeon Instinctを装着できることになる。

この連載の記事

-

第768回

PC

AIアクセラレーター「Gaudi 3」の性能は前世代の2~4倍 インテル CPUロードマップ -

第767回

PC

Lunar LakeはWindows 12の要件である40TOPSを超えるNPU性能 インテル CPUロードマップ -

第766回

デジタル

Instinct MI300のI/OダイはXCDとCCDのどちらにも搭載できる驚きの構造 AMD GPUロードマップ -

第765回

PC

GB200 Grace Blackwell SuperchipのTDPは1200W NVIDIA GPUロードマップ -

第764回

PC

B100は1ダイあたりの性能がH100を下回るがAI性能はH100の5倍 NVIDIA GPUロードマップ -

第763回

PC

FDD/HDDをつなぐため急速に普及したSASI 消え去ったI/F史 -

第762回

PC

測定器やFDDなどどんな機器も接続できたGPIB 消え去ったI/F史 -

第761回

PC

Intel 14Aの量産は2年遅れの2028年? 半導体生産2位を目指すインテル インテル CPUロードマップ -

第760回

PC

14nmを再構築したIntel 12が2027年に登場すればおもしろいことになりそう インテル CPUロードマップ -

第759回

PC

プリンター接続で業界標準になったセントロニクスI/F 消え去ったI/F史 -

第758回

PC

モデムをつなぐのに必要だったRS-232-CというシリアルI/F 消え去ったI/F史 - この連載の一覧へ