シーンごとにプロンプトを書ける新バージョンも

一方で、本家の開発が止まっている間に、別の系統からもAnimateGiffの移植が出てきています。

「Github(ギットハブ)」は、公開されているコードを誰もが改造して再公開できる仕組み。腕がある人なら、オリジナルのソースを解析し、機能追加版を派生バージョンとして公開できます。そうして公開されたのがnegglesさんの「AnimateDiff-cli」と、それをさらに拡張したs9roll7さんの「Animatediff-cli-prompt-travel」でした。

AnimateDiff-cliは、動作に必要なビデオメモリー消費量を16GBから8GBまで圧縮したバージョン。Animatediff-cli-prompt-travelは、生成する画像に対し、フレームごとに細かなプロンプトを設定して、各シーンの内容を指定できるというものでした。

実際に、この方法論を試されたAsakiさんは、0〜19フレームを「悲しい」、20〜39フレームを「目を閉じる」といった形で、統一したキャラクターを6秒間の動画を生成することに成功しています。

AIアニメーション Text2Video(文章のみから生成)

— Asaki (@Morning_wood17) August 23, 2023

AnimateDiff prompt travel で適用するプロンプトをフレームの途中で変更して動画の内容をコントロール

なんかローカルで環境構築したら生成速度が3倍くらいになって比較的長めの動画も一回で生成できるようになった #AnimateDiff#aianimationpic.twitter.com/54THG1GP2i

ただし現状はJSONフォーマットのコードを書かなければならず、使用時のハードルがあります。今後は使いやすいUIの登場を期待したいところです。

AnimateDiffのユーザーグループで議論が活性化

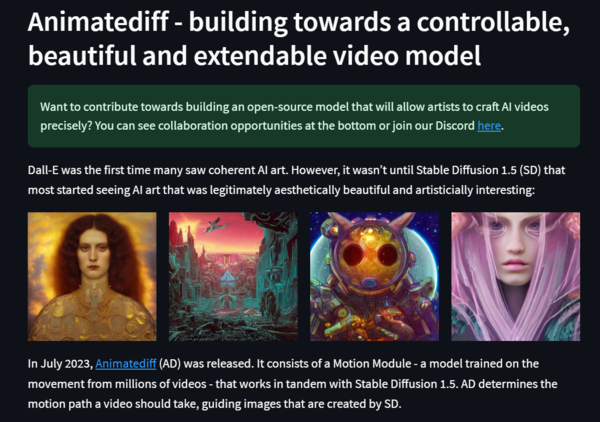

そんななか、AnimateDiffの技術に高い可能性を見出しているユーザーグループが登場しつつあります。そのひとつである「Banodoco」グループでは、AnimateDiffの特徴なるポイントを6つ上げています。

- ベースモデル/アプローチにより、美しいが範囲を理解できる限定的な結果をもたらす

- 非常にコントロールしやすく、拡張可能であることの強力な証拠が作られている

- 微調整で問題を解決できる証拠が作られている

- Stable Diffusionのエコシステムの上に構築されるため、ビルドが非常に容易である

- ベースモデルを使ったアプローチがスケールできるという証拠がいくつもある

- コミュニティの信念による成長

課題としては、ソースを非公開で開発する商用で動画生成サービスとの競争で不利になるのではという懸念や、まだまだ要求するスペックが高いこと、そもそものムービーモジュールの完成度に限界があることなどが挙げられています。それでも非常に高い可能性があるという議論を展開したうえ、結論では「Stable Diffusion初期はおもちゃのように見えていたけれども、AnimateDiffのようなすごいものができるような兆しが出てきているんじゃないか」と高らかにうたいあげています。

この連載の記事

-

第146回

AI

ローカル音楽生成AIの新定番? ACE-Step 1.5はSuno連携で化ける -

第145回

AI

ComfyUI、画像生成AI「Anima」共同開発 アニメ系モデルで“SDXL超え”狙う -

第144回

AI

わずか4秒の音声からクローン完成 音声生成AIの実力が想像以上だった -

第143回

AI

AIエージェントが書いた“異世界転生”、人間が書いた小説と見分けるのが難しいレベルに -

第142回

AI

数枚の画像とAI動画で“VTuber”ができる!? 「MotionPNG Tuber」という新発想 -

第141回

AI

AIエージェントにお金を払えば、誰でもゲームを作れてしまうという衝撃の事実 開発者の仕事はどうなる? -

第140回

AI

3Dモデル生成AIのレベルが上がった 画像→3Dキャラ→動画化が現実的に -

第139回

AI

AIフェイクはここまで来た 自分の顔で試して分かった“違和感”と恐怖 -

第138回

AI

数百万人が使う“AI彼女”アプリ「SillyTavern」が面白い -

第137回

AI

画像生成AI「Nano Banana Pro」で判明した“ストーリーボード革命” -

第136回

AI

画像生成AIの歴史を変えたNano Banana “一貫性の壁”が突破された2025年を振り返る - この連載の一覧へ