原画と原画の間にあたる画像を複数枚入れることで、自然な連続性のある動きを作る。アニメの基本となる「中割」作業を画像生成AIが実現する可能性が出てきました。鍵になっているのは「AnimateDiff」という技術。8月に入って、様々なユーザーのアップデートによって機能拡張が進められています。それは完全な画像生成AIで作られるアニメの可能性を垣間見せるほどのものです。

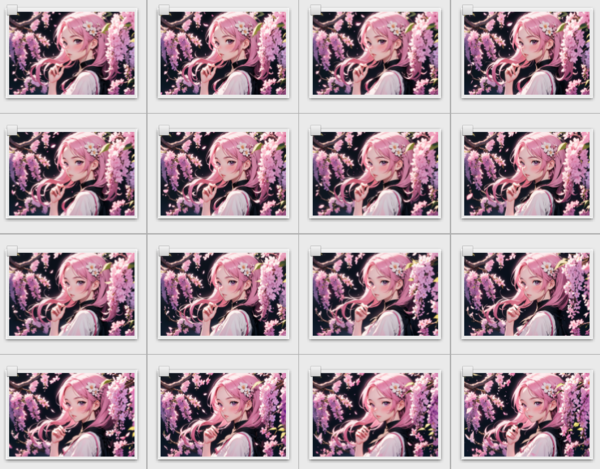

16コマ/2秒の短い動画が生成できる

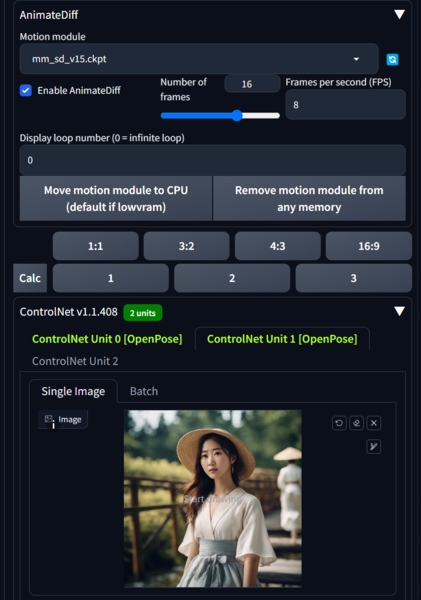

AnimateDiffは7月10日に発表された、上海AIラボ、香港中文大学、スタンフォード大学の共同研究による技術。画像生成AI「Stable Diffusion」の仕組みとデータセットを利用しつつ、数百万本の動画を学習させた「モーションモジュール」と呼ばれるデータセットを別途に参照させることで、連続するキャラクターの動きを生成可能にするというのが基本原理です。生成できる時間は、16コマ/2秒が基本。それ以上になると破綻しやすいという弱点もあるのですが、短時間ながら画像生成AIによって連続するアニメーションが作成できるということ自体が画期的だったのです。

研究の発表と同時に、クラウドサービス「Google Colab」で使えるバージョンが登場しましたが、1週間後にはStable DiffusionをローカルPCで動かすための動作環境「WebUI A1111」の拡張機能として使えるバージョンを有志が開発したことで注目されました。しかし、Stable Diffusion版は画像が色あせした状態でしか出力されないとか、長文のプロンプトを使うと機能しない上、途中で別のコマに替わってしまうといった様々なバグがあったんです。その改善もなく事実上開発が止まっていた状態になっていて、いまひとつ可能性が引き出せないということで焦らされていた状態でした。

そんななか、注目されたのがTDSさんによる改造版AnimateDiffです。

「Stable Diffusion向けAnimateDiff」改造版が登場

TDSさんはもともとStable Diffusionの「ControlNet」機能を利用することで、アニメーションの中割をする技術の模索を試されていた方でした(ControlNetについての記事はこちら)。画像のスタートと終わりを指定し、その途中の変化を画像生成AIに生成させようという方法です。

ControlNetのtileを使って動画を作るテストです

— TDS (@TDS_95514874) July 13, 2023

2つの画像をt2iで生成→シードを右上の物に固定し、右下の画像をtileモードで入力して適用度を上げていくと、右上から右下に向かって画像が徐々に変形していきます#aiart#stablediffusionpic.twitter.com/LugeCIM4Uh

▲画像の最初と最後の画像に、ControlNetにTileの重み付けを変えて生成することで、アニメーションに見える画像を作り出す実験例

OpenPose Wingのテスト

— TDS (@TDS_95514874) July 22, 2023

途中のサンプリングまでCN OpenPoseを入れて、後半は適用を止めます

Reference等を併用して、翼に分化させます#StableDiffusionpic.twitter.com/Iv2lB4bSk0

▲ControlNet OpenPoseを利用することで、天使の羽が羽ばたいているアニメーションを作り出している

そして8月21日に大きなブレイクスルーをもたらしたのが、AnimateDiffのソースコードを改造して、最初と最後の画像を指定して18フレームの画像を生成できる仕組みを作り上げたことでした。

AnimateDiffに二枚の画像を入力して、ある程度狙い通りの動画を作れます

— TDS (@TDS_95514874) August 20, 2023

ControlNet tileからの制御テンソルを最初と最後のフレームに限定して適用しています#aiartpic.twitter.com/fbQpzYEqve

さらに、色あせ問題を修正したバージョンも8月24日に公開。WebUI A1111環境で、高画質の画像を生成することができるようになったのです。

Webui版のAnimatediffで彩度が落ちる、色むらやノイズが出る等の現象を改善しました

— TDS (@TDS_95514874) August 26, 2023

diffusers版のノイズスケジュールに合わせるとマシになるようです#aiart#animatediffpic.twitter.com/Rj8ItGdeUU

現状はカスタムのプログラムコードを組み込む形になっていますが、本家への統合を求めているということ。いずれそれらの機能が正式に反映されるようになるのではないかと思います。

この連載の記事

-

第61回

AI

画像生成AI“児童ポルノ”学習問題、日本では表現規制の議論にも -

第60回

AI

3Dアニメーション技術の革新が止まらない -

第59回

AI

政府、生成AI推進に向けて議論を加速 -

第58回

AI

画像生成AIで同じキャラクターが簡単に作れるようになってきた -

第57回

AI

日本発のリアルタイム画像生成AIサービスが熱い 大手にとっては“イノベーションのジレンマ”に -

第56回

AI

画像生成AIの著作権問題、文化庁議論で争点はっきり -

第55回

AI

動画生成AIの常識を破壊した OpenAI「Sora」の衝撃 -

第54回

AI

画像生成AI、安いPCでも高速に 衝撃の「Stable Diffusion WebUI Forge」 -

第53回

AI

日本発の画像生成AIサービスがすごい 無料アップスケーラー「カクダイV1」 -

第52回

AI

美少女イラスト、AI技術で立体化 ポケットサイズの裸眼立体視ディスプレーが人気に -

第51回

AI

“生成AIゲーム”急増の兆し すでに150タイトル以上が登録 - この連載の一覧へ