Stable Diffusionでどんな画像も「立体」に

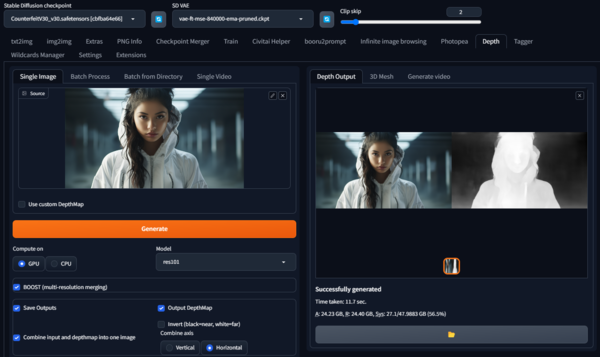

設定は簡単です。Stable DiffusionのDepth Extentionを選択後、「Combine input and depthmap into one image」のボタンをチェックして画像を生成。これをLooking Glass Portraitに持ち込むだけで立体視として見られます。実写風の画像から、アニメ風の画像まで、何でも立体視で見られるようにしてくれます。

この面白さを誌面で伝えるのは難しいのですが、画像単体では感じられない実在感が一気に増します。Stable Diffusionでかわいい女の子を作っているような人はたくさんいると思いますが、その画像からさらに手軽に実在感を感じられるようにする方法としては素晴らしいものです。

Stable DiffusionのDepth Extensionを使って、Midjourneyで生成した画像に、深度情報を追加生成した画像(右)。生成した画像をLooking Glassの画像管理アプリにドラックアンドドロップするだけで、立体として表示される(筆者作成)

さらに、拡張機能のDepthは動画にも適用できます。たとえば、動画生成AIのRunway「Gen-2」で生成した動画を「Single Video」タブに設定して生成すると、Depthを追加した動画を生成してくれます。生成されたAVIをMP4に変換する作業は別途必要になりますが、Looking Glass Portrait上で見られるようになります。ただし、ビデオメモリーは12GB以上、NVIDIA GeForce RTX 4090でも4秒の動画を生成するのに7分あまりかかり、それなりにスペックは要求されます。

Looking GlassもDepthサービス、しかしStable Diffusionのほうが精度は上

Looking Glassはいま、これらの技術をウェブ用に展開した「Looking Glass Blocks」というサービスを展開しようとしています。

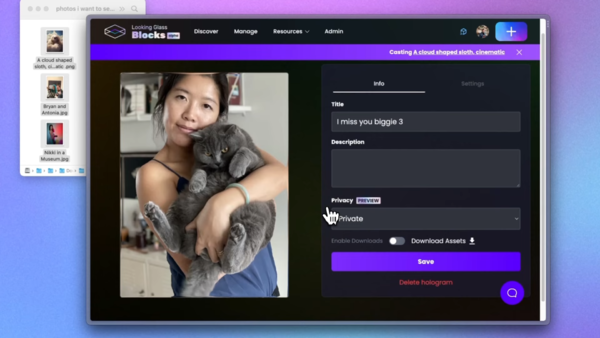

半年前からQuiltには対応していましたが、8月24日に、2Dの写真をアップロードすると、新たに自動で深度情報付き画像に変換して表示してくれるという機能が付きました。擬似的な3DをSNSなどで簡単に共有することができるのがメリットです。現在は月に20枚まで無料で使えます。また、アップした画像はLooking Glass Portraitにボタンひとつで表示可能。将来的には、このアップロード枚数の部分に課金要素を絡めてくるのだろうと予想しています。

ただ、現状の深度情報の生成には古いアルゴリズムが使われているようで、Stable Diffusionに搭載されているものに比べると見劣りがするのが正直なところ。この点には改善を求めたいところです。

https://blocks.glass/sakugetu/9156

▲冒頭の画像をBlocksにアップしたもの

https://blocks.glass/sakugetu/9153

▲筆者がMidjourneyで生成した画像をBlocksにアップロードしたもの

この連載の記事

-

第144回

AI

わずか4秒の音声からクローン完成 音声生成AIの実力が想像以上だった -

第143回

AI

AIエージェントが書いた“異世界転生”、人間が書いた小説と見分けるのが難しいレベルに -

第142回

AI

数枚の画像とAI動画で“VTuber”ができる!? 「MotionPNG Tuber」という新発想 -

第141回

AI

AIエージェントにお金を払えば、誰でもゲームを作れてしまうという衝撃の事実 開発者の仕事はどうなる? -

第140回

AI

3Dモデル生成AIのレベルが上がった 画像→3Dキャラ→動画化が現実的に -

第139回

AI

AIフェイクはここまで来た 自分の顔で試して分かった“違和感”と恐怖 -

第138回

AI

数百万人が使う“AI彼女”アプリ「SillyTavern」が面白い -

第137回

AI

画像生成AI「Nano Banana Pro」で判明した“ストーリーボード革命” -

第136回

AI

画像生成AIの歴史を変えたNano Banana “一貫性の壁”が突破された2025年を振り返る -

第135回

AI

実在感が恐ろしいレベル 画像生成AIの常識をひっくり返した「Nano Banana Pro」 -

第134回

AI

“AI読者”が小説執筆の支えに 感想を励みに30話まで完成 - この連載の一覧へ