2021年に個人的に入手したガジェット類でとても気に入っており、いまだに使い続けているハードがあります。米Looking Glassの「Looking Glass Portrait」です。それはStable Diffusionとの組み合わせによって、その潜在能力が大きく広がったためです。

Stable DiffusionがLooking Glassの可能性を広げた

Looking Glass Portraitは、「ライトフィールド」と呼ばれる裸眼立体視を実現する同社の第2世代ディスプレー。第1世代に比べて、軽量化されたとともに表示領域が広がっています。3Dモデルを45~100通りの角度から見た画像に表示して、屈折レンズを通じ、そのうちの一枚を見ることによって立体感を実現。これにより、VRゴーグルなどを被らなくても、ディスプレー上で立体視ができる仕組みになっています(レンチキュラーレンズ)。

日本ではKickstarterを通じて大きな評判になっていたのですが、出荷時期にはコロナ禍の影響が直撃。半導体不足の影響を受けて出荷時期は当初予定よりも10ヵ月以上遅れ、イベントが自粛された影響で多くの人が直接見る機会が少ない状況でした。そのためクチコミも起こらず、大きな話題となることはありませんでした。なにせ、裸眼立体視のすごさは直接見ないと、その面白さがまったく伝わらないのです。そのため、初期に入手した人たちのなかには、商品は届いたけど一度も開封しないままという人も多いのではないでしょうか。

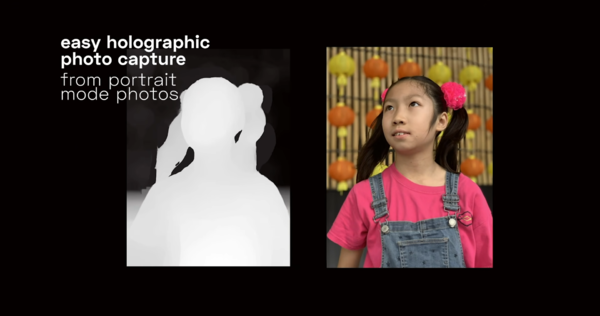

そんなLooking Glass Portraitでは非常に重要な機能が追加されました。深度情報(Depth)データと組み合わせれば裸眼立体視ができるようになったのです。たとえば、iPhone X以降のポートレートモードで撮影した画像は深度情報を持っているため、そのデータをLooking Glass Portraitに持ち込むと、立体写真を楽しめます。「Portrait」と名付けられた製品は、パーソナルな子供の写真などを記録などに残せるといったことを製品の売りとしていました。

このデータフォーマットが登場する以前は、「Quilt」と呼ばれる12~48枚の角度が違うカメラで撮影した画像を作る必要がありました。特によく使われていたのが、Unity内にプラグインで複数の画像を同時に撮影するカメラを設置して、リアルタイムに3Dキャラクターを表示させるといった手法です。立体視できるキャラクターとインタラクションできるというのは面白いのですが、手軽さはそれほどでもないという弱点がありました。

その点、2D画像と深度情報の組み合わせは手軽に扱えます。Looking Glassでも、1枚あたり0.2ドルで2D画像を立体視用に変換するサービスを展開していました。

2D画像から深度情報を検出する技術は、機械学習の効果が出やすいことが発見されたため、近年急激に研究が進んでいる分野です。

メタやグーグル、マイクロソフト、アドビといった大企業も精力的に研究をしていますが、特に画期的な研究として知られているのは2020年にドイツの研究者が発表した「MiDaS」という方式。複数の生成方式を組み合わせ、きれいな深度画像を作り出す方法です。オープンソースで公開されていることもあり、多くのサービスに組み合わされるようになりました。

このMiDaSを使った奥行き情報の生成機能が、昨年12月にStable Diffusionの拡張機能として登場しました。最新の研究の生成モデルも追加されており、一気に深度画像の生成が簡単になったのです。

この連載の記事

-

第144回

AI

わずか4秒の音声からクローン完成 音声生成AIの実力が想像以上だった -

第143回

AI

AIエージェントが書いた“異世界転生”、人間が書いた小説と見分けるのが難しいレベルに -

第142回

AI

数枚の画像とAI動画で“VTuber”ができる!? 「MotionPNG Tuber」という新発想 -

第141回

AI

AIエージェントにお金を払えば、誰でもゲームを作れてしまうという衝撃の事実 開発者の仕事はどうなる? -

第140回

AI

3Dモデル生成AIのレベルが上がった 画像→3Dキャラ→動画化が現実的に -

第139回

AI

AIフェイクはここまで来た 自分の顔で試して分かった“違和感”と恐怖 -

第138回

AI

数百万人が使う“AI彼女”アプリ「SillyTavern」が面白い -

第137回

AI

画像生成AI「Nano Banana Pro」で判明した“ストーリーボード革命” -

第136回

AI

画像生成AIの歴史を変えたNano Banana “一貫性の壁”が突破された2025年を振り返る -

第135回

AI

実在感が恐ろしいレベル 画像生成AIの常識をひっくり返した「Nano Banana Pro」 -

第134回

AI

“AI読者”が小説執筆の支えに 感想を励みに30話まで完成 - この連載の一覧へ