ロードマップでわかる!当世プロセッサー事情 第617回

AMDとNVIDIAがPerlmutterを当初のタイムライン通りに納入 スーパーコンピューターの系譜

2021年05月31日 12時00分更新

スーパーコンピューターの系譜

Perlmutterが稼働開始

ということで今週の本題は、米国立エネルギー研究科学計算センター(NERSC)のPerlmutterである。Perlmutterは連載510回でまず概略を、その後連載597回や連載608回で断片的に情報を紹介したが、こちらの運用が始まったという発表が米国時間の5月27日にあった。すでにPerlmutterのサイトも公開されている。

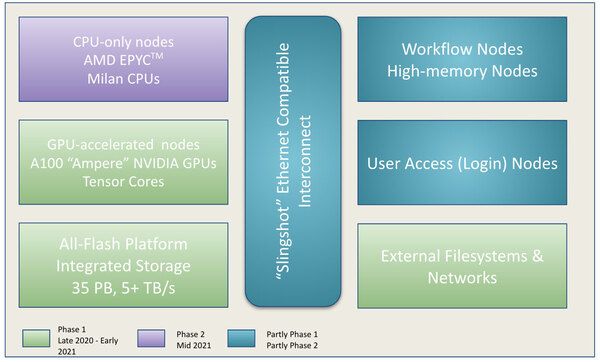

今回導入されたのはフェーズ1と呼ばれるCPUとGPU混載のノードである。もともとPerlmutterではCPU Only NodeとCPU+GPU Nodeの2種類があるという話は以前紹介した通りであるが、フェーズ1ではこのCPU+GPU Nodeの設置を行なう。フェーズ2は今年後半に運用開始になる予定で、こちらはCPU Only Nodeの設置となる。

ちなみに構成であるがフェーズ1では以下が設置される。

| フェーズ1で設置されるノード数 | ||||||

|---|---|---|---|---|---|---|

| GPU-accelerated compute node | 1536ノード/12キャビネット | |||||

| ログインノード | 15ノード | |||||

GPU-accelerated compute nodeはAMD EPYC 7763+NVIDIA A100×4という構成で、CPUとGPUはPCI Express Gen4で、GPU同士はNVLink 3で、外部へのNICはPCI Express Gen3で接続という構成である。メモリー容量は1ノードあたり256GBとされている。

GPU-accelerated compute nodeの構成。Workflow NodeやHigh-memory Nodeの詳細は不明。CPU-only nodesにいろいろバリエーションを追加するのかもしれない

このGPU-accelerated compute nodeが2つ、1本のCompute Bladeというシャーシに収まる格好になる。1本のキャビネットは8つのセグメントに分割され、各々のセグメントには8枚のCompute Bladeと4枚のSwitch Blade(これはネットワークスイッチ)が搭載されるので、合計するとキャビネットあたり64 Compute Blade、128ノードのGPU-accelerated compute nodeが内蔵される格好になる。

フェーズ1はこれを12キャビネット並べるので、トータルすると1536ノードとなり、AMD EPYC 7763が1536個とNVIDIA A100が6144枚装着されることになる。

もっともプレスリリースを確認すると、AMDの方は「1536ノードにおのおのEPYC 7763が1つずつインストールされる」という表現でこれはいいのだが、NVIDIAの方を見ると、“6159 NVIDIA A100 Tensor Core GPUs in Perlmutter”と書いてあり、差の15枚はどこから出てきた? という謎な結果になっている。

おそらくは冗長ノードがいくつか用意されているほか、交換用にも何枚か提供された結果が15枚というあたりなのではないかとは思うが、これに関する詳細は明らかになっていない。

これと別にログインノードが15ノード用意されるが、こちらは1ノードあたり2つのEPYC 7742が搭載され、512GBメモリーと960GBのローカルストレージが搭載されている。こちらは名前の通り、利用者がログインして作業するマシンで、このログインノードからPerlmutterにジョブを投げるイメージになるかと思う。

これに続いて導入されるのがフェーズ2であるが、こちらは同じ米国立エネルギー研究科学計算センターのCoriを置き換えるシステムである。

以前も書いたが、CoriはXeon Phiをベースとしたシステムで、HaswellベースのXeon E5-2698 v3ベースが14キャビネット/2388ノードと、Knight LandingベースのXeon Phi 7250ベースが54キャビネット/9688ノード用意され、合計で32.3PFlopsの演算性能(ピーク値)を発揮するというものだった。

ところがXeon Phiの製品ラインそのものの廃止にともない、ここで動いていたアプリケーションを通常のx64ベースで稼働させる必要が出てきたため、これをフェーズ2でカバーする形となる。

フェーズ2はノードあたり2つのGen 3 EPYC(型番は不明)に512GBメモリーを組み合わせる構成で、フェーズ1と同じく1536ノード(=EPYCが3072個)となっている。もしフェーズ2も同じくAMD EPYC 7763で構成されるとすると、FP64での理論上のピーク性能は7.8PFlopsほどになる計算である。

フェーズ1の方は、FP64はCPUが3.9PFlops、GPUが59.9PFlopsで、合計60PFlops超ということで、Coriのほぼ2倍といったところ。ただXeon Phiはピーク性能を出すのが非常に困難な、ピーキーなカードだったことを考えると、実効性能で言えばアスキーの記事で触れられていた「現在NERSCで利用可能な計算能力の4倍を達成すると期待」されるのも妥当な気がする。

ちなみにフェーズ2が完成すると、合計の演算性能は71.6PFlops(FP64)で、仮に演算効率が100%だとしても昨年11月のTOP500のリストで言えば37位くらい、効率が80%程度だとすれば50~51位あたりになる計算で、絶対性能という点では大きなインパクトはない。

ただAMDのMilanベースのEPYCや、NVIDIAのA100を搭載した初のHPCマシンという意味では大きなマイルストーンである。もっと言えば、AMDとNVIDIAはこれを当初のタイムライン通りに納入したということが非常に大きなポイントである。

AMDはこれに続きオークリッジ国立研究所にFrontierの納入をやはり今年からスタートするし、来年にはEl Capitanへの納入もスタートする。

対するインテルは、同じく今年中に納入を始める予定だったAuroraが予想通り遅れており、それもあって「Ponte VecchioをNVIDIAのGPUに変えた方がいいんじゃないか」というような記事が昨年登場していたが、確かにNVIDIAの好調ぶりを見ているとそれもうなずける。

ただ、GPUだけでなくCPUのSapphire Rapidsも本当に今年中にリリースされるか疑わしいという状況では、GPUだけ交換しても意味がないという話もある。このあたり、年末あたりにはもう少しはっきり状況が見えてくるだろう。

この連載の記事

-

第768回

PC

AIアクセラレーター「Gaudi 3」の性能は前世代の2~4倍 インテル CPUロードマップ -

第767回

PC

Lunar LakeはWindows 12の要件である40TOPSを超えるNPU性能 インテル CPUロードマップ -

第766回

デジタル

Instinct MI300のI/OダイはXCDとCCDのどちらにも搭載できる驚きの構造 AMD GPUロードマップ -

第765回

PC

GB200 Grace Blackwell SuperchipのTDPは1200W NVIDIA GPUロードマップ -

第764回

PC

B100は1ダイあたりの性能がH100を下回るがAI性能はH100の5倍 NVIDIA GPUロードマップ -

第763回

PC

FDD/HDDをつなぐため急速に普及したSASI 消え去ったI/F史 -

第762回

PC

測定器やFDDなどどんな機器も接続できたGPIB 消え去ったI/F史 -

第761回

PC

Intel 14Aの量産は2年遅れの2028年? 半導体生産2位を目指すインテル インテル CPUロードマップ -

第760回

PC

14nmを再構築したIntel 12が2027年に登場すればおもしろいことになりそう インテル CPUロードマップ -

第759回

PC

プリンター接続で業界標準になったセントロニクスI/F 消え去ったI/F史 -

第758回

PC

モデムをつなぐのに必要だったRS-232-CというシリアルI/F 消え去ったI/F史 - この連載の一覧へ