MDCを実現するためには

Optane DC Persistent MemoryとGen-Zが必要

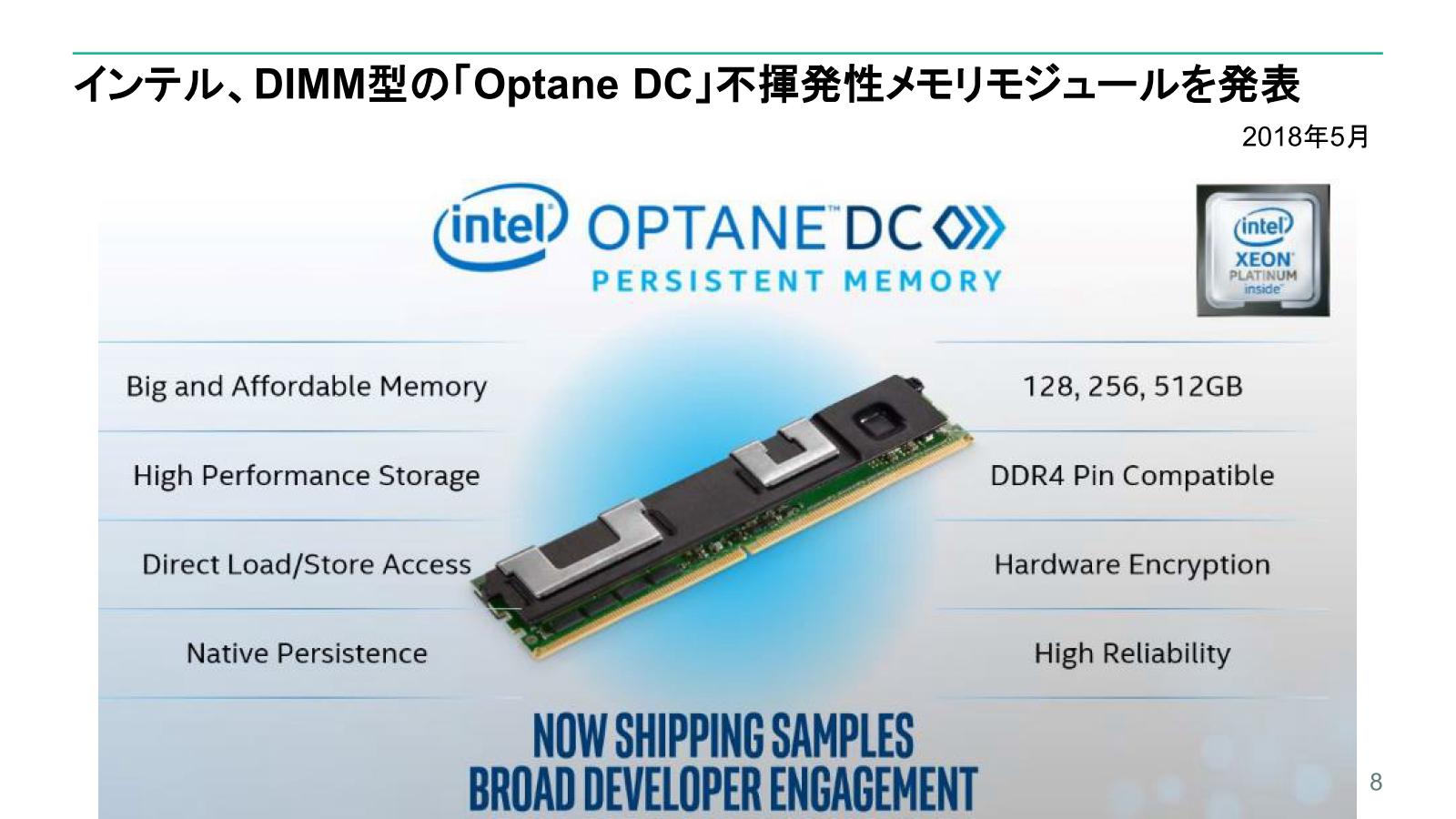

ここからの資料はHPEが2018年に行なったHPC&AIフォーラム2018におけるプレゼンテーションであるが、まずMDCを実現するための要素技術として、インテルのOptane DC Persistent MemoryとGen-Zを挙げた。

Optane DC Persistent Memory。容量もこの時点で512GBまでラインナップされ、The Machineに使われたものの4倍のメモリー容量が実装可能となる

画像の出典は、HPE HPC & AI フォーラム 2018 講演資料

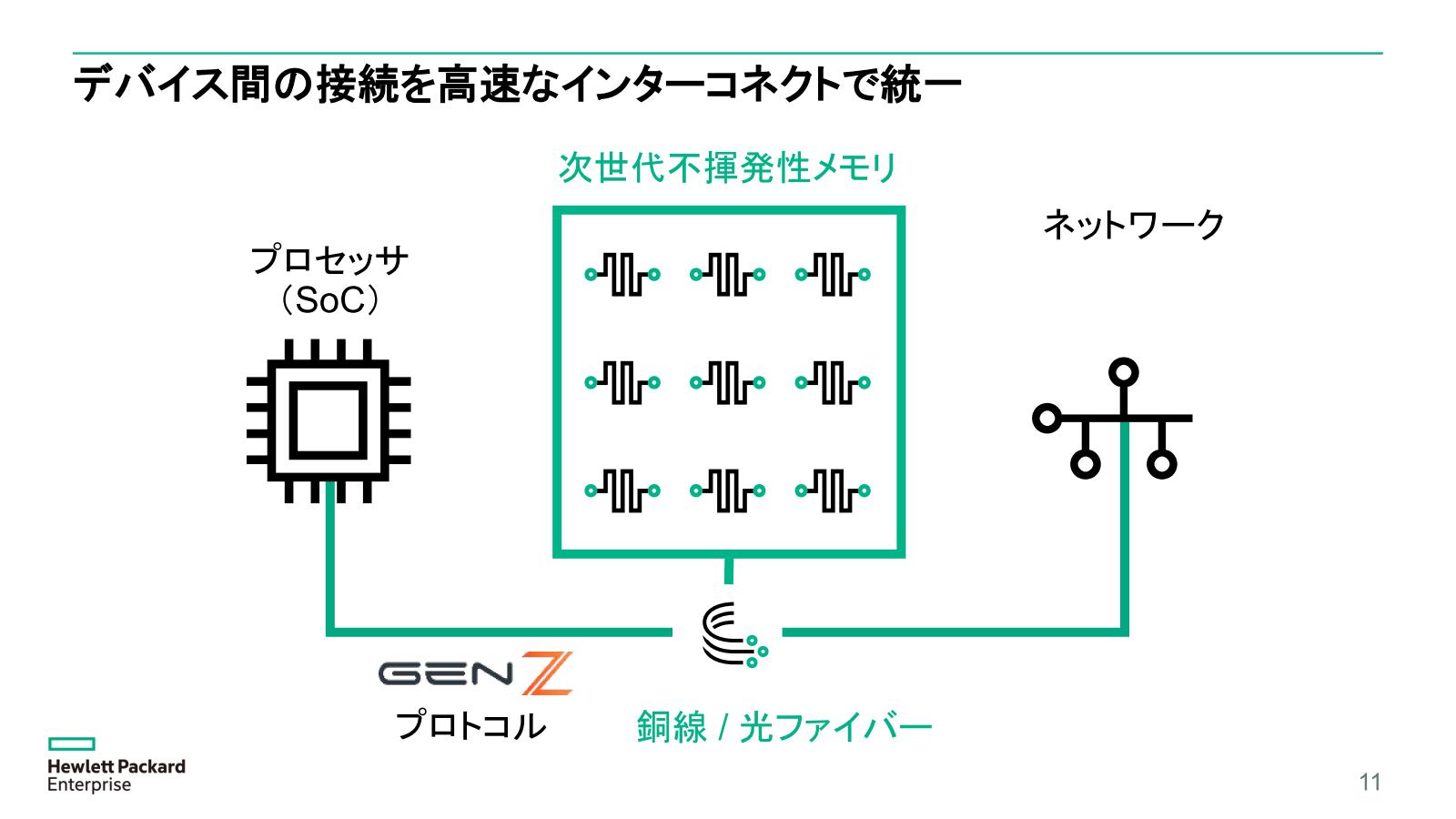

Gen-ZはGen-Z Consortiumが開発しているサーバー向けインターコネクトの技術であり、単にシャーシ内部だけでなくシャーシ間あるいは(近距離の)ラック間での接続も視野に入れた規格である。

下敷きにしているのはInfiniBandであるが、実装はInfiniBandに留まらず、より高速な接続も可能になっていることと、当初からメモリーの接続(SCM:Storage Class MemoryのみならずDRAMも視野に入れている)を考慮しており、確かにMDCに利用するには最適である。

ただHPはThe Machineをそのまま顧客に届けるわけではなく、既存の製品ラインにThe Machineで培ったMDCの技術を入れ込む方向を取っている。

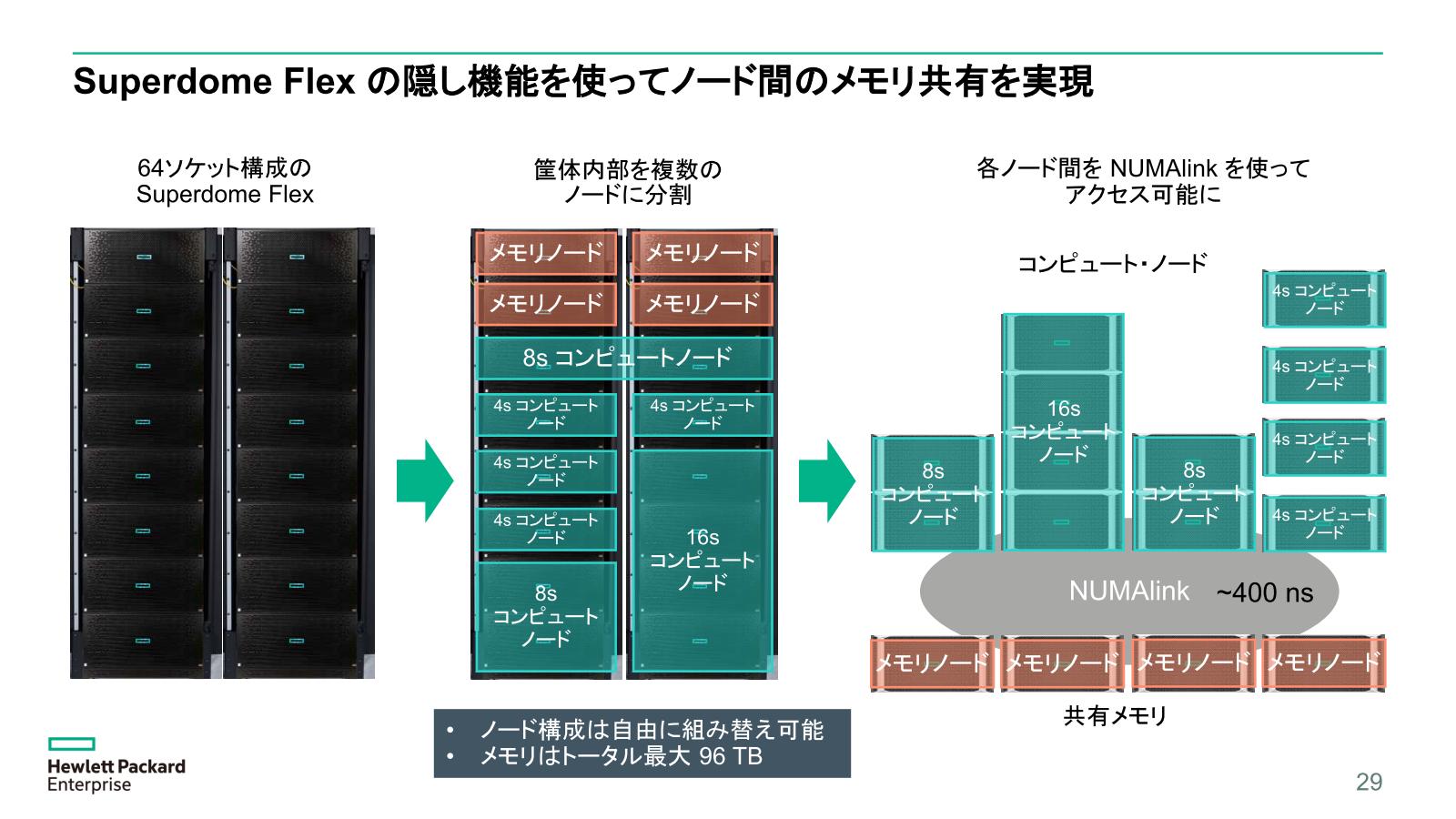

同社のハイエンドサーバーは引き続きSuperdomeが務めているが、2016年にはミッションクリティカル向けのSuperdome Xを発表、2017年末にはさらに上位機種となるIn-Memory Computingにも対応したSuperdome Flexを国内発表している。

この時点でのIn-Memory Computingは、SAP HANAやOracle DB In-memoryなど、従来型のCDCベースながら大量のメモリーを利用する用途を考えたものであるが、このSuperdome FlexにMDC的な使い方を可能にするオプションがあることが発表された。

またMDCが利用できるかどうか、を確認するためのテストを行なうためのSandboxを提供予定であることも明らかにしている。

ちなみに国内では、2019年3月からNTT ComのNexcenterに検証環境が置かれているそうだ。

まだ現状MDCは始まったばかりであって、今後これが主流になるかどうかを含めて海のものとも山のものとも知れない状態に変わりはないのだが、研究開発費が削られまくった2000~2010年代を生き延びたというだけでも特筆ものと言えるかもしれない。

この連載の記事

-

第861回

PC

INT4量子化+高度な電圧管理で消費電力60%削減かつ90%性能アップ! Snapdragon X2 Eliteの最先端技術を解説 -

第860回

PC

NVIDIAのVeraとRubinはPCIe Gen6対応、176スレッドの新アーキテクチャー搭載! 最高クラスの性能でAI開発を革新 -

第859回

デジタル

組み込み向けのAMD Ryzen AI Embedded P100シリーズはZen 5を最大6コア搭載で、最大50TOPSのNPU性能を実現 -

第858回

デジタル

CES 2026で実機を披露! AMDが発表した最先端AIラックHeliosの最新仕様を独自解説 -

第857回

PC

FinFETを超えるGAA構造の威力! Samsung推進のMBCFETが実現する高性能チップの未来 -

第856回

PC

Rubin Ultra搭載Kyber Rackが放つ100PFlops級ハイスペック性能と3600GB/s超NVLink接続の秘密を解析 -

第855回

PC

配線太さがジュース缶並み!? 800V DC供給で電力損失7~10%削減を可能にする次世代データセンターラック技術 -

第854回

PC

巨大ラジエーターで熱管理! NVIDIA GB200/300搭載NVL72ラックがもたらす次世代AIインフラの全貌 -

第853回

PC

7つのカメラと高度な6DOF・Depthセンサー搭載、Meta Orionが切り開く没入感抜群の新ARスマートグラス技術 -

第852回

PC

Google最新TPU「Ironwood」は前世代比4.7倍の性能向上かつ160Wの低消費電力で圧倒的省エネを実現 -

第851回

PC

Instinct MI400/MI500登場でAI/HPC向けGPUはどう変わる? CoWoS-L採用の詳細も判明 AMD GPUロードマップ - この連載の一覧へ