ロードマップでわかる!当世プロセッサー事情 第801回

光インターコネクトで信号伝送の高速化を狙うインテル Hot Chips 2024で注目を浴びたオモシロCPU

2024年12月09日 12時00分更新

Hot Chipsの話題も今回が最後。インテルの"4 Tb/s Optical Compute Interconnect Chiplet for XPU-to-XPU Connectivity"の話をご紹介したい。

光インターコネクトを利用して

プロセッサー同士の接続を狙うインテル

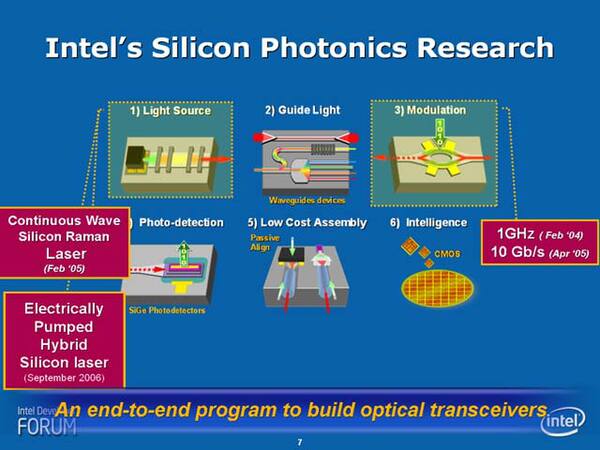

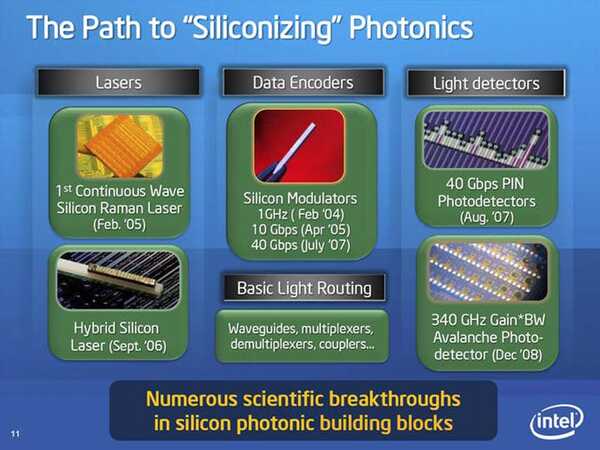

もともと、インテルは光インターコネクトに2000年代から熱心だった。それもシリコンオプティクス(シリコン製光学素子)を利用して、光インターコネクトを実現するのが目標だった。

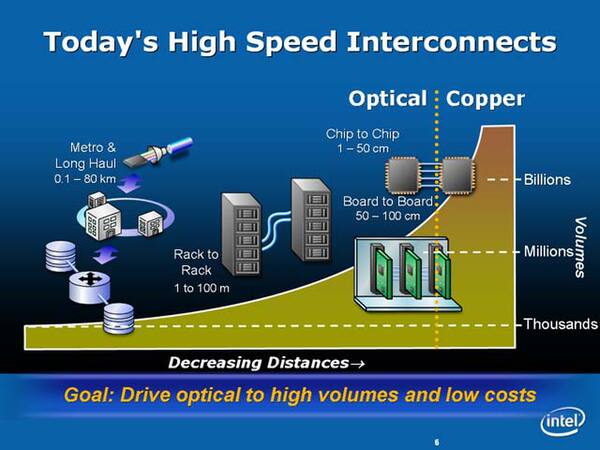

下の画像は2006年のIDFにおけるJustin Rattner氏(当時のCTO)の基調講演のスライドなのだが、配線距離50cmあたりを境に、それより短いものは銅配線、長い物は光配線にするという壮大な野望のためのコンポーネントが次第にそろいつつあることをアピールしていた。

その4年後となる2010年には、50Gbpsでの伝送に必要なすべてのコンポーネントをシリコンで製造することに成功したと発表している。

その翌年に登場したのがLight Peakである。Thunderboltのご先祖様とでも言うべきLight Peakは光ファイバーベースのインターコネクトを目指していたが、それがThunderboltになる際には銅配線ベースになってしまった。

辛うじて2011年の新VAIO ZでPower Media Dockとして光ファイバーベースのLight Peakが採用されたものの、それ以上には広がらなかった。

ではその後シリコンフォトニクス(光と電子の集積回路)はどうなったか? というともう少し現実的な市場で量産することで、コスト低減や製品の洗練を目指すことになった。

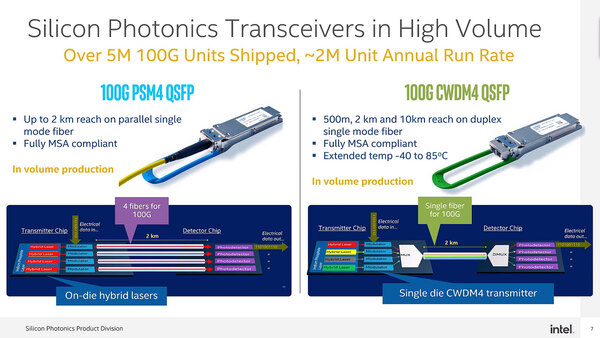

下の画像は2021年のTech Field DayでインテルのRobert Blum氏(Sr. Director, Marketing and New Business, Silicon Photonics Product Division)らが行なった"Optical Networking at Scale with Intel Silicon Photonics"という動画で示されたスライドだが、この時点で同社はシリコンフォトニクスを使った100Gイーサネットのトランシーバーを年間200万ユニット、累計で500万ユニット出荷していることを明らかにしている。

このあたりの話はBroadcomと同じ。このトランシーバーモジュールはシリコンフォトニクスの手頃な題材らしい

もっともインテルは2023年10月に、このイーサネットモジュールのビジネスを丸ごと米Jabilに売却してしまっている。

Broadcomの例だとイーサネットモジュールの次にスイッチが来たわけだが、インテルはスイッチ製品を扱っていない。ちなみに、2019年にBarefoot Networksを買収し、ここの保有していたTofinoというスイッチ製品は存在したが、2022年にこのTofino製品への新規投資を中止。既存製品のサポートのみとしたので、少なくともこのTofinoにシリコンオプティクスを使うというプランは完全になくなった。

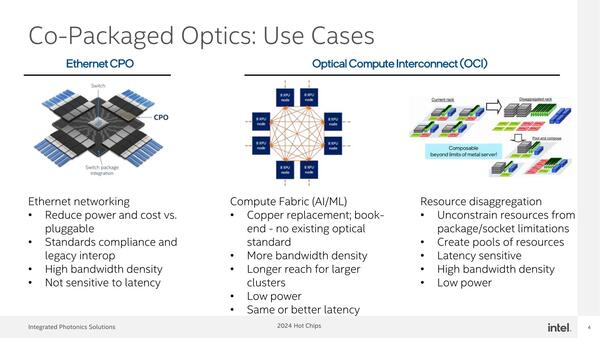

ただ「理論上は」インテルのファウンドリーでスイッチの製造を請け負う可能性はあるので、これに向けたCPOの提供を用意する準備はあるようだが、それよりもインテルの焦点はその先、光インターコネクトを利用してのプロセッサー同士の接続にあるとする。

例えばPonte VecchioことData Center GPU Maxは最大8つまでをXe Linkを使って相互接続できる構成だが、Auroraに搭載されたブレードにはData Center GPU Maxが6つが物理的な限界となっている。

したがってより数を増やそうとすると、その先はホスト側のPCI Express経由若しくはイーサネット経由となる。これは電気的な信号であることがボトルネックになっており、今後よりAIなどでプロセッサー数を増やす場合、そのプロセッサー同士の相互接続が問題になってくるという話だ。

この連載の記事

-

第803回

PC

トランジスタの当面の目標は電圧を0.3V未満に抑えつつ動作効率を5倍以上に引き上げること IEDM 2024レポート -

第802回

PC

16年間に渡り不可欠な存在であったISA Bus 消え去ったI/F史 -

第800回

PC

プロセッサーから直接イーサネット信号を出せるBroadcomのCPO Hot Chips 2024で注目を浴びたオモシロCPU -

第799回

PC

世界最速に躍り出たスパコンEl Capitanはどうやって性能を改善したのか? 周波数は変えずにあるものを落とす -

第798回

PC

日本が開発したAIプロセッサーMN-Core 2 Hot Chips 2024で注目を浴びたオモシロCPU -

第797回

PC

わずか2年で完成させた韓国FuriosaAIのAIアクセラレーターRNGD Hot Chips 2024で注目を浴びたオモシロCPU -

第796回

PC

Metaが自社開発したAI推論用アクセラレーターMTIA v2 Hot Chips 2024で注目を浴びたオモシロCPU -

第795回

デジタル

AI性能を引き上げるInstinct MI325XとPensando Salina 400/Pollara 400がサーバーにインパクトをもたらす AMD CPUロードマップ -

第794回

デジタル

第5世代EPYCはMRDIMMをサポートしている? AMD CPUロードマップ -

第793回

PC

5nmの限界に早くもたどり着いてしまったWSE-3 Hot Chips 2024で注目を浴びたオモシロCPU - この連載の一覧へ