たった1枚の画像からタッチを再現する「reference-only(リファレンスオンリー)」の衝撃

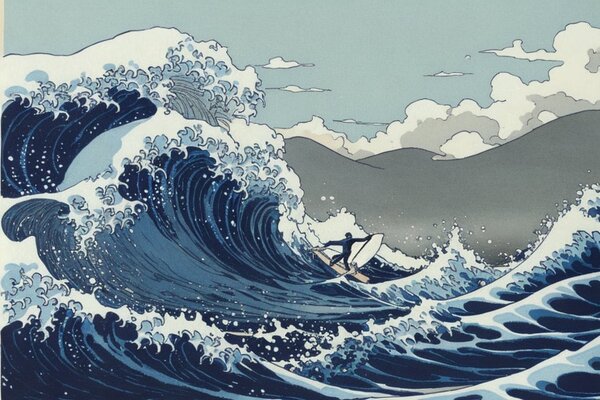

そして5月13日に追加されたのが「reference-only(リファレンスオンリー)」という、さらに驚くべき機能でした。これは1枚の入力画像を指定するだけで、その画像が持っている特徴量を抽出し、生成する画像に反映させるという機能です。

5月13日にリリースされた新しいCONTROLNetの機能Reference-only…………とんでもない機能。

— 井上純一(希有馬)新刊『逆資本論』発売中 (@KEUMAYA) May 15, 2023

ついに俺の一枚絵から、俺のやりそうな影の入れ方でAIが新しい画像を抽出できるようになった。

1枚目が自分です。 pic.twitter.com/oL6YEcHjIV

漫画家の井上純一さんが機能を試しています。自分で描かれた絵を入力して、画像を生成してみたところ、自分のタッチをそのまま反映した画像が出てきたことを報告しています。

画像生成AIが今なお抱えている技術的課題は、キャラクターにしても何にしても、首尾一貫したデザインが苦手という点です。これは特徴量空間から乱数で画像を生成するというシステムの特性上、画像生成AIに一貫性という概念が存在しないためです。

30枚程度の画像から特定概念を追加学習する「LoRa(Low-Rank Adaptation of Large Language Models)」という方法などを使おうという試みもありましたが、LoRaでもバラつきが生まれてしまい、完全な再現はできないことが多かったんですね。

しかしreference-onlyはたった1枚の入力画像から同じような雰囲気の再現に成功してしまいました。表現にはまだブレがあるものの、他のControlNetの機能を組み合わせることでかなり再現性の高い画像を作り出せるようになってきたという報告もあります。

さらにReference機能にも2種類の方式が追加され、「元画像を参照しながらもちょっと違う画風にする」という機能も登場してきています。

この連載の記事

-

第61回

AI

画像生成AI“児童ポルノ”学習問題、日本では表現規制の議論にも -

第60回

AI

3Dアニメーション技術の革新が止まらない -

第59回

AI

政府、生成AI推進に向けて議論を加速 -

第58回

AI

画像生成AIで同じキャラクターが簡単に作れるようになってきた -

第57回

AI

日本発のリアルタイム画像生成AIサービスが熱い 大手にとっては“イノベーションのジレンマ”に -

第56回

AI

画像生成AIの著作権問題、文化庁議論で争点はっきり -

第55回

AI

動画生成AIの常識を破壊した OpenAI「Sora」の衝撃 -

第54回

AI

画像生成AI、安いPCでも高速に 衝撃の「Stable Diffusion WebUI Forge」 -

第53回

AI

日本発の画像生成AIサービスがすごい 無料アップスケーラー「カクダイV1」 -

第52回

AI

美少女イラスト、AI技術で立体化 ポケットサイズの裸眼立体視ディスプレーが人気に -

第51回

AI

“生成AIゲーム”急増の兆し すでに150タイトル以上が登録 - この連載の一覧へ