INT4やINT1をサポートする

プロセッサーが普及していく

一方整数演算についても、当初はINT32などを使っていたのがすぐINT8に切り替わったが、より積極的にINT4/INT2/INT1なども研究されるようになった。これの先鞭をつけたのはFPGAである。

CPUやGPUの場合、8bit演算が最小単位になっているため、これ未満の単位でも動作としては8bit演算になる。したがって4bitにしてもまったく性能向上に寄与しないのだが、FPGAの場合は4bit演算器や2bit演算器を作りこむことが可能で、その場合は本当に回路規模が小さくなる=同時に処理できるデータ量が多くなるので、性能が向上するというメリットが大きくなる。

これを極端に進めたのがBinary、つまりデータ型が1bitのネットワークである。もちろん1bitなのはデータのみで、フィルターの係数はINT8などになるのだが、こちらは圧倒的に計算量が減らせる。

なぜなら、畳み込み演算などで乗算を全部論理積(And)に置き換えできるからだ。前回、Ampereのアーキテクチャー説明の中でSparsity(疎行列への対応)を説明したが、理屈はアレと同じである。

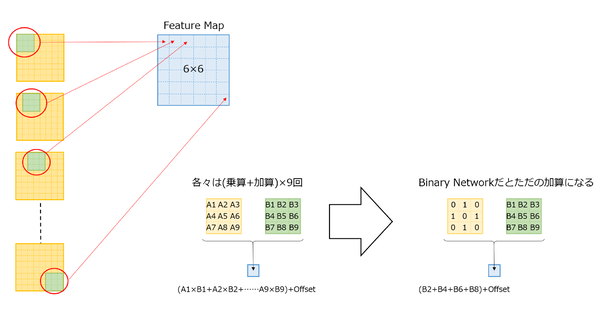

下図の左側は、連載562回で説明した畳み込みの計算であるが、Binaryの場合は入力画像(A1~A9)が0か1しかないので、事実上掛け算の必要が一切なく、単にB1~B9に論理積を行なってから足し算をするだけで良い。

この論理積のロジックは乗算のロジックよりもずっと簡単に実装できるので、単にデータの格納に必要なメモリーが減るだけでなく、演算ロジックそのものも大幅に簡素化できるから、同時により多数のデータを並列で処理しやすくなり、そのまま性能向上につながる。

8bit未満(4bit/2bit/1bit)に関してはこれまでFPGAの独壇場だったが、NVIDIAがAmpereでINT4/INT1をサポートしたというのは、こうしたトレンドに対応するためと考えられる。

CPU側に関しては今のところこれをサポートする動きはないが、長期的にはSIMD拡張の中でINT4やINT1をサポートする可能性はあるだろう。

またAI向けプロセッサーの中には、このINT4/INT1をオプションでサポートする製品も出てき始めており、今後は広範に普及していくかもしれない。

この連載の記事

-

第864回

PC

なぜAMDはチップレットで勝利したのか? 2万ドルのウェハーから逆算する経済的合理性 -

第863回

PC

銅配線はなぜ限界なのか? ルテニウムへの移行で変わる半導体製造の常識と課題 -

第862回

PC

「ビル100階建て相当」の超難工事! DRAM微細化が限界を超え前人未到の垂直化へ突入 -

第861回

PC

INT4量子化+高度な電圧管理で消費電力60%削減かつ90%性能アップ! Snapdragon X2 Eliteの最先端技術を解説 -

第860回

PC

NVIDIAのVeraとRubinはPCIe Gen6対応、176スレッドの新アーキテクチャー搭載! 最高クラスの性能でAI開発を革新 -

第859回

デジタル

組み込み向けのAMD Ryzen AI Embedded P100シリーズはZen 5を最大6コア搭載で、最大50TOPSのNPU性能を実現 -

第858回

デジタル

CES 2026で実機を披露! AMDが発表した最先端AIラックHeliosの最新仕様を独自解説 -

第857回

PC

FinFETを超えるGAA構造の威力! Samsung推進のMBCFETが実現する高性能チップの未来 -

第856回

PC

Rubin Ultra搭載Kyber Rackが放つ100PFlops級ハイスペック性能と3600GB/s超NVLink接続の秘密を解析 -

第855回

PC

配線太さがジュース缶並み!? 800V DC供給で電力損失7~10%削減を可能にする次世代データセンターラック技術 -

第854回

PC

巨大ラジエーターで熱管理! NVIDIA GB200/300搭載NVL72ラックがもたらす次世代AIインフラの全貌 - この連載の一覧へ