CNN(畳み込みニューラルネットワーク)が実用になる、という話で2013年あたりから活発に業界がそちらに向けて動き始めたという話は過去3回でしてきたが、これに向けた専用プロセッサーの先鞭をつけたのはGoogleだった。

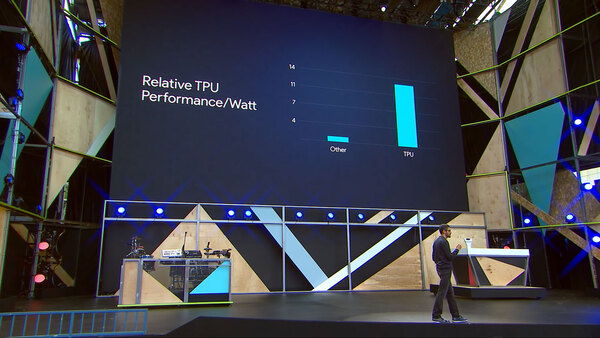

性能/消費電力比が競合と比べて10倍優秀

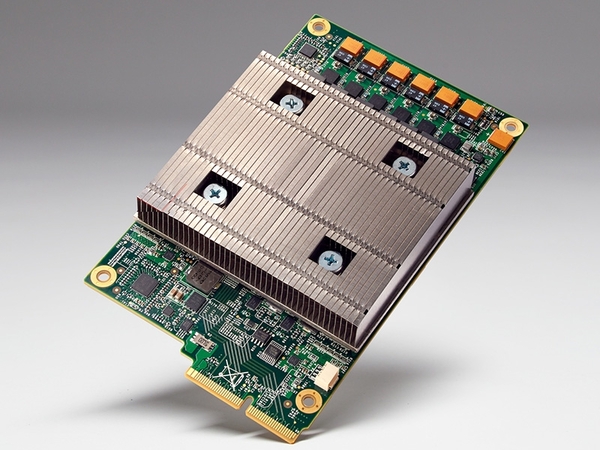

GoogleのAI向けプロセッサー「Google TPU」

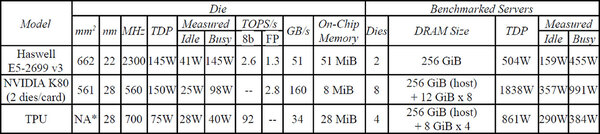

2016年5月に開催されたGoogle I/Oの基調講演で、GoogleはGoogle TPUを発表。絶対性能はともかくとして、性能/消費電力比が競合と比べて10倍優れていると説明した。

競合はおそらくNVIDIAのGPUだが、2016年5月はまだPascalが前月にリリースされたばかりなので、世代的にはMaxwellが競合となる。ただデータセンター向けのTeslaでは28nmプロセスのKeplerベースが最新であり、これとの比較とこの時点では思われた。

Google TPUもやはり同じ28nmプロセスで製造されており、アーキテクチャーを工夫することで10倍の効率を実現したというわけだ。

基調講演では、Google TPUがすでに稼働中であり、Google検索の要であるPageRankを評価するRankBrainやGoogle Street View、さらにはAlphaGoなどにも使われていることが明らかにされた。

そのGoogle TPUであるが、2017年6月に開催されたISCA(International Symposium on Computer Architecture)において“In-Datacenter Performance Analysis of a Tensor Processing Unit”という論文で詳細が明らかにされた。

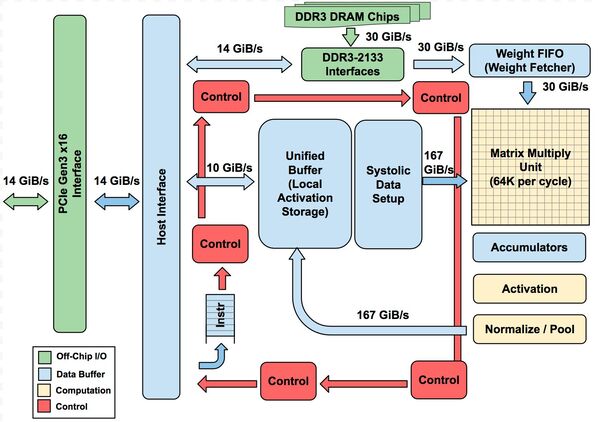

下の画像がその全体像である。計算部となるのは、256×256で65536個並んだMAC演算ユニットと、そのMAC演算の後処理で加算を行なうアキュムレーターである。もっともこれ、65536個のMACユニットが同時に演算できるわけではなく、言ってみれば256サイクルかけて出力されるようなイメージである(実際はもう少し早い)。

つまり256組の256 MAC演算ユニットがあるかたちだ。1サイクルあたりに出力される結果は1組分であり、パイプライン動作をしている格好だ。ただそれでも毎サイクルあたり256Bytesのデータ処理が行なわれるわけで、それに見合ったデータ転送性能が必要である。

例えば連載562回で例として掲載した図を例にとると、もともとの画像データはSystolic Data Setupと呼ばれるユニットから、フィルターのデータはWight FIFO(Weight Fetcher)と呼ばれるユニットから供給され、乗算→加算→活性化→プーリングを経てUnified Bufferに戻される。

このSystolic Data Setupと64KのMatrix Multiply Unit、およびNormalized/PoolとUnified Bufferの間は、256Bytes(=2048bit)幅のバスでつながっている。

要するに1サイクルあたり256Bytesの元データ読み込みが可能で、一方演算結果も同じく256Bytes/サイクルでUnified Bufferに書き戻せる構造になっている。ちなみにそのMAC Unitの下にあるアキュムレーターは、1サイクルで256個の演算結果の合計を計算可能になっている。

このTPUがどれだけスムーズに動作するかは、どれだけ切れ目なくデータをMACユニットに送り出し、かつ結果を受け取れるかにある。このため、Unified Bufferは24MB、アキュムレーターは4MBの容量を持っている。

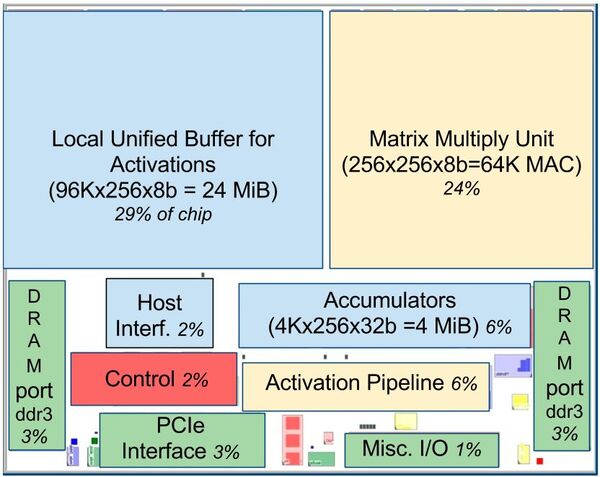

チップ内部のレイアウトは下の画像の通りで、バッファがかなり大きな容積を喰っているのがわかる。ただ24MBはキャッシュとしては十分であっても、システム全体のメモリーとしては不十分である。

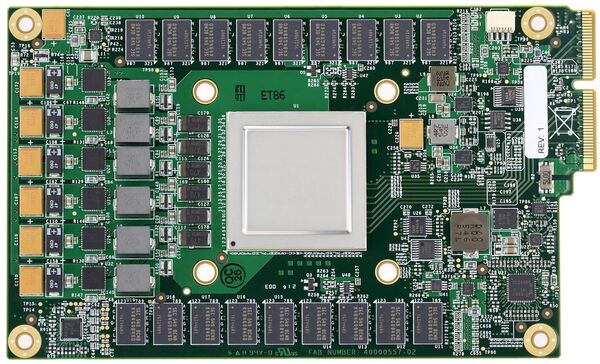

これを支えるためにDDR3-2133×2chのメモリーが合計32GB搭載され、これで足りなければPCI Express経由でホストのメモリーを利用できるかたちだ。ちなみにヒートシンクの陰に隠れていた基板が下の画像だ。

この連載の記事

-

第781回

PC

Lunar LakeのGPU動作周波数はおよそ1.65GHz インテル CPUロードマップ -

第780回

PC

Lunar Lakeに搭載される正体不明のメモリーサイドキャッシュ インテル CPUロードマップ -

第779回

PC

Lunar LakeではEコアの「Skymont」でもAI処理を実行するようになった インテル CPUロードマップ -

第778回

PC

Lunar LakeではPコアのハイパースレッディングを廃止 インテル CPUロードマップ -

第777回

PC

Lunar Lakeはウェハー1枚からMeteor Lakeの半分しか取れない インテル CPUロードマップ -

第776回

PC

COMPUTEXで判明したZen 5以降のプロセッサー戦略 AMD CPU/GPUロードマップ -

第775回

PC

安定した転送速度を確保できたSCSI 消え去ったI/F史 -

第774回

PC

日本の半導体メーカーが開発協力に名乗りを上げた次世代Esperanto ET-SoC AIプロセッサーの昨今 -

第773回

PC

Sound Blasterが普及に大きく貢献したGame Port 消え去ったI/F史 -

第772回

PC

スーパーコンピューターの系譜 本格稼働で大きく性能を伸ばしたAuroraだが世界一には届かなかった -

第771回

PC

277もの特許を使用して標準化した高速シリアルバスIEEE 1394 消え去ったI/F史 - この連載の一覧へ