HPEチーフアーキテクト、メモリ主導型アーキテクチャが実現する次世代のデータ洞察を語る

HPE「The Machine」は、ムーアの法則終焉の危機感が生んだ

2017年06月20日 07時00分更新

われわれは、いずれやって来る「『ムーアの法則』の終焉」に向けた準備が出来ていないのではないか――。米ヒューレット・パッカード・エンタープライズ(HPE)が進める次世代コンピューティングアーキテクチャの開発研究プロジェクト「The Machine」は、こうした危機感から始まったという。

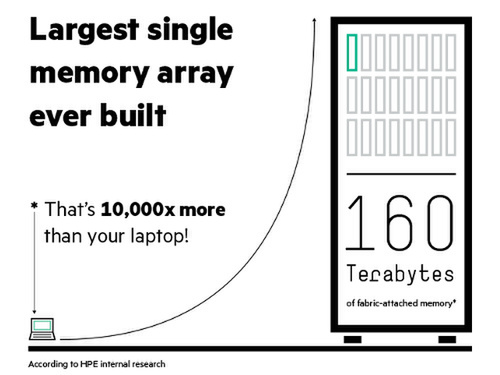

The Machineプロジェクトでは今年5月、160TBという世界最大の単一メモリシステムを実装したプロトタイプによる実証実験の成功を発表している。今回、HPEが米国で開催した年次イベント「HPE Discover Las Vegas 2017」の会場で、The Machineプロジェクトを率いるカーク・ブレスニカー氏に、プロジェクト誕生の裏話や、「メモリ主導型コンピューティング」で実現する新たなユースケースなどを聞いた。

コンピューター技術が“頭打ち”になれば、未来は現実のものにならない

――The Machineプロジェクトは順調に進んでいるようですね。5月には実証実験成功が発表されました。

メモリ主導型コンピューティングのアイディア自体は10年ぐらい前からあったが、その具体化に向けたリサーチプログラムの構想を、2014年のHPE Discoverで発表した。2016年11月には、メモリファブリックやフォトニクス(光通信)などの技術要素を組み合わせたマシンで、そのハードウェアに最適化したLinuxを動作させることに成功した。

その後さらに構成スケールを拡大し、160TBの単一メモリシステムというマイルストーンを達成したというのが、今年5月の発表だ。このプロトタイプ機では、数千ものマイクロプロセッサコア(カビウムのARM SoC「ThunderX2」)と巨大なメモリプールをフォトニクスで接続し、“ブレイクスルー”と呼べるレベルのパフォーマンスを達成している。電力効率が高いことも特徴だ。

The Machine実証実験では40ノードのプロトタイプ機が使われた

ノートPC 1万台ぶん以上に相当する160TBメモリを搭載するシステムは、まだ誰も経験したことがない。従来型のサーバーで巨大なクラスタを構成しても、それは「単一の」メモリシステムではない。The Machineの場合は単一メモリ空間なので、すべてのマイクロプロセッサコアがひとつのインストラクションを読み込むだけで、ファブリックを介してすべてのメモリ(上のデータ)にアクセスできる。このアーキテクチャでは、最大で4096ヨタバイトの単一メモリをサポートする。これは、現在世界にあるデジタルデータ総量の25万倍の規模である。

最初の技術的マイルストーンを達成した現在は、次にどの分野のコンピューター科学を調査研究すべきか、どのようなアプリケーション分野で使ってもらえるかを検討している。たとえるならば、望遠鏡(=The Machineのプロトタイプ)が完成したので、どの方向を見てみようかと考えているところだ。

今回の実証実験ではノートPC 1万台ぶん以上の単一メモリシステムを構成した

――そもそもなぜ、The Machineを開発しようと思ったのですか?

HP(当時)とコンパックが合併した2003年ごろ、わたしはHPでブレードサーバーの開発を担当していた。合併後、(コンパックのキャンパスがあった)ヒューストンに行ってコンパックのProLiantサーバーチームに出会い、彼らもわたしと同じようなことを目指していることに気づいた。こうして新たな開発チームが立ち上がり、「BladeSystem c-Class」というすばらしい製品を生み出した。

開発をしている人ならわかると思うが、成功すると「次は何か?」を考えるものだ。わたしも考えたが、次に成功しそうなアイディアよりもまず、「ムーアの法則」が終焉に向かっていることを強く感じた。

すでに当時、半導体製造プロセスは22nm(ナノメートル)まで微細化していた。たとえその後、16nm、10nm……と微細化が続いても、いずれは物理的限界を迎えて頭打ちになる。その汎用プロセッサだけでなく、汎用OS、ハードディスクベースのストレージ、リレーショナルデータベース――すべての技術が“完成”ではなく“完了”しつつあると思った。

「ムーアの法則」以後、コンピューターは常に前世代よりも性能改善することが歴史的必然のように思われてきた。しかし現実には、いずれ限界が訪れる。しかも、(コンピューターを構成する要素の)すべての限界が同時期に来るかもしれない。そう考えると、とてもショックだった。自分が勤務しているHPは、現在のコンピューターの基盤技術が“終わる”ときに向けた準備が出来ているだろうか、と。

それと同時に、デジタルデータの急増にも目を向けた。われわれが生成するデータは、まるで上限がないかのように増え続けている。その一方で、自動運転やスマートファクトリーといったユースケースを考えればわかるが、データから洞察を得るスピードへの要求はますます厳しくなっている。膨大なデータには機械学習を適用することも必要になるだろう。しかし、コンピューター技術が“頭打ち”になってしまえば、こうした未来は現実のものにはならない。

そこでこのプロジェクトが立ち上がったわけだ。まずはHP Labsで始まり、現在はHPEの製品エンジニアリングチーム、サプライチェーン、サービスとも連携し、継続して成長できる体制を追求している。2014年に発表した際は「大胆な構想だ」と言われたが、今ではそれは着実に現実のものになりつつある。

――現在、どのぐらいの規模のチームで取り組んでいるのでしょうか?

プロジェクトには、HP LabsとHPEのビジネスグループなど500名以上が関わっている。複数の拠点で研究開発を展開しており、たとえばフォトニクスのアセンブリは7カ国の開発者が協力して実現した。

プロトタイプの実装作業(The Machineプロジェクトサイトより)