2013年以降5回の大規模更改/増設、ジュニパーのファブリックを採用した理由

成長し続けるDMM.comのネットワーク、その変遷を担当が語る

2015年09月08日 14時00分更新

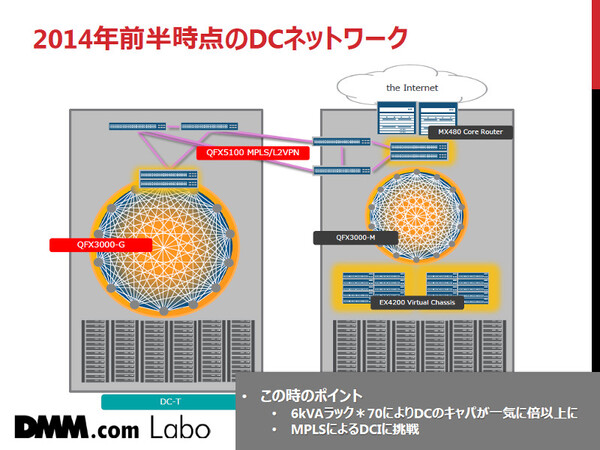

2014年前半、70ラックの10Gサーバー専用コロケーションを増設

こうして大規模なネットワーク更改を果たしたDMM.comだったが、サービスとユーザー数は拡大し続け、そのわずか半年後(2014年)にはデータセンターの増設が決定した。「10G(10ギガ)サーバー専用のコロケーションを都内に契約しました。ハイスペックサーバーを高密度収容できる6kVAラックが70ラック。データセンターキャパシティは一気に倍以上になりました」(山田氏)。

前述のデータセンターでは中規模向けのQFabric製品である「QFX3000-M」を導入したが、10Gサーバーのみの新しいデータセンターでは、より収容能力の大きい「QFX3000-G」を採用することになった。QFX3000-Gは、最大6144個の10GbEポートを収容できる製品だ。

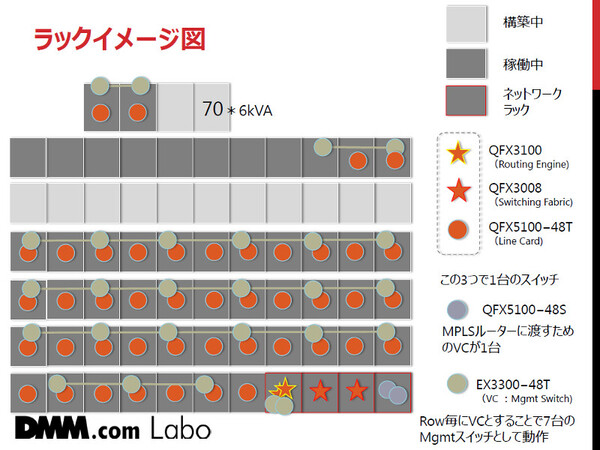

そのうえで、すべての10Gサーバーを10G Base-T経由で直接QFabricに収容するネットワークデザインとした。「ラインカードは各サーバーラックに、ルーティングエンジンやスイッチングファブリックはネットワークラックに設置しますが、これらが『1台のスイッチ』として動作し、管理できる。それがQFabricの良いところです」(山田氏)。

その結果、6kVA×70ラックの環境でも、管理対象となるスイッチの台数は「10台程度」(QFabric 1台+マネジメントスイッチ9台程度)に抑えられ、管理負荷が非常に少なく済んでいるという。

他方、山田氏はこのネットワークでも新たなチャレンジを行っている。それまで触れたことのなかったMPLSを、データセンターインターコネクト(DCI)で採用したのだ。ちょうど「QFX5100」スイッチがMPLS/L2VPNをサポートしたタイミングであり、将来的なマルチデータセンター間接続にMPLSを利用することも意識しての挑戦だった。

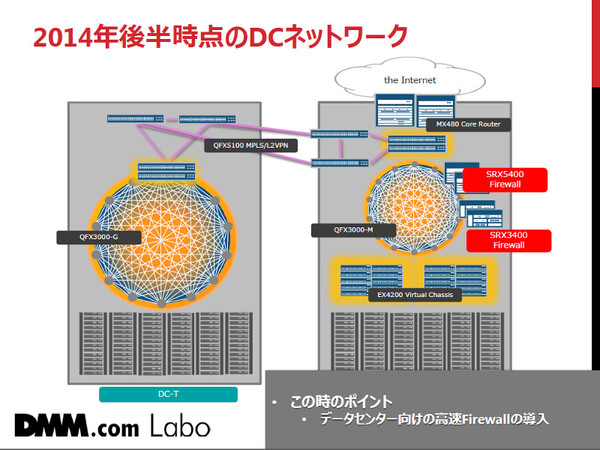

2014年後半、高速なデータセンター向けファイアウォールを導入

こうして新データセンターのネットワークを構成し終えたのもつかの間、2014年後半にはまた新たな要求が持ち上がる。それまで外注で構成していたゲーム系システムを統合するために、ハイパフォーマンスなファイアウォールが必要になったのだ。

ここでは、データセンター向けファイアウォールの「SRX5400」および「SRX3400」を導入することになった。ポイントは拡張性だったと、山田氏は説明する。「あとでサービスが急増した場合の、柔軟なパフォーマンス拡張が課題でした。SRXならば、サービスプロセッシングカード(SPC)を増強することで簡単にパフォーマンスが拡張できます」(山田氏)。

また、ルーターやスイッチと同じJUNOSで管理ができる点、「Chassis Cluster」機能で管理台数を削減できる点も評価したという。

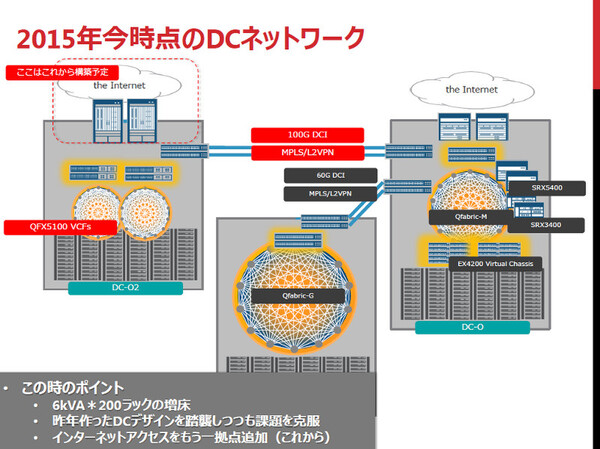

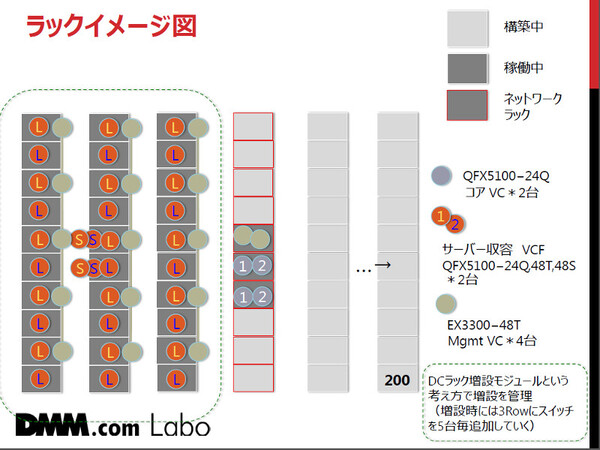

今年はさらに200ラックを増床、異なるファブリック技術も採用

それでもDMM.comのサービス成長は止まらない。今年(2015年)前半には、またしてもデータセンターの増設が決まった。2014年に新設したデータセンターと同じ6kVAラックが、今度は200ラックという規模だ。

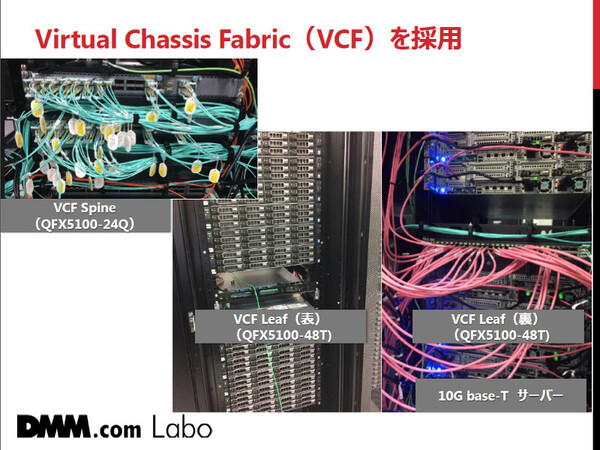

今回の新たなチャレンジとして、山田氏らはQFX5100の「Virtual Chassis Fabric(VCF)」機能を採用した。「6kVA×200ラックの増床となると、単体のQFabricでは収容できません。そこでこのデータセンターでは、もっと小さなドメインに分割することにして、ラックのロー(列)単位でVCFに収容するデザインにしました」(山田氏)。

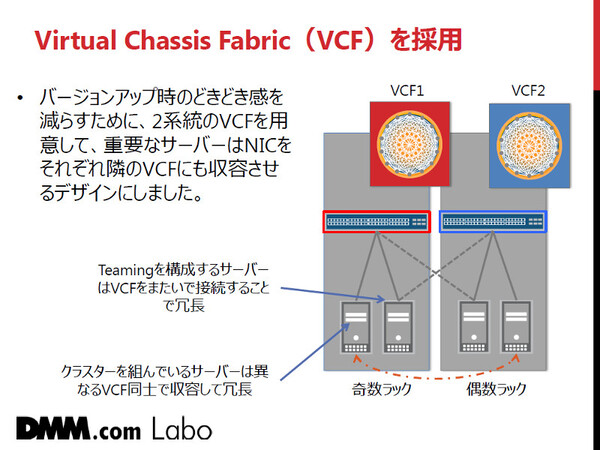

山田氏は、VCFの採用と同時に、以前から抱えていた“ある課題”を解決したかったと語る。ネットワーク機器のファームウェアバージョンアップを実行する際に生じうる、万が一のトラブルにどう備えるか、という課題だ。

そこで、この新しいネットワークでは2系統のVCFを用意した。重要なサーバーは、必ず両方の系統につなぐ(LAN接続を冗長化する)ようにすることで、バージョンアップやネットワーク障害の際には容易に片寄せ運用できるようにしてある。

また、今回のDCIには100Gbpsが必要だったため、ダークファイバを利用してMPLS/L2VPNで構成している。なお、今後はBCPを考慮して、この新データセンターにもインターネットアクセスポイントを設ける計画だという。

(→次ページ、今夏には対外接続280Gbpsへ拡張、インフラ担当者の使命とは)