人間が1000回操作したと仮定して画像を生成する

Paints-Undoはどんな仕組みで動いているのか。

Paints-Undoはまだ論文として発表されていません。イリヤさんがGithubに発表している情報と、公開しているソースコードがすべてで、全体像は不明です。動画の学習済みデータも付属していますが、どのような特性をもつのかは部分的にしかわかりません。

情報が限られるなか、技術を理解するためには、抹茶もなかさんの詳細な解説記事がわかりやすいです。世界的に見てもここまで詳しい記事は他にないのではないかと思います。

筆者が記事を理解した範囲では、Paints-Undoの中核をなす技術は、キーフレームの生成過程を複数枚に生成する段階で使用する「シングルフレームモデル(single-frame model)」と、生成した画像の間を補完する動画を生成する「マルチフレームモデル(multi-frame model)」という2つのモデルです。

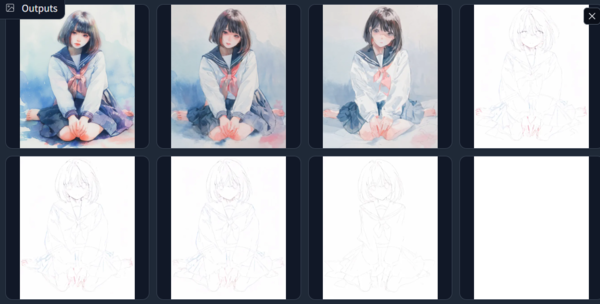

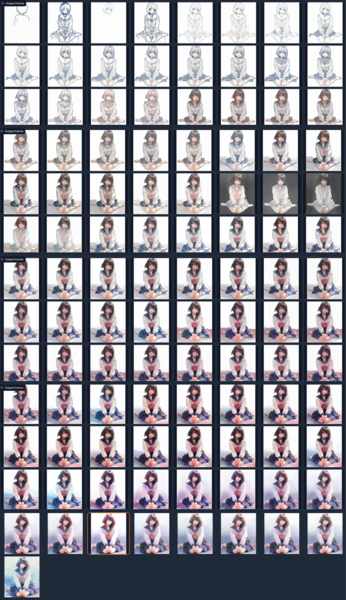

キーフレームを生成するために使われるシングルフレームモデルは、1つのイラストが完成するまでに人間が1000回操作する(過程段階の画像を作る)という前提で推論をさせています。最初の完成画像から、ひたすら「Ctrl+z(つまりUndo)」を1000回繰り返したら、最後は白紙の画像になるという想定です。デフォルトでは「400、600、800、900、950、999」の6枚が指定されており、数値が大きいほど、白紙に近づいた状態を推定して画像を作っていきます。そして指定した枚数の画像を推論し、生成します。

このなかで抹茶もなかさんが「こんなことができるんだ」と驚かれていたのは、過程段階の画像を生成している最中に、最初の画像を介入させられるということ。つまり、デノイズ途中の画像に「完成した画像」をはさむことで、最初の画像に近いものを常に生成し続けられるようにコントロールしているのではないかというわけです。

生成した画像同士を“中割”的につないでいく

そして次にマルチフレームモデルを使い、画像と画像の間を補間して動画にする形で画像を追加生成します。ここで使われるのが、今年1月に登場した「Video Crafter」と呼ばれる系統の動画生成技術。ただ、基本部分はすべて実装しなおしたとイリヤさんは明らかにしています。さらに、この派生技術で5月に登場した「ToonCrafter」というアニメ系に特化したモデルがあるのですが、その技術の一部をそのまま使ってもいるようです。

ToonCrafterは、2枚の画像を使い、その間を補完する画像を生成する技術。アニメの中割りを自動生成する可能性が模索されています。

ただ、日本では発表当初はあまり話題にならなかった技術です。アニメの中割を本格的にやらせるには、全然違う絵が出してしまったり、アニメーションのパターンが少なく、きれいに出ない傾向があり、まだまだ実用的には感じられなかったためです。イリヤさんは、これをイラストの作成過程という、対象がほとんど動かないというものに使うことで効果的にすることを思いついたようです。そこにタイ厶ラプス的なランダムさを混ぜることで、逆により真実味を感じさせる動画になるのだろうと。

最終的にそれをつないで出力すると、あたかもタイムラプス動画が作られたように見えるというのがPaints-Undoのからくりです。実際のところは、ToonCrafterが簡単に破綻するように、人間が描くタイムラプスとはかなり違ったものができあがり、破綻する場合も多いのですが、一見破綻してもわかりにくい動画であるために、真実性が感じられるようになっているのがミソです。

タイムラプス動画で学習?

完全に筆者の推測ではあるのですが、イリヤさんが作り上げた2つのモデルは、ネット上に公開されている絵を描くタイムラプス動画を使って学習させたのかなという予感があります。かなり様々な独自改造が施されているようなのですが、それでも、これは実際のタイムラプス動画を学習に使わないと生み出せないのではないかと思えるからです。

LumaAIで着彩過程を表現できないかと思ったが流石に無理があった。着彩のエフェクトにはなっているが、過程はもっと分割してランダムさがでないと無理かな。でも、やっていることは根本的には違わないと思う。細かく過程を生成しているかという違い。 pic.twitter.com/sW3phWoI1b

— 新清士@(生成AI)インディゲーム開発者 (@kiyoshi_shin) July 10, 2024

▲筆者が別の動画生成AIサービスLuma AI Dream Machineで、塗りがない状態と着彩画像を試しに設定してみて作成した動画。色を塗る効果は出ているが、着色過程を再現しているとはまったく言えない。このサービスではタイムラプス動画を学習していないように思える

連載第62回で紹介した「MagicTime」のように、タイムラプス風の動画を生成する研究は2024年に入って出てきています。 タイムラプス動画を学習させれば、タイムラプス風の動画を生成することが実際に可能であることはすでに証明されています。MagicTimeはタイムラプス風の動画を約2200個学習させて作られおり、まだまだ品質には限界があるものの、植物の成長や、氷の融解、「マインクラフト」の建物建設の動きといった、物理法則を再現しする動画の生成を実現に成功しています。

ただ、次々に新しい研究トピックを探求し、少ない労力で効果的な手法を探っていくイリヤさんの性格を考えると、学習させたのはせいぜい数百点程度と限られるのではないかとも推測しています。何を動画の学習元としたのかは、動画生成AI各社でも権利問題が争点となっている部分なので、論文の発表時には明らかにする点かもしれませんが、現状は情報を意図的に公開していないのだろうと見ています。証拠はないので、確定とは言えませんが。

この連載の記事

-

第145回

AI

ComfyUI、画像生成AI「Anima」共同開発 アニメ系モデルで“SDXL超え”狙う -

第144回

AI

わずか4秒の音声からクローン完成 音声生成AIの実力が想像以上だった -

第143回

AI

AIエージェントが書いた“異世界転生”、人間が書いた小説と見分けるのが難しいレベルに -

第142回

AI

数枚の画像とAI動画で“VTuber”ができる!? 「MotionPNG Tuber」という新発想 -

第141回

AI

AIエージェントにお金を払えば、誰でもゲームを作れてしまうという衝撃の事実 開発者の仕事はどうなる? -

第140回

AI

3Dモデル生成AIのレベルが上がった 画像→3Dキャラ→動画化が現実的に -

第139回

AI

AIフェイクはここまで来た 自分の顔で試して分かった“違和感”と恐怖 -

第138回

AI

数百万人が使う“AI彼女”アプリ「SillyTavern」が面白い -

第137回

AI

画像生成AI「Nano Banana Pro」で判明した“ストーリーボード革命” -

第136回

AI

画像生成AIの歴史を変えたNano Banana “一貫性の壁”が突破された2025年を振り返る -

第135回

AI

実在感が恐ろしいレベル 画像生成AIの常識をひっくり返した「Nano Banana Pro」 - この連載の一覧へ