OpenAIは5月13日(現地時間)、「Spring Update」と題したをオンラインプレゼンテーションを配信。新しい大規模言語モデル(LLM)「GPT-4o(オー)」お披露目のほか、mac OS用デスクトップアプリや各種無料化施策なども発表した。

テキスト理解力は過去最高

GPT-4oは、これまでのフラッグシップモデル「GPT-4 Turbo」と同等の性能を持ちながら、より高速化され、テキスト、音声、画像の理解力も大幅に向上したという触れ込みの最新LLMだ。

ちなみにGPT-4oの「o」は、「すべての」「全てを含む」という意味を持つラテン語の接頭辞「omni(オムニ)」から来ている。

以前から得意な英語とプログラムコードに関してはGPT-4 Turboと同等の性能を発揮し、英語以外の言語のテキストでは大幅な改善がみられるという。

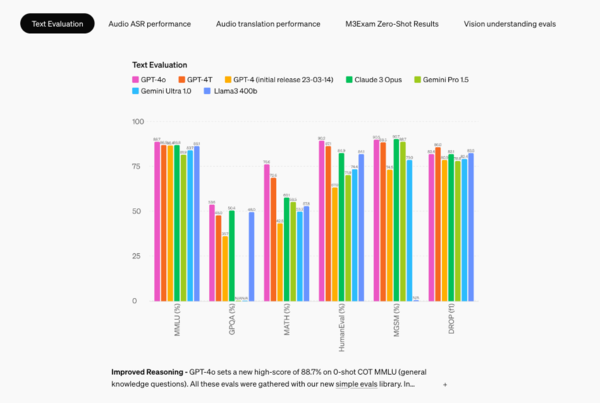

ベンチマーク(OpenAIが提供するsimple-evals)の結果を見てみると、MMLU(大規模マルチタスク言語理解)、GPQA(一般的な質問応答)、MATH(高度な数学)、Human Eval(プログラミング)の各分野でGPT-4 Turboや他社LLMを押さえて最高値を出している。MGSM(多層的意味一致)とDROP(段落にわたる離散的推論)では負けているものもあるが、いずれにせよ現在のところ最高峰レベルと言ってしまってもいいだろう。

だが、真にすごいのは、音声、画像を含めたマルチモーダルな理解力だ。

段違いの画像認識能力

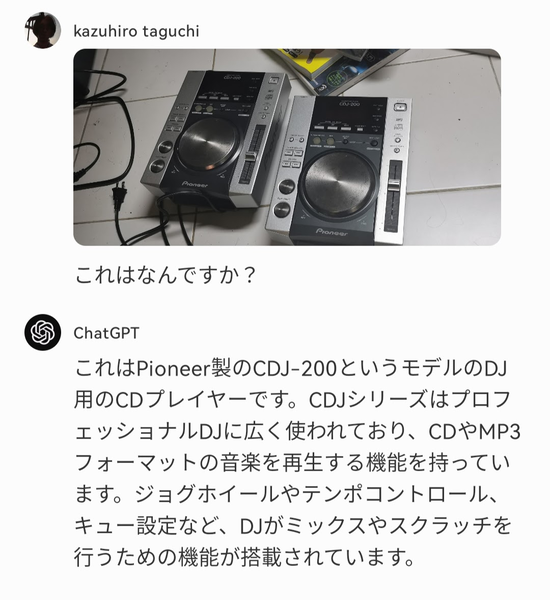

「GPT-4oは画像の理解において既存のどのモデルよりも優れている」とOpenAIは主張しており、例えば「他の言語で書かれたメニューの写真を撮ってGPT-4oに翻訳を依頼し、その料理の歴史や重要性について学んだり、おすすめを聞いたりすることができる」といった例をあげている。

ガジェットを撮影して聞いてみたところ、メーカー、モデル名と共に簡単な機能紹介まで表示されている。実在する有名人についてこれは誰かとたずねても、問題なく答えてくれた。

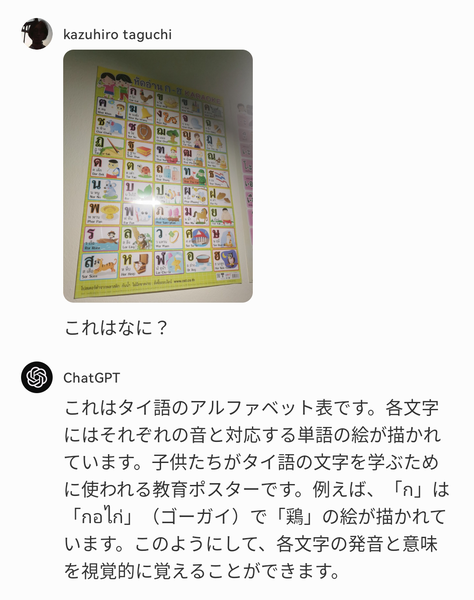

こちらはタイ語の「あいうえお」表だが、「"ก"は"กอไก่"(ゴーガイ)で”鶏”の絵が描かれています」と、仕組みやタイ語の読み方まで正確に理解していることがわかる。

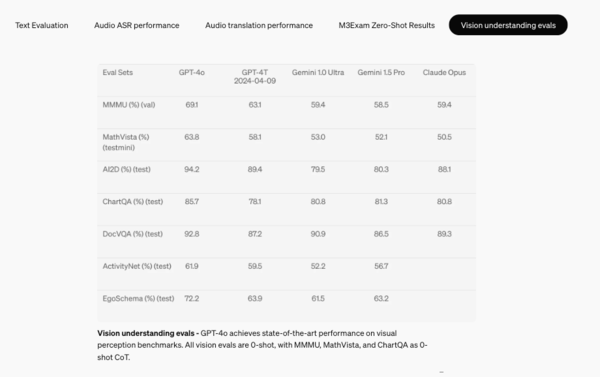

こちらは画像認識のベンチマーク結果だ。すべての項目でGPT-4 Turboや他社のLLMを上回っている。