Datadog、2023年の「コンテナ利用における10のインサイト」を発表

サーバーレスコンテナの採用は46%に増加、3大クラウドでGoogle Cloudが最多

2024年01月09日 07時00分更新

Datadog Japanは、2023年12月21日、最新のコンテナ利用実態についての調査レポートを発表した。

本調査は、グローバルのDatadogユーザーにより実行されたコンテナデータを年次でまとめているもので、2023年は、同年9月の24億以上のコンテナのデータを対象に「コンテナ利用に関する10のインサイト」と題している。

詳細を説明したDatadog Japanのシニアテクニカルエバンジェリスト 萩野たいじ氏は、「コンテナを導入することで3つのベネフィットがある。1つ目は、マネジメントが容易になること。特にサーバーレスのアプローチにより、実行や保守、スケーリングに必要なプロビジョニングや管理が低減する。2つ目は、コスト削減。クラウドプロバイダーがサーバーレスコンテナを管理してくれ、リソースの利用やクラウドの支出を最適化できる。3つ目は、GPUコンピューティングの実装が容易になること。ハードとしてのGPUは不足しており、実装までに時間がかかるのがコンテナに任せられる」と説明する。

コンテナユーザーの46%がサーバーレスコンテナを利用、Google Cloudが最多

同調査の1つ目のインサイトは「サーバーレスコンテナの採用は増加の一途」。コンテナユーザーのサーバーレスコンテナの利用は、2年前の同月調査の31%から増加し続け、本調査では46%になった。

萩野氏は、「多くのユーザーがコンテナ利用を成熟させるにつれ、サーバーレスコンテナにより運用のオーバーヘッドを削減して開発の俊敏性を高めるという、次のステップに進んでいる」と説明。クラウドプロバイダーが、サーバーレスコンテナのインフラをプロビジョニングして管理するため、ユーザーはリソース利用の最適化を進めて、新たなワークロードを迅速に立ち上げることができる。

また、3大クラウドのうち、Google Cloudでのサーバーレスコンテナの採用が68%と最多となった。「これは2022年8月に、Google CloudのサーバーレスコンテナであるCloud Run上に構築された第2世代のCloud Functionsがリリースされたからではないか」と萩野氏は考察する。

2つ目のインサイトは「コンテナでのGPU使用量は増加傾向」。GPUは、従来コンピューターグラフィックやアニメーションなど、計算負荷の高いアプリケーションに利用されていたが、現在は、マシンラーニング(ML)や大規模言語モデル(LLM)の効率的な学習や推論の実行、大規模データセットの処理などにも利用される。

これらのワークロードを調査すると、コンテナ化されたGPUベースのインスタンスによる計算時間が前年比で58%増加していたという。一方で、非コンテナ化のGPUベースの計算時間は、25%の増加でとどまった。「AIやMLのワークロードに必要なデータ処理の規模が大きくなり、コストメリットを引き出すために、コンテナ上のGPUベースのコンピュートの成長が上回っているのではないか」と萩野氏。

3つ目のインサイトは「Armベースのコンピュートの採用がここ1年で2倍以上に増加」。コンテナに最適化されたArmベースのインスタンスは、エネルギー消費量と発熱量が少ないとされ、x86ベースのインスタンスに比べ20%もコストが削減できるという。

同調査では、マネージドKubernetesサービスユーザーにおけるArmインスタンスの採用率が、過去1年間で2.6%から7.1%に増加したという。「コストメリットを得るためにArmへの移行が増えていると考えられるが、プログラミング言語やライブラリ、フレームワークの互換性を確保して、アプリケーションのリファクタリングをする必要がある」と萩野氏。

4つ目のインサイトは「Kubernetes採用組織の過半数が水平ポッド自動スケーリング(HPA)を採用」。クラウドの主な利点として、需要の変動に合わせてインフラを拡張できる弾力性がある。そして、Kubernetesでは弾力性をサポートする機能として、HPAという水平方向へのポッドのオートスケーリングを用意している。これは、負荷に応じて自動でポッドのデプロイやスケールバックが行われる機能だ。

Kubernetesユーザーの半数以上がワークロードのスケーリングにHPAを利用しており、その80%以上がクラスタの半分以上で、さらに45%はすべてのクラスタでHPAを有効にしているという。「HPAの人気は、Kubernetesが時間をかけて、同機能を強化してきたから」と萩野氏。

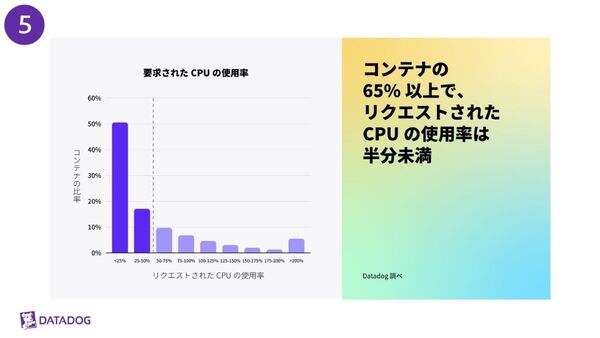

5つ目のインサイトは「コンテナの65%以上で、リクエストされたCPUとメモリの使用率が半分未満」。Kubernetesユーザーは、コンテナが最低限のリソースにアクセスできるようリクエストを設定できるが、Kubernetesのワークロードの65%以上で、要求されたCPUとメモリの半分未満しか使用していないという結果が得られたという。

「このことは、ワークロードのサイジングの最適化がいかに困難かを表している。エンドユーザーに影響を与えるのを避けるため、追加コストが発生したとしてもリソースを過剰にプロビジョニングすることを選択するのではないか。リソースの利用を最適化してインフラコストを削減していく余地はまだ十分ある」と萩野氏。

その要因として萩野氏は、互換性のある、または利用可能なコスト最適化ツールが少ないからではないかと分析する。Kubernetesのバーティカルポッドオートスケーラー(VPA)は、CPUとメモリの要求と制限を過去のリソース使用量に基づき推奨するが、VPAを利用しているユーザーは1%未満だという。本機能がベータ版であり、HPAとの併用が推奨されないなどの制限があるからだと、Datadogは推測している。