ロードマップでわかる!当世プロセッサー事情 第632回

Intel 7とTSMC N5で構成されるHPC向けGPUのPonte Vecchio インテル GPUロードマップ

2021年09月13日 12時00分更新

Ponte Vecchioは

合計47 Tileで構成される

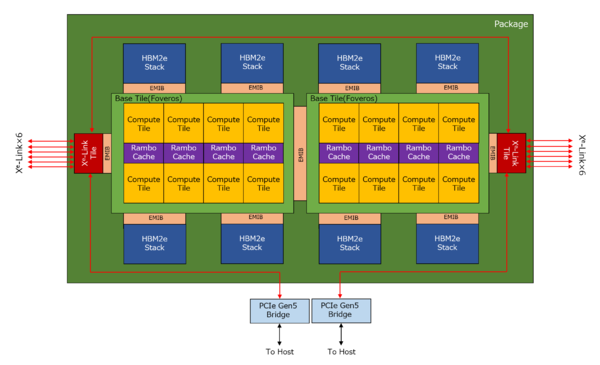

前ページにある情報をベースにPVC 2TことPonte Vecchioの構成をまとめたのが下図である。パッケージにはBase Tileが2つ載り、各々のBase Tileの上にはCompute Tile×8とRambo Cache×4がFoverosで接続されている。

また、それぞれのBase TileからEMIB経由でHBM Stack×4とXe-Link Tile×1が接続されている。そしてBase Tile同士もEMIBで接続されるというわけだ。これで合計47 Tile(EMIBもTileとして数える)という構成である。

連載569回で説明した構成では、1つのRambo CacheにCompute Tileが4つ付く構造になっていたが、そもそもこちらは概念図のようなものなので、実際には2つのCompute TileにRambo Cacheが1つ付き、そのRambo CacheからHBM2eがぶら下がる格好になると思われる。

HBM2eのコントローラーそのものは、Base Tileに載っているのではないかと思う。そしてXe-Linkであるが、各Xe-Linkから8本のLinkが出るが、ウチ1本はパッケージ内で2つのBase Tileの接続に、さらにもう1本はパッケージの外にあるXe-Link/PCIe Gen5 Brigeに接続されるものと考えられる。

確証があるわけではないのだが、Ponte VecchioのOAMに載っている謎の2つのチップが、このXe-Link/PCIe Gen5 Bridgeではないかという気がする。

PMICには大きすぎる気がするし、他のモジュールへのReTimerという可能性もあるが、Xe-Linkのままではホストと接続する方法がないので、どこかにブリッジが必要なのは事実で、このチップがブリッジではないかと筆者は考えている

外部出力がなぜ6本かというと、そもそもシステムでは4つのPonte Vecchioを1つのサブシステムとして扱っている。したがって、これをすべて1:1接続にするためには、各Ponte VecchioのXe-Linkは自分以外の7つのXe-Linkに接続しなければならない。ただ上の図で描いたようにうち1本はパッケージ内を通って接続されるので、外部接続は6本あれば済む計算だ。

パッケージサイズは77.5×62.5mmと判明

資料には4スタックらしき画像があるが……これはいったい?

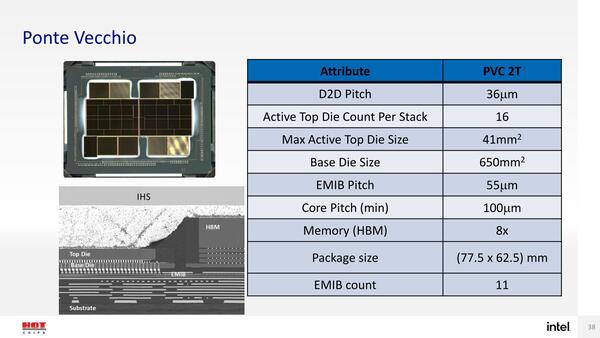

HotChips 33のカンファレンスセッションでの情報はこの程度だが、こちらもチュートリアルセッションでいろいろ話が出てきた。まずPonte Vecchioのパッケージサイズだが、77.5×62.5mmとなかなかのサイズ。もっともHBMを8つも搭載していることを考えれば、そう大きくもないかもしれない。

それよりも興味深いのは“PVC 2T”という表記だ。“2T”ということは、“1T”や“4T”があっても不思議ではない。実際、Ponte Vecchioは物理的には綺麗に2つに分離しており、間をEMIBでつないでいるだけなので、PVC 1Tを作るのはかなり容易だ。

一方4Tの方は、説明の途中でこんな図(下の画像右下)が出てきて、「これは何だ?」という話になった。

この図の説明を求めて速攻でRaja Koduri氏に突撃した人がおり、その答えがこちら。

???♂?seems like the digital legos are easier to build than the real one..inspired by you we keep ‘nom nomming “ those extra “stacks” there’s no 4-stack ponte vecchio ??

— Raja Koduri (@Rajaontheedge) August 23, 2021

「実際のチップと違って、『デジタルレゴ』ではこういうものが簡単に作れるからね。(この図は)余分な“Stack”が載ってるが、4 StackのPonte Vecchioは存在しない」という返事である。

ただ、Auroraに向けては2 Stack構成でいいかもしれないが、今後幅広くPonte Vecchioを売っていくつもりなら、派生型として1 Stack製品があっても不思議ではない。4 Stackは正直実現可能性は低そうに思えるのだが。

Xe-Linkの帯域を使いきるには

EMIBの信号速度がネックになる

あともう1つ、EMIBについて。下の画像は従来型パッケージとEMIBの特性を比較したものだが、配線密度はEMIBの方が上がるのは事実で、Bump Pitch(パッケージの底面にある半田ボールの間隔)は従来型の半分であり、配線密度はラフに言って4倍にできることになる。

それはいいのだが、Pin Speedそのものは、従来パッケージが最大16Gbpsまでいけるのに対し、EMIBでは5.4Gbps程度となっている。これはHBM2eの実装には困らないが、UPI 2.0や今回のXe-Linkの実装にはやや厳しい数字である。

前回は触れなかったが、Sapphire Rapidsの場合、UPIが24bit幅でしかも16Gbpsとなっている。24bitという幅もよくわからない(16bit Data+4bit Address+4bit ECCあたりだろうか?)のだが、それよりも16GbpsともなるとそのままではEMIBで利用できないことになる。

これは一応策があり、送信側は16Gbpsのレーンを4Gbps×4に変換し、受信側で4Gbps×4を16Gbps×1に変換してやれば良いことになる。MUX/DEMUXなどと呼ばれる(イーサネットの世界ではこれをギアボックスと呼ぶ)が、多少オーバーヘッドはあるものの信号速度が落ちる分安定度はあがるし、EMIBを使えば信号本数が増えても十分対応できる。

Ponte VecchioではXe-Linkの帯域は90Gbpsを超えるとしている。おそらく1レーンあたり10Gbps超ということだろうが、ということはBase TileとXe-Link Tileの間は、これも5.4Gbpsを超えないように、1レーン分あたり2本以上の配線を使って接続していることになる。なんというか、いろいろ大変だなぁと思わざるをえない。というか、予想外にEMIBに厳しい制限がついていることに驚いた。

Foverosの方は、こうした信号速度に関する制限の話は今のところ開示されていないが、こちらはどの程度までいけるのか気になるところである。

この連載の記事

-

第770回

PC

キーボードとマウスをつなぐDINおよびPS/2コネクター 消え去ったI/F史 -

第769回

PC

HDDのコントローラーとI/Fを一体化して爆発的に普及したIDE 消え去ったI/F史 -

第768回

PC

AIアクセラレーター「Gaudi 3」の性能は前世代の2~4倍 インテル CPUロードマップ -

第767回

PC

Lunar LakeはWindows 12の要件である40TOPSを超えるNPU性能 インテル CPUロードマップ -

第766回

デジタル

Instinct MI300のI/OダイはXCDとCCDのどちらにも搭載できる驚きの構造 AMD GPUロードマップ -

第765回

PC

GB200 Grace Blackwell SuperchipのTDPは1200W NVIDIA GPUロードマップ -

第764回

PC

B100は1ダイあたりの性能がH100を下回るがAI性能はH100の5倍 NVIDIA GPUロードマップ -

第763回

PC

FDD/HDDをつなぐため急速に普及したSASI 消え去ったI/F史 -

第762回

PC

測定器やFDDなどどんな機器も接続できたGPIB 消え去ったI/F史 -

第761回

PC

Intel 14Aの量産は2年遅れの2028年? 半導体生産2位を目指すインテル インテル CPUロードマップ -

第760回

PC

14nmを再構築したIntel 12が2027年に登場すればおもしろいことになりそう インテル CPUロードマップ - この連載の一覧へ