AI推論に不向きというx86の弱点を補うため

AI向けコプロセッサーを内蔵

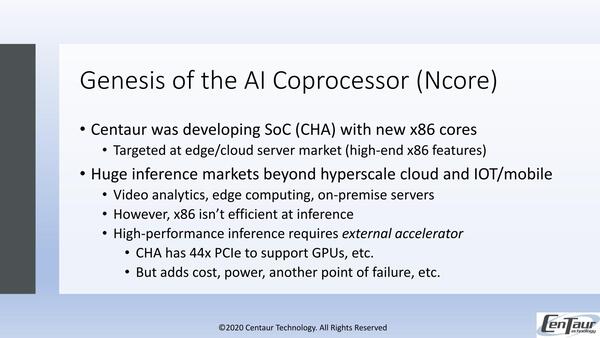

CHA+Ncoreの開発動機は下の画像の通り。もともとのCHAは、ZhaoxinがKX-6000シリーズとして提供しているものの後継を目指したSoCだったようで、ターゲットはサーバー市場である。

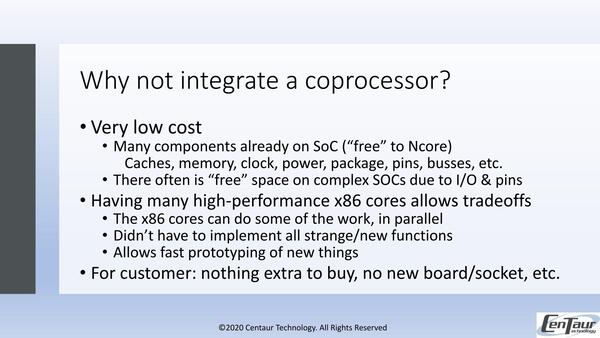

CHA+Ncoreの開発動機。CHAそのものは汎用で特にAIに向けたものではなく、例えばEdge Compute Serverを構築したければ、44レーンのPCI ExpressにそれこそNVIDIAのTeslaを4枚装着して、あとは10GbEカードなどをやはりPCI Expressでつなぐといった形を想定していた模様

といってもCentaurの場合は企業向けというよりも、エッジサーバーやクラウド向けで、どちらもそれほどの高い性能は必要ない。ここに向けて8コアのSoC構成だったのがオリジナルのCHAである。ただx86そのものはそもそもAIの推論に向いてないし、もっと言えば学習にも向いていない。

ではどうするか、というのは各社各様である。AMDは「推論も学習もGPUでやった方が効率が良い」というスタンスで、今のところCPU側にそれを取り込む計画はない(と言いつつも、トレンドにあわせて少しづつサポートするデータ型を増やすといった対応はしているが)。

逆に積極的なのがインテルで、AVX512のニューラルネットワーク拡張(AVX512VNNI)やCooper LakeでのBfloat16のサポートなど、本来AI処理に不向きなx86を力業で向く構造にしてしまっている。

これに対してCentaurは、素直にAI向けコプロセッサーを内蔵するという方法を選択した。

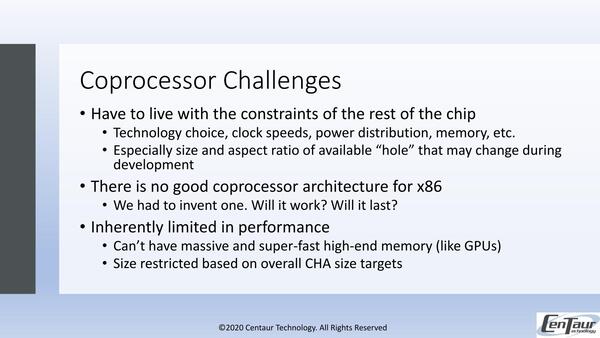

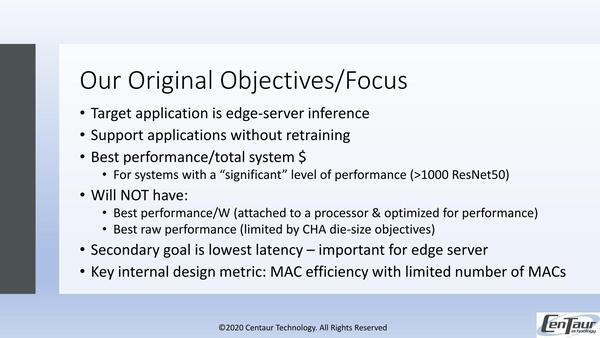

もちろんこの方式でもいろいろチャレンジはあるわけで、その結果としてCentaurはコストあたり最大の性能を第一目標、低いレイテンシーを第二目標に定めた。

この連載の記事

-

第768回

PC

AIアクセラレーター「Gaudi 3」の性能は前世代の2~4倍 インテル CPUロードマップ -

第767回

PC

Lunar LakeはWindows 12の要件である40TOPSを超えるNPU性能 インテル CPUロードマップ -

第766回

デジタル

Instinct MI300のI/OダイはXCDとCCDのどちらにも搭載できる驚きの構造 AMD GPUロードマップ -

第765回

PC

GB200 Grace Blackwell SuperchipのTDPは1200W NVIDIA GPUロードマップ -

第764回

PC

B100は1ダイあたりの性能がH100を下回るがAI性能はH100の5倍 NVIDIA GPUロードマップ -

第763回

PC

FDD/HDDをつなぐため急速に普及したSASI 消え去ったI/F史 -

第762回

PC

測定器やFDDなどどんな機器も接続できたGPIB 消え去ったI/F史 -

第761回

PC

Intel 14Aの量産は2年遅れの2028年? 半導体生産2位を目指すインテル インテル CPUロードマップ -

第760回

PC

14nmを再構築したIntel 12が2027年に登場すればおもしろいことになりそう インテル CPUロードマップ -

第759回

PC

プリンター接続で業界標準になったセントロニクスI/F 消え去ったI/F史 -

第758回

PC

モデムをつなぐのに必要だったRS-232-CというシリアルI/F 消え去ったI/F史 - この連載の一覧へ