AIと人間のより良い関係を模索するIBMの“AI倫理”リーダー、データバイアスなどの課題を説明

これからのAIには「常識や倫理観」も必要、IBM研究者が語る

2017年10月17日 07時00分更新

10月13日、IBMリサーチで「AI Ethics(人工知能の倫理)」のグローバルリーダーを務めるフランチェスカ・ロッシ氏が来日し、記者ラウンドテーブルを開催。IBMにおけるAIへの取り組みや、将来に向けた課題や解決の方向性などについて説明した。

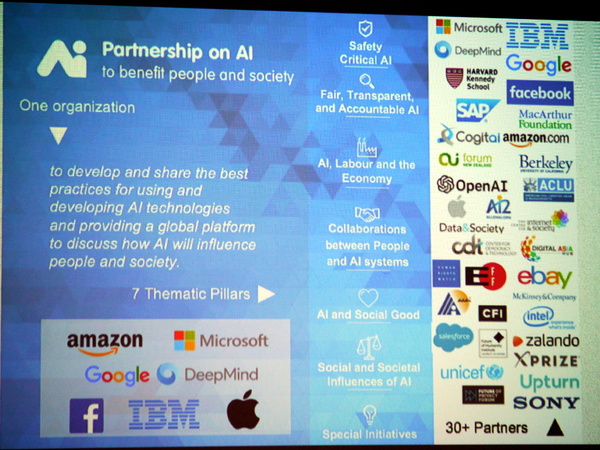

ロッシ氏はIBMワトソン研究所の上級研究員であり、AIシステムの開発や、AIのふるまいにおける倫理についての第一人者として知られる。IBMがAmazon.comやFacebook、Microsoftなどと設立した業界団体「Partnership on AI」においては、IBMの代表を務めている。

人間の意思決定をより良くサポートするために、AIにも「常識」が必要だ

AI技術が急速に進化し、われわれの生活の中にも徐々に定着しつつあることは、皆さんもご存じのとおりだ。ロッシ氏は、現在のAIに急速な進化は「アルゴリズムの進化」「指数関数的に増大するデータを使った学習」「コンピューティングパワーの指数関数的な向上」という3つの要素が偶然に重なり合ったことがもたらした、と説明する。

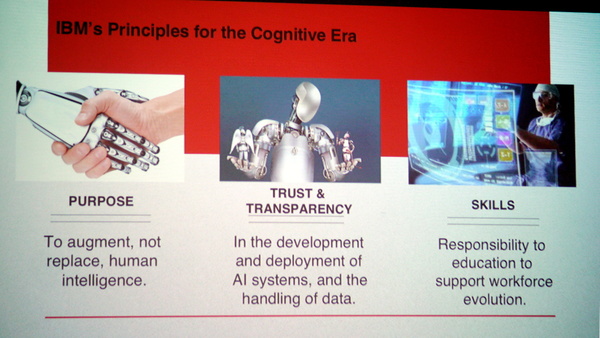

IBMでは古くからAI/コグニティブ技術の研究開発や実用化を進めてきたが、IBMが考えるAIの方向性は人間を置き換えるものなどではなく、あくまでも「人間の能力を補完し、人間と共存するもの」だという。

「IBMが考えるAIは、人間の能力を補完し、人間と共存するもの。現段階では、専門家の意思決定能力をAIが補完するという役割が多い。あくまでも人間の知能を強化する手段であり、人間の役割を置き換えるものではない」(ロッシ氏)

事実、IBMとして今年(2017年)1月に発表したAIに関する指針においても、IBMが開発に取り組んでいくAI/コグニティブシステムは「人間の知性を拡張する(Augment Human Intelligence)ためのもの」と定義されており、「現実的に意識を持ったり、独立した存在となることはない」「すべては人間がコントロールし続ける」ことが強調されている。

意思決定のサポート役として、AIにはたくさんの強みがある。人間が扱いきれない大量のデータを理解し、しかもデータに基づいた根拠のある洞察を行うことができる。人間とは違って、意思決定において感情や先入観によるバイアスがかからない。

より良いサポート役になるためにも、マシン側が「より深く」人間の自然言語を理解しなければならず、さらにはAIにも「一定の常識」や「人間の感情への理解」が必要になると、ロッシ氏は指摘する。

「AIと人間がやりとりをするなかで、人間ならば当たり前に考えていることを、いちいちAIに伝えなくてはならないというのでは使いにくい。それを解決するには、AIが一定の常識を持たなくてはならない。また、人の感情というものを理解し、それに合わせてわかりやすい言葉で対話ができるようにしなくてはならない。こうした常識や感情の理解も、大量のデータを活用した機械学習で、繰り返し学習させることで達成させることができ、AIと人間のよりスムーズなやり取りが実現する」

AIに「倫理観」を持たせること、そして人間からの信頼を得ること

「常識」に加えて、AIに「倫理観」を持たせることも大きな課題だと、ロッシ氏は明確に述べた。

「倫理的、あるいは常識的に判断するという面では、人間のほうが優れている」「たとえば、医師に対してAIシステムが『この治療をしたほうが良い』と指示する場合、医師とAIが同じ倫理的な価値観を共有していることが前提でなければならない。AIは(人間の)倫理的なルールを守った提案をすることができ、なおかつ価値観に整合性があり、信頼できることが大切である。また、異なる価値観で推論が発生した場合には、解決するにはどうしたらいいのかということも考えなくてはいけない」

とはいえ、倫理観や価値観は国ごとに違ったり、文化的な背景からも異なることが多い。

「AIを搭載したコンパニオンロボットを世界中で売りたいとすれば、文化圏ごとにその設定を変えなくてはならないだろう。たとえば、『祖母』という言葉で画像検索した際、Googleが表示したのは白人の高齢女性の画像だけで、黒人やアジア人は出てこなかった。これは、AIが『正しい』データを取り込みつつも、(そのデータに元々バイアスがかかっているため)『不適切な』結果を導き出したという例だ。どのようにしてこうしたバイアスを排除したり、軽減したりできるかを考えなくてはならない」

そして、最終的に重要な課題は「AIが人間から信用されること」だという。そのためにはまず、AIを開発する人間が信頼されなければならず、「IBMが開発するAIならば信頼できる」と言われるようになることを目指したいと、ロッシ氏は語った。

「IBMは106年の歴史を持つ会社であり、長年に渡って社会課題を解決してきた、課題解決を常に考えている会社だ。これが、IBMのAIに対する信頼感の第一歩となる」

もちろん、IBMという企業への信頼感だけでAIに対する全面的な信頼が得られるとは考えていないという。技術的、論理的にも信頼のできるAIでなくてはならず、その鍵を握るのは、なぜその答えを出したのかを合理的に説明できる「説明能力」ではないかという。

「わたしは、世界中のAIは『説明能力』を持たなくてはならないと考えている。『なぜこの答えを出したのか』『なぜこの選択肢がほかの選択肢よりもいいのか』ということを、透明性のあるかたちで示す能力だ。機械学習やビッグデータに基づく結論は、説明が不透明になりがちであり、人間とは異なる推論をした場合でも、その理由(なぜ)がブラックボックスとなっているのは事実である。ここはAIの研究レベルから議論していく必要があるだろう」

文化や価値観の異なる日本企業のPartnership on AIへの参加を期待

ロッシ氏は、IBMのほかAmazon.comやFacebook、Google、Apple、Microsoftなどが参加し、AIに関してオープンに議論する「Partnership on AI」の活動についても紹介した。

Partnership on AIは、実世界でAI技術/サービスを展開している企業が参加して、前述したようなAIにまつわる各種課題を話し合い、将来的な方向性を模索するための業界団体だ。現在は「安全なAI」や「公正で透明、説明責任を持つAI」「労働や経済に貢献するAI」など、7つの課題について議論を行っているという。

「ただし、この組織は、限られたメンバー企業だけで未来のAIのあり方を決めようというものではない。何らかの規則を定め、すべての企業に押しつけるようなものではなく、ベストプラクティスを生み出し、(強制力のない)ガイドラインを策定していくことを考えている」

Partnership on AI の会合は、2週間に一度のペースで開催されており、メンバー企業に加えてあらゆる分野の専門家が参加して「AIはどうあるべきか」を議論している。その顔ぶれは、たとえばAI技術者だけでなく、社会学者や心理学者、ユーザー、なかにはSF作家も参加しているという。

「異なった分野の専門家が参加しているため、意見が分かれる場合もあり、ひとつの意見に収束することが難しい場合も多い。それでも、こうしたオープンなプラットフォームの上で議論する仕組みは大切だ。ひとつの企業だけなら方向性もまとめやすいが、それでは誰の役にも立たないだろう」

なお現在、Partnership on AIには、前述した中心メンバー企業6社に加えて30以上の組織が参加しており、企業だけでなく学会や研究所なども含まれる。ただし、日本の企業で参加しているのはソニーだけであり、ロッシ氏は「もっと日本のパートナーが参加してくれることを期待している」と述べた。前述したとおり、異なる文化や倫理観、価値観をもっと取り込むことが必要だからだ。

また、IBMではマサチューセッツ工科大学(MIT)と共同で、マサチューセッツ州ケンブリッジに「MIT-IBM Watson AI Lab」を設立することも発表している。今後10年間で2億4000万ドルを投資し、AIのアルゴリズム開発や、物理学の観点からのAI研究、ヘルスケア分野やサイバーセキュリティ分野への適用に焦点を当てたAI研究のほか、AIによる共存共栄を目指す研究などを行う計画だと、ロッシ氏は説明した。