国内の”知の最前線”から、変革の先の起こり得る未来を伝えるアスキーエキスパート。ニコンの坪井聡一郎氏による技術とイノベーションについてのコラムをお届けします。

デジタルにかかわるビジネスをしている人にとって、「機械学習」という言葉を耳にしない日はないだろう。私も画像を扱う企業に勤めながら、継続的に知見を高めるようにしている。しかしながらさまざまな人と話す中で、機械学習の中でも特にディープラーニングについて「データを自動で学習分析できる魔法の箱」のように思っている人も少なくない。

ブラックボックスのようにみえるディープラーニングの情報処理や、そもそもの数学に対する苦手意識などもそのように思い込ませてしまっている要因のように思われ、巷間、機械学習を学ぶ講座なども花盛りである。多くは、Pythonなどのプログラミング言語を教えたり、必要最低限の数学処理を教えたりと、学びがデータ処理側に寄っているように感じている。

そこで今回はプログラミングや数学的なデータ処理の話としてではなく、ビジネス創造の視点で機械学習を扱う上での課題について論じてみたい。機械学習を活用する際に生じるビジネス上のボトルネックとして議題にしたいのは「機械学習の学習時間」の問題である。

自動走行実験の走行距離

Googleの自動走行実験については長らく牛耳を集めていたが、昨年正式に開発を断念し、大きな話題となった。反対にTeslaは実用化に向けたマイルストーンの発表を行なうなど積極的な姿勢を示している。両社の差について、「ソフトウェア企業のGoogle」と「ハードウェア企業のTesla」の差が成果の違いとなったという議論もあったが、共通して課題になると思われるのが、機械学習の難しさである。

Googleの自動運転車は実験開始から6年経った2015年段階で、累積走行距離が170万マイル(約270万キロメートル)に達したと発表されている(ITmedia)。赤道1周が約4万キロであり、この時点で地球を67.5周している計算になる。

一方のTeslaについては、2016年段階で自動運転モードの走行距離が2億2200万マイル(約3億5500万キロメートル)に達したことをイーロン・マスクCEOが発表している(日経新聞)。

これだけの距離を学習させても実用化に至らなかったGoogleと、それを凌駕する学習を行なっているTesla社。普通の企業であれば、この長年の学習に対する投資継続だけでも、会社経営の重要な意思決定事項になるレベルであろう。脆弱な財務基盤の企業ではあっという間に投資が尽きてしまう。

このように機械学習をビジネスで利用できるようになるためには、とてつもなく長い学習時間が必要なケースがあるのだ。逆の言い方をすると、われわれの期待する自動走行の未来には、それだけの投資をし続けられる企業のみが最初の果実を得られる世界であるともいえる。

Amazon EchoとSiriの聞き取り

Amazon Echoが北米で発売された当初、現地に赴いた日本のTVレポーターが英語(non-native)で話しかけようとしてうまく作動しないというニュース番組が流れていた。レポーターは自嘲気味に「私の発音では聞き取れないようなので、もっと英語を勉強します」というようなコメントを発していた。おそらくその時点ではnon-nativeの日本人が話す英語をうまく聞き取るとることができない状態だったのだろう。

音声モデルは一般的に「音響モデル(音と文字の対応)」と「言語モデル(文法や語法などの組み合わせ)」が重要である。そしてその学習には、音声ライブラリーのようなものを利用して音声認識のインターフェースは開発されていると考えられる。朝日新聞の記事によると「音声認識ソフトの開発を手掛ける『アドバンスト・メディア』(東京都豊島区)によると、音響モデルでは最低でも数千人、数千時間分。言語モデルでは数十万~数百万語のデータが必要」(3月12日付朝刊)だと紹介している。

再びAmazon Echoに話を戻す。開発の立場を考えると、インターフェースとして学習させるnativeの英語サンプルは比較的手に入りやすく学習させやすい。北米からの販売ということを鑑みると、比較的人口の多い、ヒスパニック系や中国系移民の音声も入手しやすく、機械学習させやすかったのではないかと考えることもできる。

一方で「日本人が日本で習うような英語の発音」のライブラリーが十分にそろっているとは考えにくい。同様にnon-nativeがそれぞれの国で習った癖のある英語の発音を集めたような音声ライブラリーが存在するかというと、その可能性は相当に低いだろう(ライブラリーを作る側の動機として、利用者数の少ないライブラリーを作ってもそもそもお金にならない)。nativeの人間ならある程度想像力も働かせて何を言っているのかを理解できるが、当時のAmazon Echoでは流暢でない発音に反応できていなかった。

同様のことはほかでも見られた。「活舌の悪い芸人」のようなタレントがiPhoneのsiriに向かって話しかけるのだが、ことごとく話している言葉とは違う形で文字変換されるのだ。これも、われわれ人間が聞くと多少活舌が悪かろうとも概ね正しく意味をとることができるのだが、機械学習(とりわけ「教師付き」)の場合では、ある閾値から逸脱したインプットに対して判断ができなくなるという問題がある。母音や子音など人の発する言葉はさまざまな波形を伴い、周辺の環境で響き方が変わったりノイズを含んだりとシチュエーションは千差万別であることから、膨大な学習が必要になる。

しかし、ビジネスの視点で考えるとこれはこれで仕方がないと言える。たとえば日本のように狭い国土でありながら地域ごとに豊かな「訛り(方言)」があるような場合、そのすべてに対応することは極めて困難だろう。ありとあらゆる「訛り」のサンプリングデータを手にして、利用者母数の少ない地域のユーザーをどこまでターゲットにするのかは、経済合理性とのトレードオフだ。これを学習させようとすると、また膨大な時間が追加的にかかってくることとなるだろう。特に初めてローンチするモデルでは、ある程度の仕上がりで市場に出すスピード感のほうが重要であることも少なくない。ここでも学習にかける時間とコストが重要な意思決定課題としてとらえることができる。

Osaroが成し遂げた学習のイノベーション

今や最先端のITビジネスを行なう企業では、こうした「学習の時間」をどれだけ短縮できるのかが重要な経営課題になっている。そしていま、学習時間を短くするビジネスが次々と生まれている。

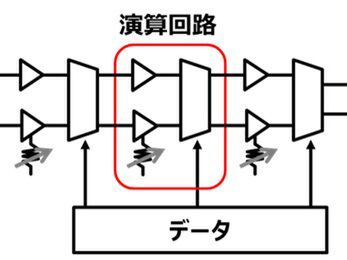

工業用に利用されるロボットはこれまでプログラミングにより動作を決める必要があった。プログラマーは仕様に基づいてプログラムを作りいったん機械に載せる。そして現場にて作動確認を行ない、微妙なズレなどについて細かなプログラミング修正を行なう必要がある。しかしこれを行なうのは手戻りも多く大変骨の折れる作業である。修正に膨大な時間が掛かることも少なくない。

このような課題を解決する手法を生み出し、一昨年以降話題となっているのがOsaroである。同社はAME Cloud VenturesやPayPalの創業者であるピーター・ティール氏からも資金調達をしているスタートアップ企業で「Deep Reinforcement Learning」という方法でアルゴリズム開発を行なっているという。

私もOsaroそのものを目にしたことはないが、いろいろな方々の話をまとめると、下記のようである。

- 生産ラインで単純作業労働を行なっている人間の動きをOsaroに観察させる

- Osaroにはセンサーがあり人の動きを解析する

- そして、動きをプログラミングに置き換えOsaro自らが作動できるようにする

驚くべきことに、人の動きの観察はわずか数回で「模倣」できてしまうという(なかには3回程度で模倣できるものもあるらしい)。このようなことが可能になると、プログラミングにかかっていた時間・人件費などは大幅に削減できるものになる。

確かに人が人にものを教える場合も、単純作業の繰り返しであれば、それほどの時間を要しない。それが機械化移行にあたって、プログラミングにかける時間が長くかかってはもったいない。人間へ教えるような簡易さで、機械に対して教育(学習)がされることになれば大きな進歩ということができる。

事業の視点としても、これまで「機械が導入され、人件費の削減につながった」という置き換え以降のコストの話に注目が集まっていたものが、これからは「機械導入のプログラミング時間の省力化」へとイノベーションが派生してきているのだ。

よりスペシフィックなデータへと進むAIソリューション

音声、動作に続く3つ目の視点として、AIによる意思決定について紹介したい。ここでは「学習時間を短縮する流れ」と同時に生じている「専門性の高いデータを活用する流れ」についての内容である。

近年のAIの進化により意思決定のサポートツールが数多く生み出されている。日立製作所は昨年、経営判断をサポートするAIの開発を行なったことを発表している。

ほかにも、医師が病状を判断する際にかかっている病気の可能性をAIが提示しその判断のサポートをするものや、Watsonによるメニュー提案など、記憶で抜け落ちてしまう可能性がありそうな部分や、よりクリエイティブな発想を伴う意思決定への一助など、AIの活用フィールドは徐々に専門性の高い領域へ広がっている。

私は職業柄デジタル系スタートアップ企業と面会することが多く、そして昨今お会いする企業のほとんどは、何らかの形でAIやそれに類するサービスを取り入れている。今やシリコンバレーでは、チーム内にAIのもととなる機械学習のエンジニアがいなければ企業評価が下がりファンディングに至らないという話も耳にする。そうした中で増えてきた相談は「(AI・機械学習を用いた)サービス開発を行なうため、協力してくれないか」というものである。

ビジネスとして汎用データの活用はやりつくされ、汎用的サービスの開発からスペシフィックな課題に対するソリューションへとフェーズ移行するのは世の流れである。しかし、スタートアップ企業がこうしたビジネスへ展開しようとした場合にボトルネックとなるのは「学習データの入手」である。汎用的な開発であれば世の中に転がっているデータを利用できるが、データが入手しやすいということはそれだけサービス開発の障壁が低く競合環境も厳しい。

一方で大企業側には多くのデータがある。長年にわたり強固なビジネスシステムが形成され活動を行なってきた企業には、固有の、ほかでは手に得難い行動様式や意思決定システムなどが存在する。固有のノウハウといえるものの考え方や手順などが歴史の分だけ蓄積されている。

しかし大企業自身はそれが有用なものとは認識しておらず、新たなビジネスの鉱脈だとは露にも思っていないケースも少なくない。これをデータとして捉えれば、まさに宝の山とも言えるだろう。スタートアップ企業としては、そのデータを学習データとして活用し、自社サービスをリッチに仕上げていきたいと考えるのである。

だが実際にこれを進めようとするとなかなかハードルが高い。こうした情報はどうしても企業の内部情報を含むことになるため、大企業側としてはなかなかデータ提供しづらい。詳述すると、スタートアップは学習に基づいたあるモデルの構築を行ないたいと考える。それがユニークで強いものであれば魅力的な事業となっていくだろう。他社でも応用可能なモデルとなれば、事業のスケールを目指すスタートアップしてはその事業を新たなクライアントでも利用してほしいと考える。

ではデータ提供側である大企業の心理はどうか。最大の問題は、そのデータ・ソースは大企業のものであるため、社外秘となる情報も多く含まれていることである。 彼らは、万が一にでも競合他社で利用されるような状況になってはノウハウの流出につながるのでないかというリスクを懸念する。つまりスペシフィックデータをきっかけに事業スケールを目指したいスタートアップ企業の思惑と、それの提供によるデメリットに躊躇する大企業という構造になっているのである。

さらに付け加えるなら、スペシフィックなデータの機械学習によって生まれた意思決定ソリューション(すなわち成果物)に対する知的財産の所在である。これについてはさまざまなケースが考えられる。厄介なものの1つとして、ある大企業の提供データに基づいて開発された意思決定モデルが、さらに次の企業の提供データを学習させることで進化・成長するようなケースである。どこまでが自社の関与したことになるのか、それも教師付き学習ではないような形でモデルが形成された場合には非常に難しい問題になるだろう。ソリューション・ビジネスを横展開しようとした場合に知的財産の問題に直面する可能性は少なくない。

このように、AI活用ソリューションは専門領域へと触手を広げている。スタートアップ企業があるサービスのヒントを思いつき、ソリューション提供できるプロトタイピングの後に行ないたいことは、実用に耐えられるのかの検証である。しかしスタートアップ企業には自社で検証する力はない。ましてやそれが革新的で前人未到のサービスであれば、多くはライブラリー等も完備されていないのが当然で、だからこそ大企業と組んでサービス向上を図りたいのである。

私はここにイノベーションのヒントが隠されていると感じている。専門的なデータや内部データによるソリューションが抵抗なく利用できる産業や企業はまだまだたくさんあるだろう。それを探し見つける方法というのが1番の近道になるのではないかと考える。

アスキーエキスパート筆者紹介─坪井聡一郎(つぼいそういちろう)

一橋大学大学院商学研究科修了。2004年株式会社ニコン入社。ブランディング、コミュニケーション、消費者調査、デジタルカメラのプロダクト・マネジャー等を歴任。2012年より新事業開発本部。2014年、国立研究開発法人農業・食品産業技術総合研究機構より「センシングによる農作物高付加価値化」の研究委託を受け、コンソーシアムの代表研究員を務めた。経産省主催の「始動Next Innovator2015」のシリコンバレー派遣メンバーであり、最終報告会の発表者5名にも選抜された。