予想通り、GTC 2016でNVIDIAのGP100コアが発表された。今回はこのGP100の内部アーキテクチャーを主に解説しよう。

Pascal世代の想定性能は

単精度で12TFLOPS、倍精度で4TFLOPSあたり

まず製品全般としてのロードマップであるが、前回のロードマップアップデートからほとんど変わらない。唯一違いがあるのは、どうも製品名は4桁にはならない、つまりGeForce GTX 1080にはならないらしい、ということだけである。

では、例えばGeForce GTX R80などになるのかS80になるのか、はたまたZ80なのか、といった具体的な話はまだ伝わって来ていない。とりあえず数字4桁の製品名はあまり好ましくはないと考えているのだそうで、数字は3桁に減らさせることになると思われる。

ちなみにGeForceグレード製品のスペックそのものは相変わらず不明のままで、HBM2/GDDR5X/GDDR5の使い分けかたも、まだ明らかになっていない。このあたりは、もう少し後で論じたいと思う。

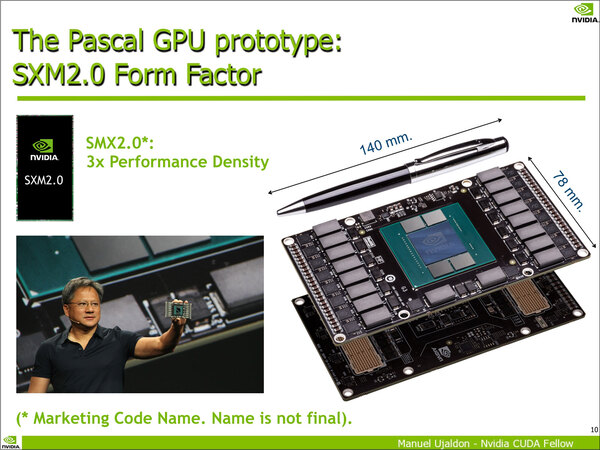

さて、話をGP100に戻そう。昨年6月の話になるのだが、バルセロナ スーパーコンピューティング センターでPACT Cource:Introduction to CUDA Programmingというトレーニングコースが開催された(今年も5月末~6月に開催される)。

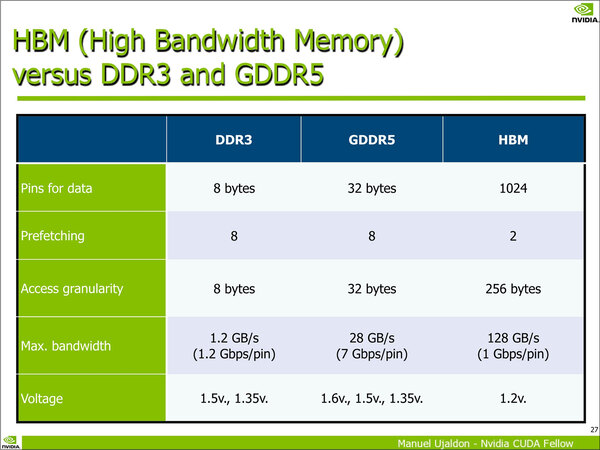

ここで“Innovations and futures of GP memory”というセッションが、NVIDIAのFellowであるManual Ujaldon氏を講師として開催されたのだが、このセッション資料がなかなか興味深いものだった。

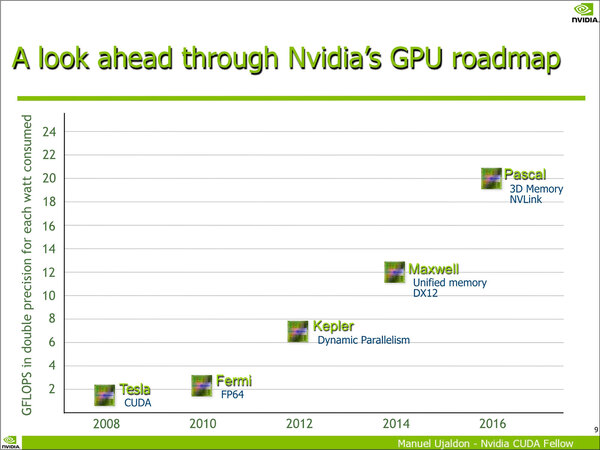

このセッションは、2016年のPascalで3D積層メモリーを採用するという話を前提に、具体的にどんな形で利用可能になるかを論じたものである。

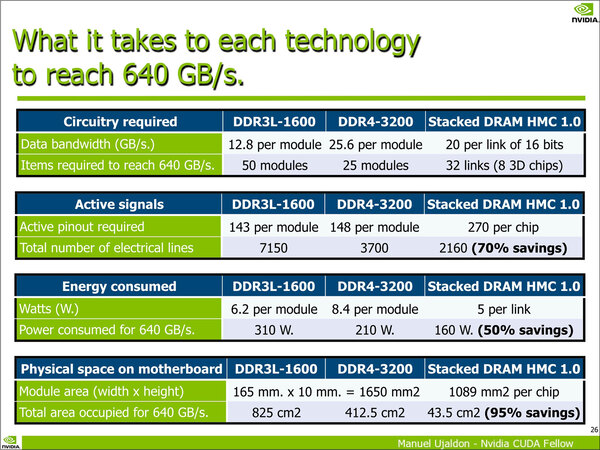

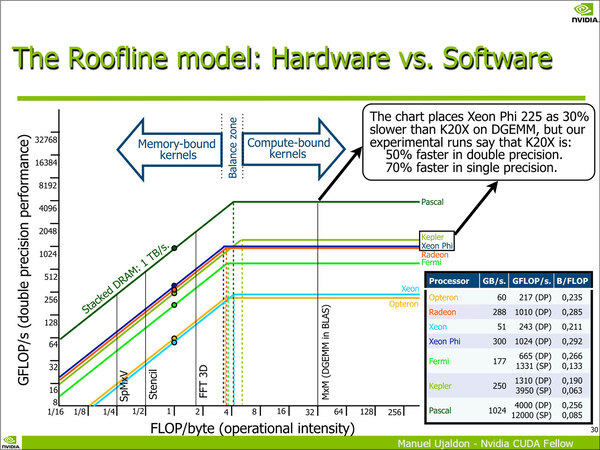

このセッションがおもしろいのは、この時には3D積層メモリーとしてHBMではなくHMCを主に取り上げていたこと、それとPascal世代の性能(単精度で12TFLOPS、倍精度で4TFLOPS)を示していたことだ。

ただスライド全部を見ても、PascalはHMCを使うとはどこにも書いてなく、単にHMC(ないしこれ相当の3D積層メモリー)を使うと、こんな具合に性能が上がるよ、ということでしかない。

そもそもこのセッションは、大学など研究機関の研究者に向けて、CUDAを使うことで高い演算性能を利用できるので使ってほしいという無償のものであり、多分にマーケティング要素が含まれているとは言っても、あからさまな嘘はつけない。

したがって、少なくとも昨年6月の時点におけるPascal世代の想定性能は、単精度で12TFLOPS、倍精度で4TFLOPSあたりを目指していたと思われる。メモリー帯域はHMC 1.0×4と同等の帯域を予定していたというあたりだろう。

この連載の記事

-

第768回

PC

AIアクセラレーター「Gaudi 3」の性能は前世代の2~4倍 インテル CPUロードマップ -

第767回

PC

Lunar LakeはWindows 12の要件である40TOPSを超えるNPU性能 インテル CPUロードマップ -

第766回

デジタル

Instinct MI300のI/OダイはXCDとCCDのどちらにも搭載できる驚きの構造 AMD GPUロードマップ -

第765回

PC

GB200 Grace Blackwell SuperchipのTDPは1200W NVIDIA GPUロードマップ -

第764回

PC

B100は1ダイあたりの性能がH100を下回るがAI性能はH100の5倍 NVIDIA GPUロードマップ -

第763回

PC

FDD/HDDをつなぐため急速に普及したSASI 消え去ったI/F史 -

第762回

PC

測定器やFDDなどどんな機器も接続できたGPIB 消え去ったI/F史 -

第761回

PC

Intel 14Aの量産は2年遅れの2028年? 半導体生産2位を目指すインテル インテル CPUロードマップ -

第760回

PC

14nmを再構築したIntel 12が2027年に登場すればおもしろいことになりそう インテル CPUロードマップ -

第759回

PC

プリンター接続で業界標準になったセントロニクスI/F 消え去ったI/F史 -

第758回

PC

モデムをつなぐのに必要だったRS-232-CというシリアルI/F 消え去ったI/F史 - この連載の一覧へ