ELYZA、「GPT-4」を上回る日本語性能のLLMを開発

ELYZAは6月26日、同社が提供する大規模言語モデル「ELYZA LLM for JP」シリーズの最新モデルとして、Metaの「Llama 3」をベースとした700億パラメーターの「Llama-3-ELYZA-JP-70B」と80億パラメーターの「Llama-3-ELYZA-JP-8B」を開発し、性能を公開した。

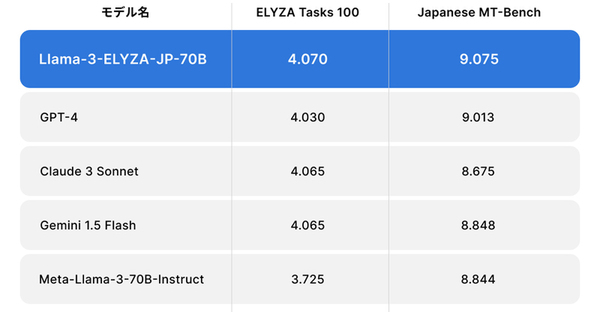

Llama-3-ELYZA-JP-70Bは、Llama-3-70Bをベースに追加の学習(日本語追加事前学習・指示学習)を実施して開発したモデル。元のLlama-3-70Bから大きく日本語性能を向上させており、日本語の性能を測定するための2つのベンチマークを用いた自動評価において、国内モデルの中では最高性能の水準を実現。「GPT-4」や「Claude 3 Sonnet」、「Gemini 1.5 Flash」と同等あるいは上回る性能を達成しているという。

Llama-3-ELYZA-JP-70Bは、安全なAPIサービスや共同開発プロジェクトなどを通して、さまざまな形態で順次企業向けに提供を開始。また、チャット形式のデモサイトを用意。

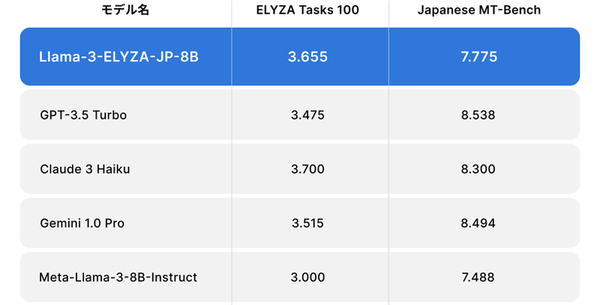

Llama-3-ELYZA-JP-8Bは、MetaのLlama-3-8Bをベースに事後学習(日本語追加事前学習・指示学習)を実施して開発したモデル。Llama-3-ELYZA-JP-70B同様に元のLlama-3-8Bから大きく日本語性能が向上しており、80億パラメーターの軽量なモデルながら日本語の性能を測定するための2つのベンチマークを用いた自動評価において、「GPT-3.5 Turbo」や「Claude 3 Haiku」、「Gemini 1.0 Pro」に匹敵する性能を達成したという。

Llama-3-ELYZA-JP-8Bについて、モデルを一般公開。本モデルはLLAMA 3 COMMUNITY LICENSEに準拠し、Acceptable Use Policyに従う限りにおいて、研究および商業目的での利用が可能。

開発プロセスや評価のより詳細な状況についてはnote記事で解説している。