メタおよび東京大学を含む17の大学による研究グループは11月30日(現地時間)、料理や自転車修理といった複雑な人間の活動を一人称(エゴセントリック)および三人称(エクソセントリック)視点から同時に撮影し、自然言語による注釈を加えた大規模かつマルチモーダルな動画データセットおよびベンチマークタスクを組み合わせた「Ego-Exo4D」を発表した。

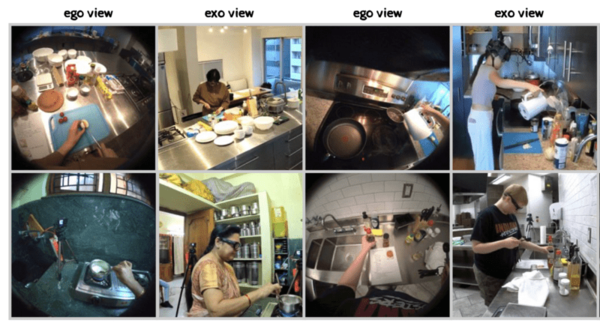

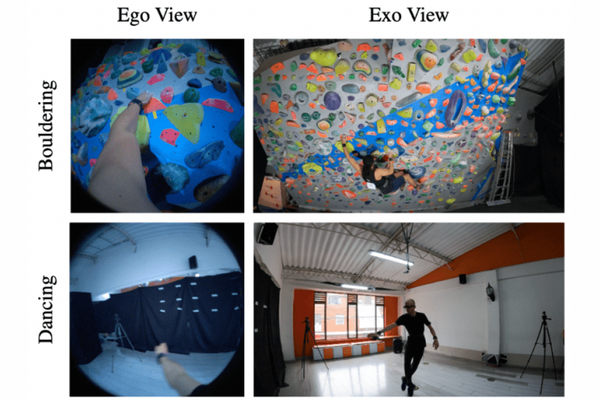

エゴ(一人称)視点とエクソ(三人称)視点を統合

人間の行動、特にスキルと専門知識の理解は、拡張現実(AR)、ロボット学習、ソーシャルネットワーク分析などさまざまな技術分野で重要だが、AIにとっては難しい課題となっている。

Ego-Exo4Dは、手と物体の相互作用、注意の焦点など細かな行動の詳細を捉えるエゴ(一人称)視点と、全体的な動き、身体の姿勢、周囲の環境との関係などを示すエクソ(三人称)視点の2つの動画を同時に撮影し、自然言語による注釈(アノテーション)を加えることによって、人間のスキルと専門知識をより総合的に捉えることを目標としている。

ARグラスと複数のGoProで撮影

データセットは、800人以上の参加者によって世界13都市で撮影された1422時間に及ぶ動画データが元になっている。

動画にはスポーツ、音楽、ダンス、自転車修理など、様々な物理的および手続き的スキルを必要とする13の活動が記録されている。

エゴ視点の動画はメタが開発したARグラス「Aria Glass」を、エクソ視点の動画はAria Glassと同期した複数の「GoPro」カメラを使用して撮影された。

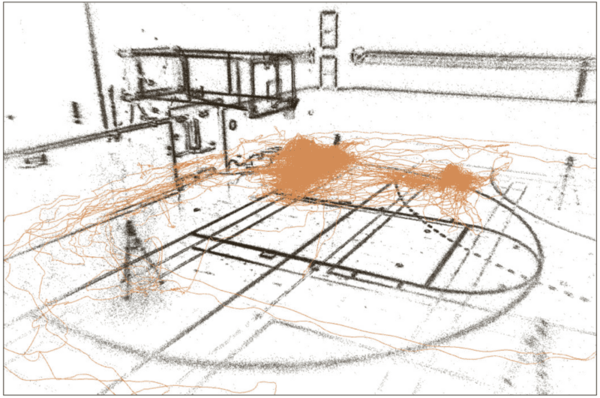

また、動画だけではなく、7つのマイクを使用したマルチチャンネルオーディオ、眼球運動、3Dポイントクラウド、カメラの姿勢、IMU(慣性測定ユニット)、気圧計、磁力計などマルチモーダルなデータが含まれており、人間の行動とスキルを多角的に分析し、理解するための豊富なデータソースとなっている。

動画を補足するアノテーション

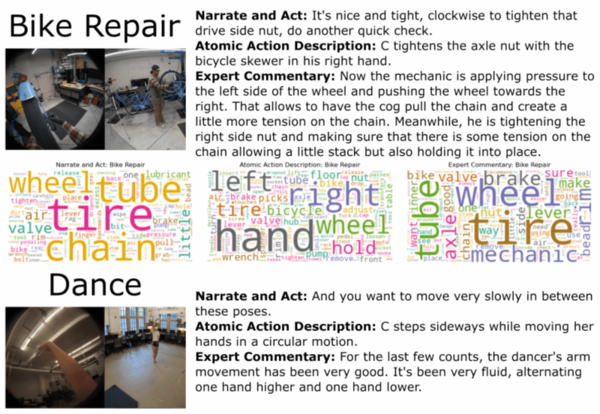

さらに、動画データにはコンテンツの理解を深め、多様なアプリケーションでの使用を促進することを目的に自然言語を用いた下記3種類の注釈(アノテーション)が付けられている。

専門家のコメント(Expert Commentary)各分野の専門家による詳細なコメント。これにより、特定のスキルや手法に関する深い理解が可能になる。

撮影者によるナレーション(Participant Narration)

動画撮影者自身が提供するナレーション。撮影者の視点からの活動の説明や、その時の考え方、意図などが反映されている。

アトミックアクションの記述(Atomic Action Descriptions)

動画内の個々のアクションや動作を具体的に記述したもの。この記述は、動作認識やアクションセグメンテーションなどのタスクに有用。

これらの自然言語の説明を動画と組み合わせることで、研究者や開発者は人間の行動とスキルに関するより豊かな洞察を得ることができるという。

作成したモデルやアルゴリズムを評価するベンチマークタスクも提供

Ego-Exo4Dでは、データセット以外に、研究者が自分のアルゴリズムやシステムを評価し、比較するための4種類のベンチマークタスクを提供している。

エゴ・エクソ関連タスク(Ego-Exo Association Tasks)

エゴ視点とエクソ視点動画間の関連性の特定および理解を評価するタスク。異なる視点からの活動の同期や相関を把握できる。

エゴ・エクソキーステップ認識タスク(Ego-Exo Keystep Recognition Tasks)

特定の活動やプロセス内の重要なステップやキーモーメントを認識するタスク。スキルの学習や指導に重要。

エゴ・エクソ能力推定タスク(Ego-Exo Capability Estimation Tasks)

利用者のスキルや能力を推定するタスク。専門的な技能や学習過程を評価するために役立つ。

エゴポーズタスク(Ego Pose Tasks)

エゴ視点動画から参加者の姿勢や動きを推定するタスク。動作分析や姿勢推定の研究に利用される。

これらのベンチマークタスクはデータセットの多様な特性を活用し、人間の行動とスキルに関する深い洞察を提供。新たなアルゴリズムやシステムの開発と評価に重要な役割を果たすという。

Ego-Exo4Dは12月中にすべてのデータをオープンソースで公開する予定。また、来年には公開ベンチマークチャレンジの開催とベースモデルのリリースも予定されている。

過去に類を見ないスケールで提供される本データセットによって、AIが人間のスキルを効率的に学習できるようになることで、熟練した職人の技を再現するロボットや、より安全な自動運転自動車の開発などさまざまな分野での応用が期待されている。