AWS re:InventのCEO基調講演は生成AIのトピックが中心

生成AIに傾倒するAWS Amazon Qはビジネスユーザーも視野に

2023年11月30日 18時00分更新

生成AIの開発推進に向け、NVIDIAと新しいパートナーシップ

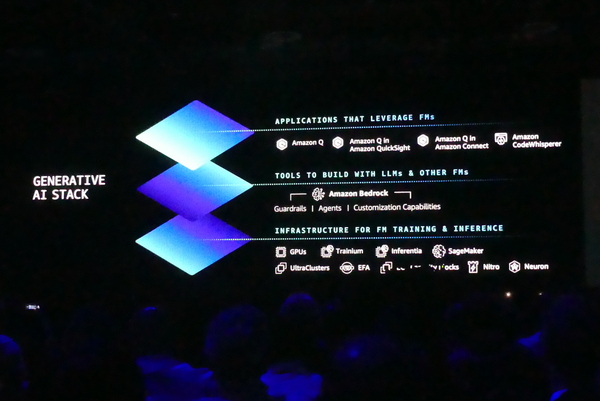

基調講演の大半が割かれたのは、現在IT分野の主戦場となっている生成AIへの取り組みだ。AWSは生成AIに関して、コスト効果の高い学習インフラを提供する基盤層、基盤モデル(FM:Foundation Models)へのアクセス層、そして人材育成まで含めたアプリケーション層の3つの層を用意しており、今年も各層での取り組みが紹介された。

インフラにあたる基盤層では、学習と推論の効率化を提供する。ここではNVIDIAとの新しいパートナーシップが発表された。AWSはGPUを初めてクラウドで提供した事業者でもあり、現在では200万GPU、3000ゼタフロップを展開するに至っている。

今回の新しいパートナーシップでは、まずEC2に最新GPUファミリーとして「H200」「GH400」「L40S」「L4 GPU」が提供される。AWS独自のハイパーバイザーであるNitroを活用し、仮想GPUをベースにしたUltra Clusterを構成することが可能になる。また、NVIDIA Grace Hopper SuperchipをAWS UltraClusterに展開し、初のAIスーパーコンピューターを実現。さらに生成AIの開発を加速するNVIDIAのNeMo LLMフレームワーク、NeMo Retriever and BioNeMoなど、GH200 NVL32を初搭載したNVIDIA GDX CloudもAWS上に展開する。

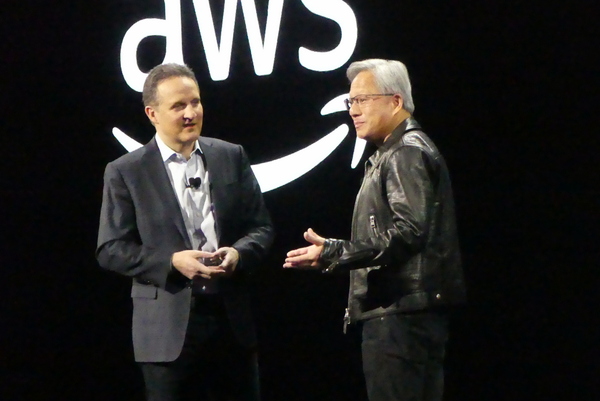

基調講演では、NVIDIA CEOのジェンスン・ファン氏が登壇。ファン氏はこれまでに展開された200万GPU、3000ゼタフロップという実績について「ほとんどの国はエクサクラスが1つあれば十分なのに、われわれは3000もある」と語る。また、今回の提携では「四半期ごとに1ゼタフロップスの展開できる準備ができている」とアピールした。

新たに発表された学習用チップ「Trainium 2」は、前世代よりも4倍のトレーニング処理が高速化を実現。3倍のメモリ容量、エネルギー効率も最大2倍に向上している。Trainium2はEC2 Tm2インスタンスで利用でき、最大で16基を搭載できるという。

さらにAWS Elastic Fabric Adaptorによるペタバイトネットワークで接続される次世代のEC2 Ultra Clusterでは、最大10万のTrainum2チップが利用可能。最大65エクサフロップの処理能力を発揮することで、3000億パラメーターのLLMのトレーニング時間を数ヶ月単位から数週間単位に短縮できるという。また、「EC2 Capacity Block for ML」によって、GPUの予約利用が可能になった。「世界でもっともベストな形でGPUを使えるようになる」とセリプスキー氏はアピールする。

生成AIの安全性にこだわるAWS Antropicとも提携

生成AIを組み込んだアプリケーション開発のために、LLMや他の基盤モデルのアクセスを提供するのはずばりAmazon Bedrcokだ。複数の基盤モデルへのアクセスが可能なBedrockでは、ユーザーにモデルの選択肢を与える。「広範なモデルを選べ、エンタープライズグレードのセキュリティとプライバシーを最初から組み込んでいる。AdidasやNASQAQ、BridgeWaterなど、すでに1万以上のお客さまがBedrockを使ってくれている」とセリプスキー氏は語る。

生成AIのトレンドは非常に変化が速い。「選択肢はいろいろあり、急速に変わっている。あまりにも速いので、機敏に対応することが大事」とセリプスキー氏は語る。たとえば、その点、BedrockはA21LabsのJURASSIC-2、AmazonのAmazon Titan、AnthropicのClaude2、CohereのCommand+Embed、MetaのLLAMA2、Stability.aiのStabble Diffusion XLなどの基盤モデルが利用できる。

ここで登壇したのはAnthropicのCEOダリオ・アモデイ氏だ。安全性の高い基盤モデルCluadeを提供するAnthoropicは会社創設初期からAWSと提携しており、基幹業務でのワークロードに最適な基盤モデルを提供している。また、Anthropic自体がAWSユーザーでもあり、最新のClaude 2.1ではTrainum、Inferentiaを採用。220万トークンをサポートし、ハルシネーションも削減。「独自のモデルを作ること、エコシステムの一例になること、安全で信頼性の得ることを重視している。他と比べて10倍くらい安全という調査もある」とアモデイ氏はアピールする。