新バージョンの「TPU v5e」、NVIDIA H100ベースの新VMなど

“AI一色”のGoogle Cloud Next 2023、「AIを作る」新発表まとめ

2023年09月08日 08時00分更新

Google Cloudは2023年8月29~31日、米サンフランシスコで年次イベント「Google Cloud Next 2023」を開催した。

8月29日の基調講演では、4年前からGoogle Cloudを率いるCEOのトーマス・クリアン氏が1時間半にわたる基調講演で、「AIを作る」「AIを使う」「AIのエコシステム」という3つの側面から、Google Cloudの新サービスや新機能を紹介した。

今回の記事ではまず「AIを作る」領域での新発表などをまとめる。

今年のGoogle Cloud Nextは「AI一色」、GoogleピチャイCEOも登場

クリアン氏がOracleの幹部からGoogle Cloudに移籍して4年、Google Cloudは着実に成長を遂げている。2023年第1四半期には初の黒字化を達成、第2四半期は前年同期比28%増で成長した。

4年ぶりの対面開催となったGoogle Cloud Nextの基調講演で、最初に登場したのはGoogle/Alphabet CEOのスンダー・ピチャイ氏だ。ピチャイ氏は「Google Cloudはトップのエンタープライズカンパニーの1社になった」と宣言する。

Googleは現在全社的にAIに取り組んでおり、今回のイベントもAI一色だった。ピチャイ氏は「Googleは7年前から『AIファーストアプローチ』をとっており、製品をもっと役立つものにするためにAIを適用してきた」と続ける。「次の10年間のミッションを実現するにあたっては、AIがすべての人に役立つものにすることが重要だと考えている」(ピチャイ氏)。

ピチャイ氏は、Googleの検索サービスについて「生成AIを使って検索の体験を再構築する」と述べ、同日試験運用を開始した「Search Generative Experience(SGE)」を紹介した。

また今年5月の「Google I/O」で発表した「Duet AI」の「Duet AI in Google Workspace」を一般提供開始したことや、AIが生成した画像に対してデジタルウォーターマーク(電子すかし)を有効にするなど「勇敢かつ責任のある」かたちでAI戦略を進めると述べた。

「AIを作る」インフラ関連で多くの新発表、NVIDIAとの協業も

続いて登場したクリアン氏は、「AIを作る」「AIを使う」「AIのエコシステム」という3つのトピックにひも付けながら、Google Cloudの最新サービスを紹介した。

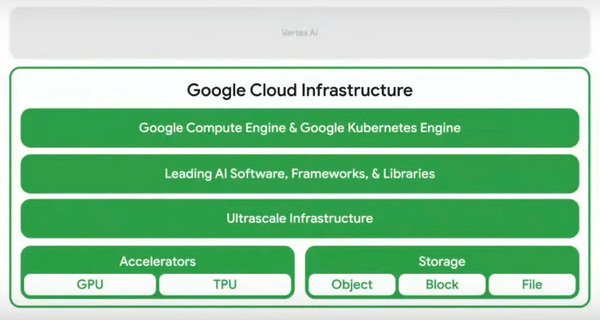

「AIを作る」の最初のテーマは、AIを開発/運用する「AIインフラ」だ。

クリアン氏は、国民向けデジタルサービスのインフラとして「Google Distributed Cloud」を採用したルクセンブル政府、5億ユーザー/550ペタバイトに及ぶ巨大なデータをGoogle Cloudに移行した米Yahooなどの例を紹介しながら、Google Cloudの特徴を「予測可能なパフォーマンス、比類なき信頼性、最高レベルのセキュリティ」だと説明する。そのうえで、AI時代に求められる処理スピードを提供する新サービスとして、以下の6つを発表した。

(1)「TPU v5e」(プレビュー): Google独自設計のAIプロセッサ(TPU:Tensor Processing Unit)。v5eは、前世代(v4e)比で1ドルあたりのトレーニング性能が最大2倍、推論性能が最大2.5倍に強化されている。「複雑なAIモデルを、低コストでサポートする」(クリアン氏)。

(2)「GKE(Google Kubernetes Engine) Enterprise」エディション: マルチクラスタの水平スケーリングをサポート。「生産性は45%改善し、ソフトウェアの実装時間は70%以上削減できる」(クリアン氏)。

(3)「A3 VMs」: NVIDIAの最新のGPU「H100」をベースとしており、「A2と比較してトレーニング性能は3倍、ネットワーク帯域は10倍改善する」(クリアン氏)。

(4)「Titanium System」: 次世代のオフロードアーキテクチャ。「Google CloudのAIインフラの性能優位性を支えている」(クリアン氏)。

(5)最新世代の「Google Distributed Cloud」の一般提供開始: 各国のデータ規制やデータ主権の動きに対応する、分散クラウドを構成できる。

6)「Cross-Cloud Network」(プレビュー): SaaSを含む複数のクラウドにあるアプリケーションの高速な接続とセキュリティ管理を実現する。

ここで、(3)で提携するNVIDIAから、創業者兼CEOのジェンスン・フアン氏が登場し、Google Cloudとの協業について語った。フアン氏は「生成AIはコンピューティングスタックのあらゆるレイヤーを革新している」と述べ、「世界最高レベルの才能を持つ2社が協業して、生成AIのためのクラウドインフラを構築している」と続けた。

フアン氏は、Google Cloudとの協業のポイントを3つ挙げる。1つめは「H100からシステム、ネットワーク、ソフトウェアまでを再構築する」ことで、Google Cloudや「Vertex AI」を加速させるという。

2つめとして、AI特化スパコンをクラウドとして提供する「NVIDIA DGX Cloud」サービスを、Google Cloudに導入する計画も明らかにした。実現すれば、Google CloudのユーザーはDGX Cloudを直接利用できるようになる。

そして3つめはVertex AI、AIモデル、AIソフトウェアの加速だ。

フアン氏はまた、GoogleのJaxベースのLLM構築フレームワーク「PaxML」を、NVIDIAのH100/A100向けに最適化したことも発表した。数週間以内に利用できるようになるという。

NVIDIAとの提携をはじめ、AI開発やAI活用に適した特徴を備えることは、クラウド市場におけるGoogle Cloudの競合差別化につながっているようだ。クリアン氏は「生成AIのユニコーン企業の70%がGoogle Cloudの顧客だ」と胸を張った。