ゲーミングPCでも動作可能な軽量LLMで生成AIビジネスを垂直立ち上げ

日本語に強く、たった130億パラメーター NECが作った国産LLMの価値

2023年07月10日 09時00分更新

NECは、130億パラメーターという軽量化を実現した独自の日本語大規模言語モデル(LLM)を発表した。NEC Corporate EVP兼CTOの西原基夫氏は、「世界トップクラスの日本語性能を有する、軽量なLLMを開発することに成功した。すでにNEC社内で利用を開始しており、文書作成や社内システム開発におけるソースコード作成業務など、さまざまな作業の効率化に応用している」とアピールした。

構想4年、開発2年で全社を挙げて仕上げた独自LLM

ChatGPTをはじめとする生成AIは、急速な勢いで活用が進んでいるが、既存のLLMのほとんどは英語を中心に学習しており、高い日本語性能を有しつつ、各業種の業務で活用するためのカスタマイズが可能なLLMはほぼない状況にある。NECでは、自社で独自のLLMを開発することにより、日本の企業における生成AIのビジネス活用をより加速させ、企業の生産性向上に貢献することを目指すという。

NEC Corporate EVP兼CDOの吉崎敏文氏は、「社内ではG2プロジェクトと呼び、構想4年、開発2年、全社タスクによるプロジェクトに半年間をかけ、全社をあげて完成したものである。LLMを開発しただけでなく、利活用技術をセットにして、サービスとして提供することで、日本の企業が個社サービスとして利用できるようになる。日本の企業に対して、国産で開発した専門性の高いLLMが提供できる」と述べた。

強みは日本語能力の高さ、パラメーターの少なさ

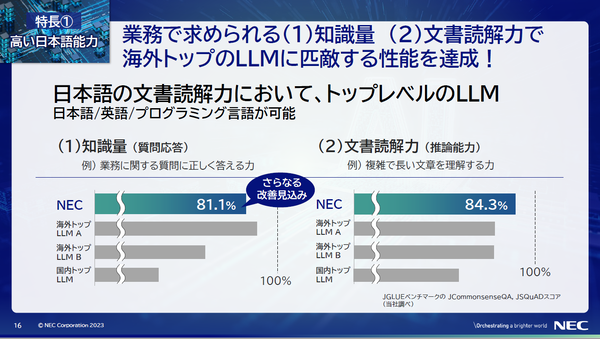

NECが開発した日本語LLMには、2つの技術的特徴がある。1つは、日本語能力が高い点である。

西原CTOは、「日本語のデータを優先して入れたことで、日本語能力を高めることができた。知識量や文書読解力では、海外トップのLLMに匹敵する性能を達成している。業務に関する質問に正しく答える力は81.1%となり、これはさらなる改善が見込める。さらに、複雑で長い文章を理解する力は84.3%と、もっとも高い読解力を持つ」とする。これは、日本語言語理解ベンチマークであるJGLUEを用いて計測であり、海外のトップLLMを上回る実績となっている。

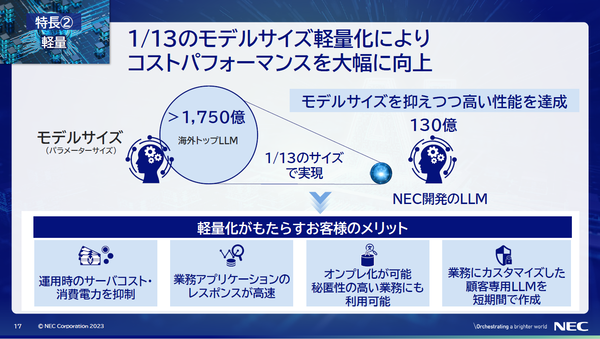

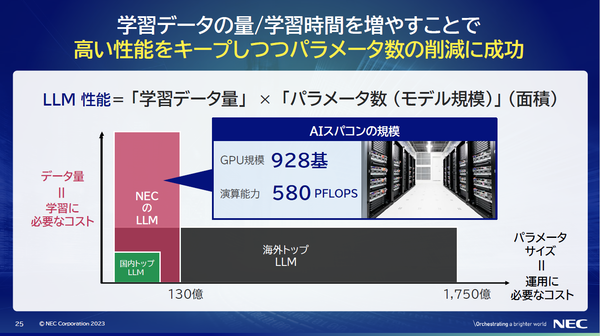

もう1つが、130億パラメーターと軽量である点だ。OpenAIのGPT-3は、1750億パラメーターの規模であり、NECのLLMは1桁少ない規模だ。

NEC データサイエンスラボラトリー 主幹研究員の小山田昌史氏は、「海外トップのLLMを動作させるには、最低でも8枚のGPUが必要であり、一般的なPCやサーバーで動作させることは難しい。NECのLLMは、1枚のGPUから動作させることができ、業務用PCやゲーミングPCでも動作させることが可能だ」とアピールした。

また、西原CTOは、「海外トップのLLMと比較しても、13分の1のモデルサイズに軽量化したことで、運用時のサーバーコストや消費電力を抑制するほか、業務アプリケーションのレスポンスが高速化すること、オンプレミス化が可能になるため、秘匿性の高い業務にも利用可能になること、クローズなデータを活用し、業務にカスタマイズした顧客専用LLMを短期間で作成できるメリットがある」と述べた。

LLMの性能を左右するのはパラメーターサイズだけじゃない

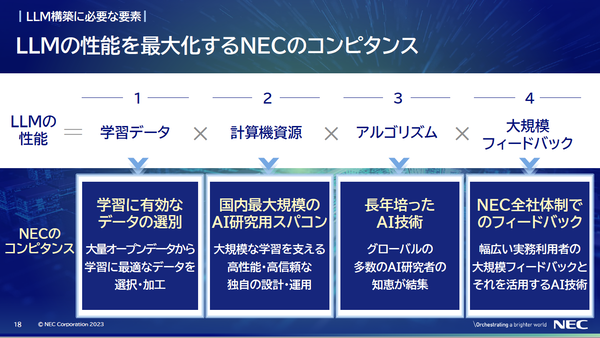

西原CTOによると、LLMの性能を最大化するには、学習データ、計算機資源、アルゴリズム、大規模フィードバックの4点が重要だという。

「NECは、大量のオープンデータから、学習に最適なデータを選択、加工できること、大規模な学習を支える高性能、高信頼の独自設計および運用できる国内最大規模のAI研究用スパコンを有していること、グローバルにおける多数のAI研究者の知恵が結集した長年培ったAI技術があること、NECグループ全体の幅広い実務利用者による大規模フィードバックとそれを活用するAI技術を持っていることが特徴である」と説明する。

NECでは、国内企業では最大規模となるAIスパコンを、2023年3月に全面稼働しており、同AIスパコンは、GPU規模で928基、演算能力は580PFLOPSを誇る。これを活用することで、基盤モデルを1カ月で構築することができた。「並列に走らせることができるスパコンの構築と運用において、信頼性の確保や性能を引き出すミドルウェア、運用ソフトウェアなどのさまざまなノウハウが必要であり、ここにNECの研究者の知見が生かされている」と述べた。

これまでは、学習データ量とパラメーター数でLLMの性能が決まっていたが、NECでは、LLMの性能がパラメーターサイズの他にも、学習に使われた高品質なデータの量や学習時間に左右されることに着目。学習データ量と学習時間を大幅に増やすことで、高い性能をキープしつつ、パラメーター数の削減に成功したという。それを下支えしたのが、国内最大規模となる独自のAIスパコンになる。

また、西原CTOは、「NECは今後もLLMの進化に取り組む一方で、お客様のクローズドデータを統合し、定期的に学習させることで、最新知見に基づく、個社向けモデルや業種特化型モデルを継続的に提供することができる。個社ごとのモデルを持つことは、各社の競争力強化につながる」とした。