ロードマップでわかる!当世プロセッサー事情 第677回

アナログ回路でデジタルより優れた結果を出せるAspinityのAnalogML AIプロセッサーの昨今

2022年07月25日 12時00分更新

アナログ信号のままでニューラルネットワークを通す

AnalogML

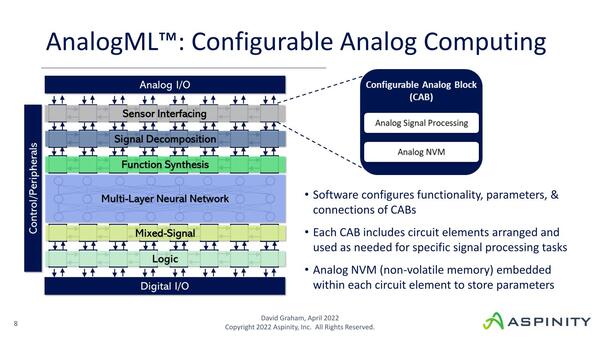

さて今回のAnalogMLであるが、RAMPを使ってフィルタリングだけでなくAIの処理まで行なってしまおう、というものである。

2016年のRAMP 1では、ここで言えばAnalog I/O→Sensor Interface→Signal Decompositionを経て、その先に直接Mided-Signal→Logic→Digital I/Oとなっていた。ここにFunction SynthesisとMulti-Layer Neural Networkを加えたのがAnalogMLというわけだ

といってもRAMPの構造をそのまま引き継いでいるのはCABの部分のみで、その先は今回初実装という形になる。

もともと2016年のRAMP 1の時点で、センサーからの入力をSensor Interface/Signal Decompositionの部分で(=ADCを通す前に)ある程度フィルタリングを行ない、不要なデータをその先に流さないことで効率化を図るという実装はしていた。今回はそれに加え、アナログ信号のままでニューラルネットワークを通すことで、さらにデータを減らせるようになったという仕組みである。

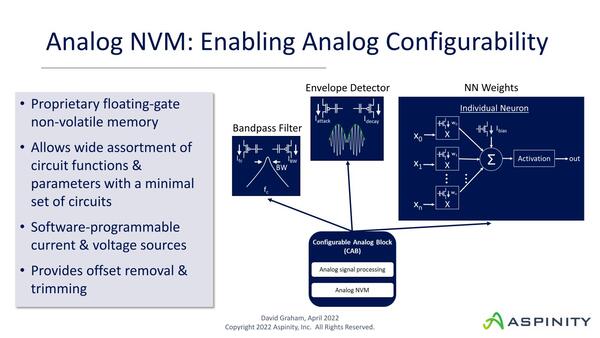

ここでコアになるのがConfigurable Analog Blockで、先に書いたようにNANDフラッシュのセル(ここではAnalog NVMとされている)を利用してアナログのフィルター回路を簡単に構築できるようになっており、まずここで不要なデータを削減。さらにその先でニューラルネットワークを利用してさらにデータ量を減らせるわけだ。

なぜデータ量を減らせるか? といえば、665回のIntel GNAと同じである。Intel GNAと異なりこちらは音声や振動、接触(タッチセンサーの検知)などであるが、ここでは音声を例にとってみたい。

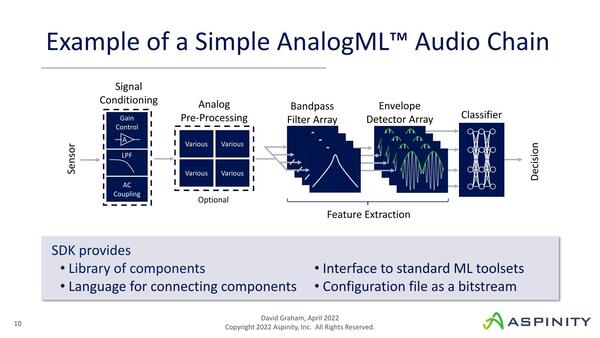

Signal ConditioningやPre-Processingはオプション扱いで、これはAnalogMLには含まれない。これは一般的なオーディオ用のAFE(Analog Front End)の話で、おそらくLPF(Low Pass Filter)などはAnalogMLでも実装は可能であろう

音声であればまず外界音を常時マイクで拾うことになる。ここは常時Onで、オプション扱いのSignal ConditioningやPre-Processingもやはり常時動くことになる。そこからまずBandpass FilterとEnvelope Detector Arrayを通すことで、ノイズ(風切音や周囲の振動音など)を一気に減らす。

この段階でかなり扱うデータ量(音声データ)は減っているので、常にニューラルネットワークが動くわけではない(まずこれで1段目の省電力化が可能になる)。ただ、例えば普通の会話と赤ちゃんの泣き声や動物の鳴き声までこの段階で区別できるか? というとそれは難しい。

そこでその先でニューラルネットワークを通すことで、人間の音声とその他を区分けするとか、突発音(例えばガラスが割られたりドアの開閉などなにかしらの破壊音)を検知することが可能になる。

スマートスピーカーの類なら人間の音声と判断された時だけ、セキュリティーセンサーなら突発音が発生した時だけ、それぞれマイコンを立ち上げてその先の処理ができる。これにより、記事冒頭の画像に出てくるような大幅な省電力化が可能になる、というのがAspinityの説明である。

この連載の記事

-

第864回

PC

なぜAMDはチップレットで勝利したのか? 2万ドルのウェハーから逆算する経済的合理性 -

第863回

PC

銅配線はなぜ限界なのか? ルテニウムへの移行で変わる半導体製造の常識と課題 -

第862回

PC

「ビル100階建て相当」の超難工事! DRAM微細化が限界を超え前人未到の垂直化へ突入 -

第861回

PC

INT4量子化+高度な電圧管理で消費電力60%削減かつ90%性能アップ! Snapdragon X2 Eliteの最先端技術を解説 -

第860回

PC

NVIDIAのVeraとRubinはPCIe Gen6対応、176スレッドの新アーキテクチャー搭載! 最高クラスの性能でAI開発を革新 -

第859回

デジタル

組み込み向けのAMD Ryzen AI Embedded P100シリーズはZen 5を最大6コア搭載で、最大50TOPSのNPU性能を実現 -

第858回

デジタル

CES 2026で実機を披露! AMDが発表した最先端AIラックHeliosの最新仕様を独自解説 -

第857回

PC

FinFETを超えるGAA構造の威力! Samsung推進のMBCFETが実現する高性能チップの未来 -

第856回

PC

Rubin Ultra搭載Kyber Rackが放つ100PFlops級ハイスペック性能と3600GB/s超NVLink接続の秘密を解析 -

第855回

PC

配線太さがジュース缶並み!? 800V DC供給で電力損失7~10%削減を可能にする次世代データセンターラック技術 -

第854回

PC

巨大ラジエーターで熱管理! NVIDIA GB200/300搭載NVL72ラックがもたらす次世代AIインフラの全貌 - この連載の一覧へ