久しぶりに今週はNVIDIAの話だ。前回のロードマップアップデートが連載581回なので半年ぶりである。なぜこんなに空いたかと言えば、新製品がまったく出てこないのが理由である。今年1月に発表になったGeForce RTX 3080 12GBは新製品と言えば新製品だが、基本的にはGeForce RTX 3080 Tiのダウングレード版ということを考えると、バリエーションチェンジの範疇と言えよう。

そんなNVIDIAであるが、3月23日からオンライン開催となったGTC 2022の基調講演で、次世代GPUであるHopperが発表になった。実際にはHopperだけでなく、ものすごく盛り沢山の発表があり、これを全部カバーするのは1本の記事では到底不可能なのだが、現状ではまだ詳細が明らかにされないGraceなどは後回しにして、一番の目玉とでもいうべきHopperことNVIDIA H100 GPUについて今回は説明しよう。

NVIDIAが次世代GPUの“Hopper”こと「GH100」を発表

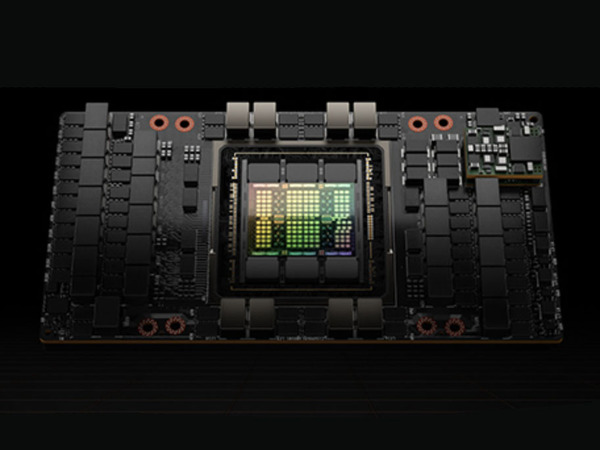

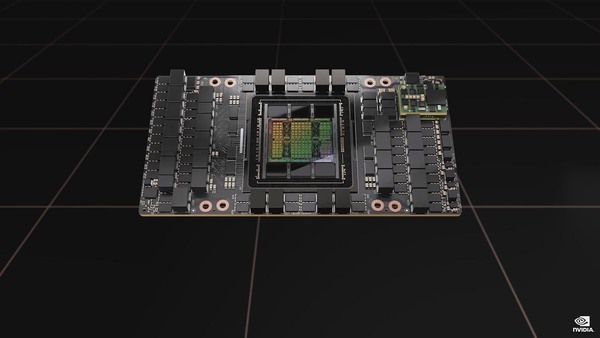

まずはJensen Huang CEOの基調講演から、Hopperに話を絞って説明しよう。Hopperというコード名で開発されたGH100は、HBM3を6つ搭載するやはりお化けチップであった。

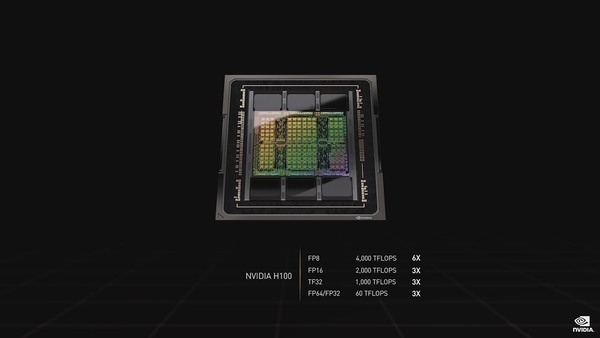

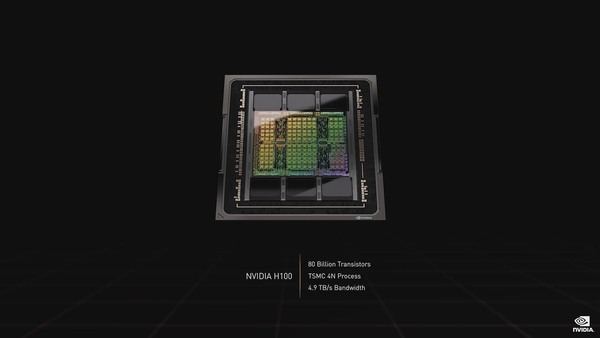

性能はFP32/FP64で60TFlops、AI向けのFP8では4000TFlopsに達する(FP8の話は後述)。TSMCのN4をベースとした、カスタム版の4Nプロセスで製造され、トランジスタ数は800億個に達する。ちなみにダイサイズは814mm2で、おそらくEUVステッパーのReticle Limit(露光できる寸法の限界)ギリギリなのだと思われる。

またこのスライドではNVIDIA H100となっているが、正式にはチップの名称がGH100、これを搭載したモジュールがH100である(わりとこのあたりがNVIDIAの資料を見ているといい加減なのがアレだが)。

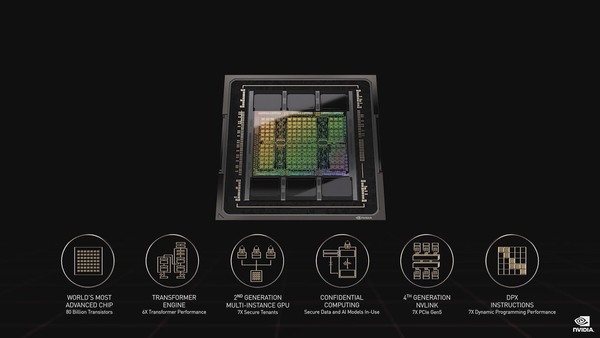

新機能として挙げられているのはTransformer Engine、第2世代のMulti-Instance、Confidential Computing、第4世代NVILink、DPX命令セットなどであるが、これはこの後もう少し詳細な説明があるのでそちらで説明したい。

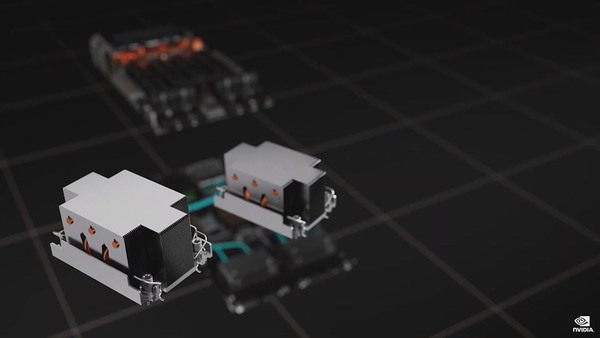

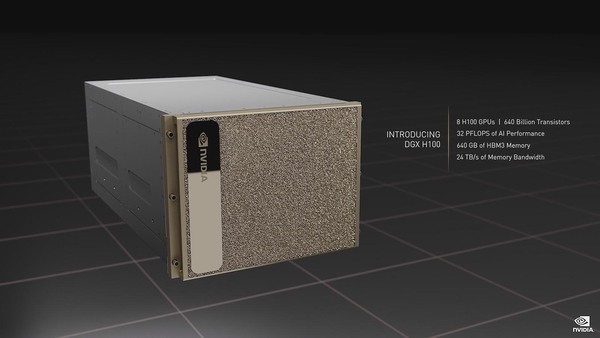

このGH100を搭載したSXMモジュールであるH100は1個あたり700Wの消費電力とされる。このH100を8つ搭載したのがHGX H100となる。そのHGX H100にCPUやNetwork、Storageなどを追加したのがDGX H100である。

Radeon Instinct MI250で採用されたOAMと似たサイズであるが、Radeon Instinct MI250は2ダイで700W。一方こちらは1ダイで700Wである。いろいろな意味ですさまじい

この連載の記事

-

第768回

PC

AIアクセラレーター「Gaudi 3」の性能は前世代の2~4倍 インテル CPUロードマップ -

第767回

PC

Lunar LakeはWindows 12の要件である40TOPSを超えるNPU性能 インテル CPUロードマップ -

第766回

デジタル

Instinct MI300のI/OダイはXCDとCCDのどちらにも搭載できる驚きの構造 AMD GPUロードマップ -

第765回

PC

GB200 Grace Blackwell SuperchipのTDPは1200W NVIDIA GPUロードマップ -

第764回

PC

B100は1ダイあたりの性能がH100を下回るがAI性能はH100の5倍 NVIDIA GPUロードマップ -

第763回

PC

FDD/HDDをつなぐため急速に普及したSASI 消え去ったI/F史 -

第762回

PC

測定器やFDDなどどんな機器も接続できたGPIB 消え去ったI/F史 -

第761回

PC

Intel 14Aの量産は2年遅れの2028年? 半導体生産2位を目指すインテル インテル CPUロードマップ -

第760回

PC

14nmを再構築したIntel 12が2027年に登場すればおもしろいことになりそう インテル CPUロードマップ -

第759回

PC

プリンター接続で業界標準になったセントロニクスI/F 消え去ったI/F史 -

第758回

PC

モデムをつなぐのに必要だったRS-232-CというシリアルI/F 消え去ったI/F史 - この連載の一覧へ