ロードマップでわかる!当世プロセッサー事情 第636回

イロモノだと思っていたSamsungのプロセッサー内蔵メモリーがわりと本気だった AIプロセッサーの昨今

2021年10月11日 12時00分更新

PIMを実装しても消費電力はわずか5.4%の増加で済む

さて、ここからが新情報だ。ISSCCでの話はハードウェア的な機構のみでソフトウェアの話はほぼなかったが、今回まずGPU向けに、PIMを利用するためのソフトウェアスタックが提供されることが明らかになった。

なぜGPU用か? といえば、そもそもHBM2ではCPUに使われるケースが非常に少なく(まもなく登場するSapphire RapidsにはオプションでHBM2を搭載するSKUがあるようだが、現行の汎用CPUでは富士通のA64fxくらいしかない)、ほとんどはGPUかAI向けプロセッサーのみとなる。

その意味ではCPU用よりもGPU用の方が最初の実装には適切ということだろう。ただ実際のテストプラットフォームは、GPUではなくFPGAだったので、その意味ではFPGA向けのスタックも別途開発されているものと思われる。

実際に処理を実行した結果が下の画像だ。縦軸は相対性能であり、HBM2をそのままメモリーとして利用した場合のスコアを1.0とし、NativeかPIM-directかは不明だがPIMに処理させた場合の性能比をグラフとして示したものだ。

興味深いのは、Batch Sizeが小さい場合には大きな性能を発揮するが、Batch Sizeが増えるとむしろ性能が下がることで、このあたりはPIMの構造上、扱うべきデータ量が増えるとBankに収まりきらなくなる、というのが理由かと思われる。

もっともこの結果だが、AI関連の処理(音声認識)などはオフロード(外部のシステムに渡して負荷を分散)した方が有利というのは理解できるが、GEMMに関してはなにしろ扱えるのがFP16のみなので、科学技術系には精度的に利用が難しい。その意味ではやはりAI向けに特化、と考えるのが妥当だと思われる。

一方消費電力に関する分析が下の画像である。当たり前だが、PIMが入る分消費電力の絶対量は増えるが、その一方で処理のためにプロセッサー側から激しくデータアクセスが行なわれることがなくなるため、トータルとしては5.4%の増加に留まるとしている。

講演では実際に処理電力の変動の様子なども示された。これは音声認識の機械学習モデル「Deepspeech 2」をHBM2のみで利用した場合とHBM-PIMで処理した場合の比較で、一番上が処理中の入力波形、中段が入力文章と解析後の文章、下段のグラフがレイテンシーその他のパラメーターで、要するにどちらもほぼ同一の精度で処理を実行できているが、HBM-PIMの方がより高速に処理が可能で、結果として消費電力も少なくなっていることを示している(右側のグラフ)。

これらの比較は(明言されてはいないが)GPUベースで行なった模様だ。これはGPUベンダーにHBM-PIMを送り、これを実装したGPUチップを製造してもらって、あとは自社で評価ボードに載せればできる(この程度のことはSamsungならたやすいだろう)。

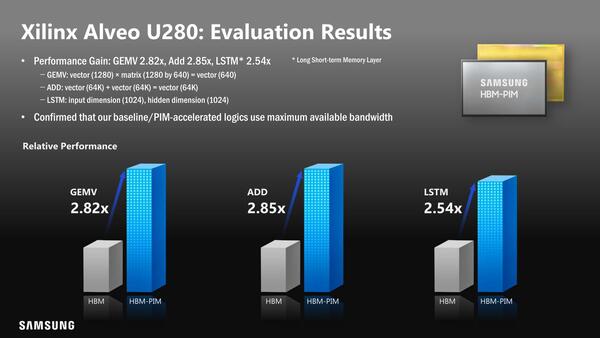

ただこれとは別に、XilinxのAlveo U280というアクセラレーターカードを利用した評価プラットフォームを発表した。このU280にはXilinxのVirtex UltraScale+ HBMというHBMスタックを2つ搭載したFPGAが搭載されているが、このHBMスタックをHBM-PIMに張り替えたものだ。

XilinxのAlveo U280。HBMスタックをHBM-PIMに張り替えたというか、実際にはSamsungからXilinxにHBM-PIMを送って、特別版のVirtex UltraScale+ HBMを製造してもらい、これをベースにAlveo U280を作ってもらったのだろう

これにあわせてFPGA用のソフトウェアスタックも新たに開発したようだ。その結果として、さまざまな処理がFPGA+HBMと比較して2.5倍以上高速化されたとしている。またRNN-Tを実装した場合、性能が2.5倍ほどになり、消費電力を62%削減できたという結果も示された。

この連載の記事

-

第864回

PC

なぜAMDはチップレットで勝利したのか? 2万ドルのウェハーから逆算する経済的合理性 -

第863回

PC

銅配線はなぜ限界なのか? ルテニウムへの移行で変わる半導体製造の常識と課題 -

第862回

PC

「ビル100階建て相当」の超難工事! DRAM微細化が限界を超え前人未到の垂直化へ突入 -

第861回

PC

INT4量子化+高度な電圧管理で消費電力60%削減かつ90%性能アップ! Snapdragon X2 Eliteの最先端技術を解説 -

第860回

PC

NVIDIAのVeraとRubinはPCIe Gen6対応、176スレッドの新アーキテクチャー搭載! 最高クラスの性能でAI開発を革新 -

第859回

デジタル

組み込み向けのAMD Ryzen AI Embedded P100シリーズはZen 5を最大6コア搭載で、最大50TOPSのNPU性能を実現 -

第858回

デジタル

CES 2026で実機を披露! AMDが発表した最先端AIラックHeliosの最新仕様を独自解説 -

第857回

PC

FinFETを超えるGAA構造の威力! Samsung推進のMBCFETが実現する高性能チップの未来 -

第856回

PC

Rubin Ultra搭載Kyber Rackが放つ100PFlops級ハイスペック性能と3600GB/s超NVLink接続の秘密を解析 -

第855回

PC

配線太さがジュース缶並み!? 800V DC供給で電力損失7~10%削減を可能にする次世代データセンターラック技術 -

第854回

PC

巨大ラジエーターで熱管理! NVIDIA GB200/300搭載NVL72ラックがもたらす次世代AIインフラの全貌 - この連載の一覧へ