HBMコントローラーをパッケージにどう収めるか?

もう1つの問題はパッケージサイズとHBMに関わる部分だ。UPIとHBM、つまりEMIBを利用して接続するI/Fに関しては、タイルの最外周に配置する必要がある。電源やDDR5に関しては、Package Substrateの中を通して引っ張り出せるが、EMIB経由ではそうした長い配線は利用できないからだ。

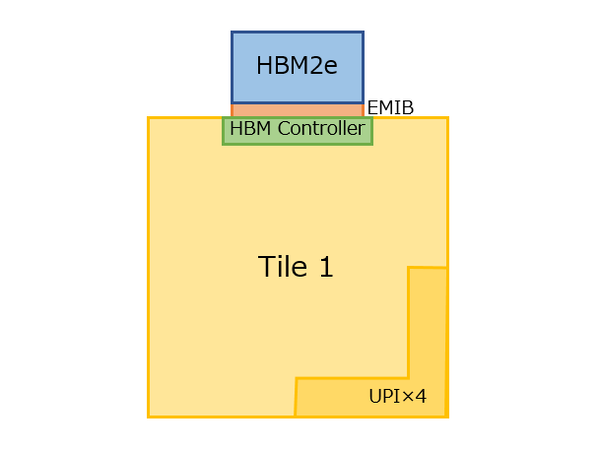

左上のものをTile 1とすると、そのTile 1におけるUPIとHBMのコントローラーの物理的な位置は下図のようになる。

HBM搭載パッケージは長辺方向がさらに伸びるわけで、するとHBM2eのスタックはTile 1の上側に位置することになる。

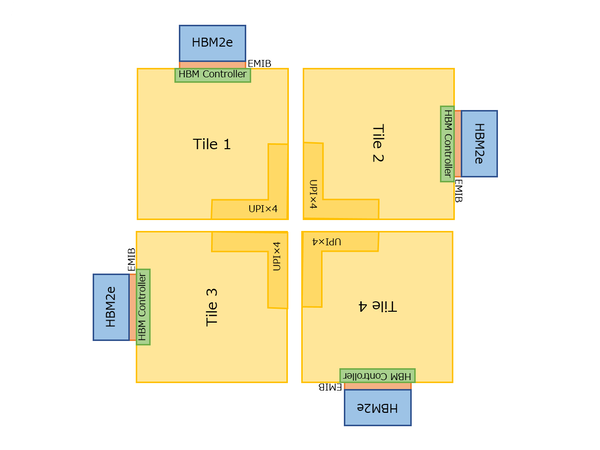

このTileを4つ並べるとどうなるか? というのが下図である。もしSPR HBMが横に広いパッケージになっていれば、図の構成は容易だ。ところが実際には縦方向に長いわけで、図の構成では問題があることになる。

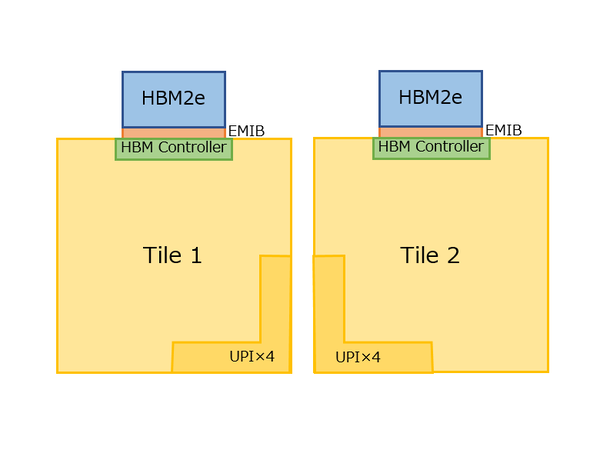

解決策は2案ある。1つはHBMのコントローラーを2つ設け、下図のようにどちらかを使う方法にすることだ。ごらんの通り、これならHBMスタックをタイルの上下に追い出せる。ただしHBMコントローラーを余分に搭載する分、エリアサイズが無駄になる。

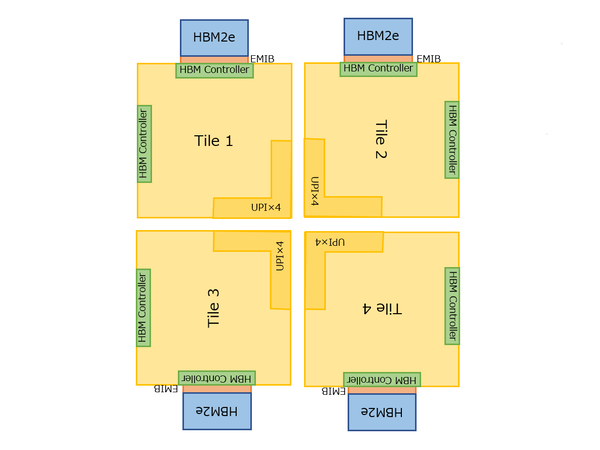

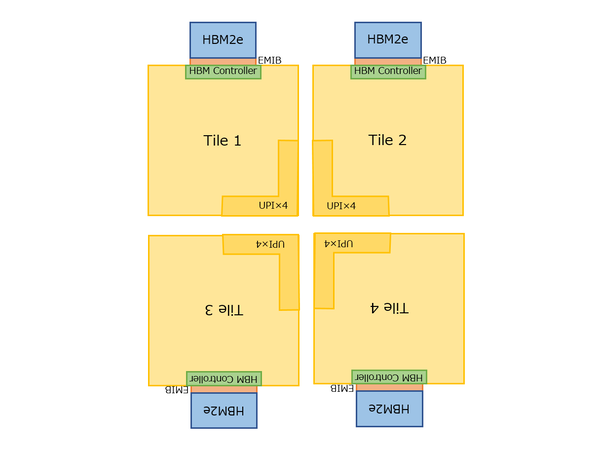

もう一つの案は、下図のように鏡合わせのように2種類のタイルを用意することだ。

こうすると、4タイルの構成も下図のようにHBMスタックを上下に追い出せ、しかも無駄な2つ目のHBMコントローラーを搭載する必要はない。その代わりに2種類のタイルを製造する必要があり、これは間違いなくコストアップにつながる。

筆者としては3つ前の画像の「2つのHBMコントローラーを搭載している」案を推したいところだが、これも正直製品が出てこないとよくわからない部分である。

なお、カンファレンスにおける質疑応答としてもう1つ明らかになったのは、Sapphire Rapidsは4本のUPI Linkを外部に出すほか、DDR5は8chと説明されているが、これはトップエンドのSKUのみならずそれ以下のSKUでも共通する。

同じ問題は第1世代EPYCでも存在しており、それもあって第1世代EPYCは有効コア数が少ないSKUであっても4ダイ構成を取ることになっていたが、同じようにSapphire RapidsもすべてのSKUでタイルは4つなのか、あるいは実は今は1タイルとして示しているものが、実際にはCPUコアやLLC、アクセラレーターを搭載したタイルとDDR5/UPI/PCIeを搭載したタイルの2つに分かれており、間をEMIBでつなぐという話なのか、もしくは低コア向けにはメモリーコントローラーやPCIeを倍量搭載するタイルが用意されているのか。いろいろと謎は尽きない(むしろ謎が深まった)のが現時点でのSapphire Rapidsの状況である。

この連載の記事

-

第768回

PC

AIアクセラレーター「Gaudi 3」の性能は前世代の2~4倍 インテル CPUロードマップ -

第767回

PC

Lunar LakeはWindows 12の要件である40TOPSを超えるNPU性能 インテル CPUロードマップ -

第766回

デジタル

Instinct MI300のI/OダイはXCDとCCDのどちらにも搭載できる驚きの構造 AMD GPUロードマップ -

第765回

PC

GB200 Grace Blackwell SuperchipのTDPは1200W NVIDIA GPUロードマップ -

第764回

PC

B100は1ダイあたりの性能がH100を下回るがAI性能はH100の5倍 NVIDIA GPUロードマップ -

第763回

PC

FDD/HDDをつなぐため急速に普及したSASI 消え去ったI/F史 -

第762回

PC

測定器やFDDなどどんな機器も接続できたGPIB 消え去ったI/F史 -

第761回

PC

Intel 14Aの量産は2年遅れの2028年? 半導体生産2位を目指すインテル インテル CPUロードマップ -

第760回

PC

14nmを再構築したIntel 12が2027年に登場すればおもしろいことになりそう インテル CPUロードマップ -

第759回

PC

プリンター接続で業界標準になったセントロニクスI/F 消え去ったI/F史 -

第758回

PC

モデムをつなぐのに必要だったRS-232-CというシリアルI/F 消え去ったI/F史 - この連載の一覧へ