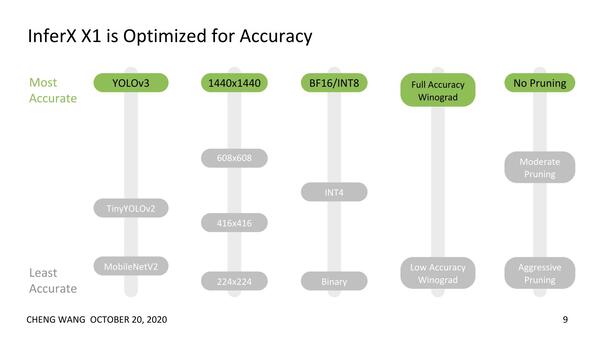

精度重視のためサポートするのは

INT 8ないしBFloat16のみ

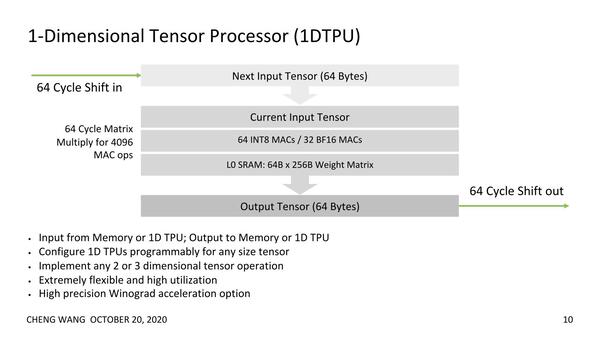

さて価格や性能はおいておくとして、Flex Logicはどうやってこれを実現したか? であるが、基本的な流れは下の画像の通り。64サイクルが一つの区切りになっており、Load/MAC/Saveをパイプライン式に行なえるようになっている。

TPUを2次元構造に並べるベンダーもいくつかあるが、常に2次元を使い切れるとは限らないのが欠点。一方で1次元構造なら、効率は良いものの複雑なネットワークでは通信のレイテンシーが大きくなるという問題もある

ちなみに同社の基本的な発想は精度重視だそうで、それもあって例えばFPGAなどで多用されるBinary(Int 1)やInt 4などのデータ型は使われず、サポートされるのはINT 8ないしBFloat16になっている。

BFloat16では指数部8bit/仮数部7bit(+符号)なので、INT 8の演算エンジンがそのまま流用できるので、都合が良いということだろう。上の画像でINTだと64 MACsなのにBF16だと32 MACsというのは、2つのMACユニットで1つのBFloat16を処理しているのだと思われる。

このTPUが16個と、他にFPGAロジック(図中のEFLX Logic)や2MBのL2 SRAM、それとXFLX Interconnetが組み合わさって1つのブロックを形成。InferX X1にはこれが4ブロック実装されるので、TPUは合計で64個、L2 SRAMは8MBとなる。

おのおののTPUにはMACユニットが64個あるので、トータルで4K MACsということになり、それなりの演算密度ではあるのだが、InferX X1の最大の特徴はこのXFLX Interconnectにある。

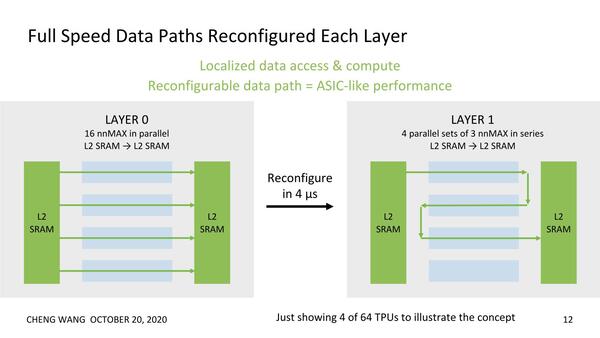

上の画像にも“Tensor Processors are Reconfigurable”とあるが、なにがReconfigurableか? というとTPUそのものではなく、TPU同士をどうつなぐかを動的に変更できるというものである。

Reconfigurationは4μsで(つまり1秒間に最大25万回)変更が可能とされている。これで十分かというと、扱うデータ量やネットワークの層数に依存するが、例えば100fpsを実現したいと思うと、1枚あたり2500回のネットワーク変更が可能なので、普通に考えれば十分であろう。

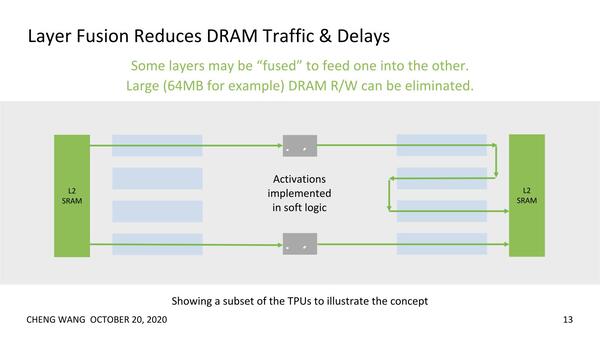

ちなみにこうした複数のTPUを連続して動かすケースでは、ある段のTPUの出力が(そのままメモリーなどを介さずに)次のTPUに渡せるので、メモリー帯域の節約にもなるしボトルネックの削減にもなるとしている。

この連載の記事

-

第768回

PC

AIアクセラレーター「Gaudi 3」の性能は前世代の2~4倍 インテル CPUロードマップ -

第767回

PC

Lunar LakeはWindows 12の要件である40TOPSを超えるNPU性能 インテル CPUロードマップ -

第766回

デジタル

Instinct MI300のI/OダイはXCDとCCDのどちらにも搭載できる驚きの構造 AMD GPUロードマップ -

第765回

PC

GB200 Grace Blackwell SuperchipのTDPは1200W NVIDIA GPUロードマップ -

第764回

PC

B100は1ダイあたりの性能がH100を下回るがAI性能はH100の5倍 NVIDIA GPUロードマップ -

第763回

PC

FDD/HDDをつなぐため急速に普及したSASI 消え去ったI/F史 -

第762回

PC

測定器やFDDなどどんな機器も接続できたGPIB 消え去ったI/F史 -

第761回

PC

Intel 14Aの量産は2年遅れの2028年? 半導体生産2位を目指すインテル インテル CPUロードマップ -

第760回

PC

14nmを再構築したIntel 12が2027年に登場すればおもしろいことになりそう インテル CPUロードマップ -

第759回

PC

プリンター接続で業界標準になったセントロニクスI/F 消え去ったI/F史 -

第758回

PC

モデムをつなぐのに必要だったRS-232-CというシリアルI/F 消え去ったI/F史 - この連載の一覧へ