先週に引き続き、AMDのNext Horizon Gamingイベントで公開された話を解説しよう。今回はCPU編である。

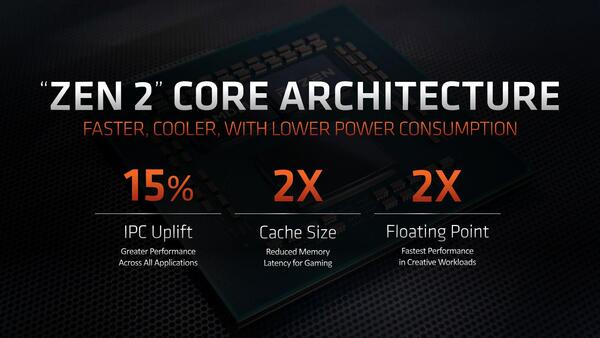

Zen 2ではIPCが15%改善

まずZen 2のコアアーキテクチャー全体で言えば、IPCが15%改善されているほか、3次キャッシュのサイズが2倍となり、またFPU性能も2倍になるとされる。

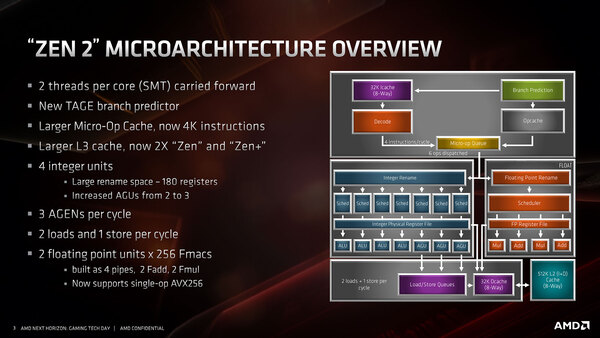

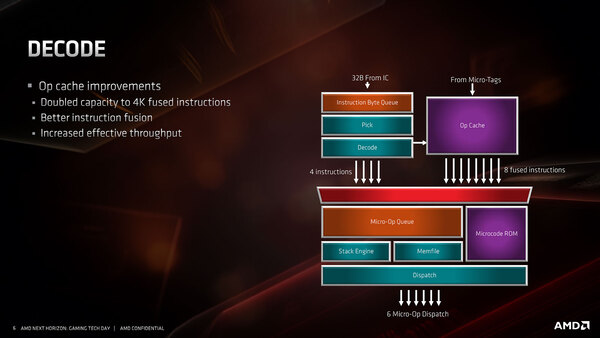

この15%のIPC改善はどうやって実現されたかという話であるが、まず基本的な構造が下の画像だ。

Zen/Zen+の構造と比較すると、以下の違いが挙げられる。

- AGUが1つ追加された3つになった

- Micro-op Cacheの容量が4Kopに倍増した

- 分岐予測に、新たにTAGE(TAgged GEometric)を利用した方式が追加された

そしてバッファ周りでは、以下の違いが挙げられる。

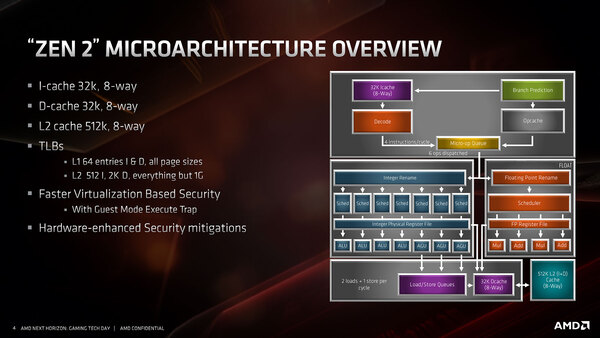

- L1 I-Cacheが64KB/4wayから32KB/8wayに変更

- TLBの大容量化(後述)

- 仮想化マシンのセキュリティー周りの高速化

- 脆弱性対策のハードウェアベースでの強化

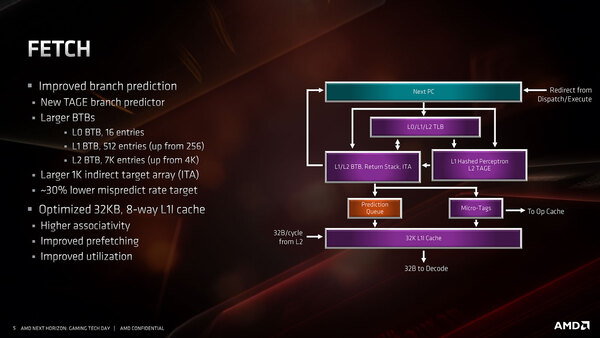

もう少し細かく見てみよう。まずはフェッチだが、BTBが大幅に強化されているのがわかる。もっともこれは上でも書いたが、従来のPerceptronベースの分岐予測に加えてTAGEベースの分岐予測も加わったことで、BTBのエントリーを増強しないと予測が収まりきらなかったものと思われる。他にITAのサイズを増やしたことも挙げられている。

インストラクションキャッシュ(L1 I-Cache)については、そもそもデータキャッシュ(L1 D-Cache)がやはり32K 8-Wayだったわけで、64Kの4-Wayがどこまで有効なのか不思議ではあったのだが、やはり思ったほど有効ではなかったということだろう。

2次キャシュとは32Bytes/サイクルで接続されており、これはデコード段の読み込み速度にあわせたものと思われる。

デコード段については大きくは変わっていないが、先に書いた通りMicro-op Cacheが4Kopに増量されたほか、Op-Cacheから最大8 Fused-opが出力されるようになった。またInstruction Fusionがさらに改良されたとしている。これらの結果として、実効スループットの改善がなされたと思われる。

この連載の記事

-

第863回

PC

銅配線はなぜ限界なのか? ルテニウムへの移行で変わる半導体製造の常識と課題 -

第862回

PC

「ビル100階建て相当」の超難工事! DRAM微細化が限界を超え前人未到の垂直化へ突入 -

第861回

PC

INT4量子化+高度な電圧管理で消費電力60%削減かつ90%性能アップ! Snapdragon X2 Eliteの最先端技術を解説 -

第860回

PC

NVIDIAのVeraとRubinはPCIe Gen6対応、176スレッドの新アーキテクチャー搭載! 最高クラスの性能でAI開発を革新 -

第859回

デジタル

組み込み向けのAMD Ryzen AI Embedded P100シリーズはZen 5を最大6コア搭載で、最大50TOPSのNPU性能を実現 -

第858回

デジタル

CES 2026で実機を披露! AMDが発表した最先端AIラックHeliosの最新仕様を独自解説 -

第857回

PC

FinFETを超えるGAA構造の威力! Samsung推進のMBCFETが実現する高性能チップの未来 -

第856回

PC

Rubin Ultra搭載Kyber Rackが放つ100PFlops級ハイスペック性能と3600GB/s超NVLink接続の秘密を解析 -

第855回

PC

配線太さがジュース缶並み!? 800V DC供給で電力損失7~10%削減を可能にする次世代データセンターラック技術 -

第854回

PC

巨大ラジエーターで熱管理! NVIDIA GB200/300搭載NVL72ラックがもたらす次世代AIインフラの全貌 -

第853回

PC

7つのカメラと高度な6DOF・Depthセンサー搭載、Meta Orionが切り開く没入感抜群の新ARスマートグラス技術 - この連載の一覧へ