2017年~2018年 進化するGCPのAI

GCPには、自分でモデルを作成しなくても予め提供されている学習済モデルを使うことで、アプリケーションに知能を与えることができます。学習済モデルには以下のようなものがあり、そのままAPIで利用できます。

- Cloud Natural Language(自然言語処理)

- Cloud Speech-to-Text(音声データをテキストに変換)

- Cloud Text-to-Speech(テキストを音声データに変換)

- Cloud Translation(機械翻訳)

- Cloud Vision(画像認識)

- Cloud Video Intelligence(動画解析)

必要とする機械学習の機能が、これらの学習済モデルを利用することで代用できるのならば、モデルの作成すら必要ありません。また、メンテンスも全く必要なく勝手に精度も上がっていきます。

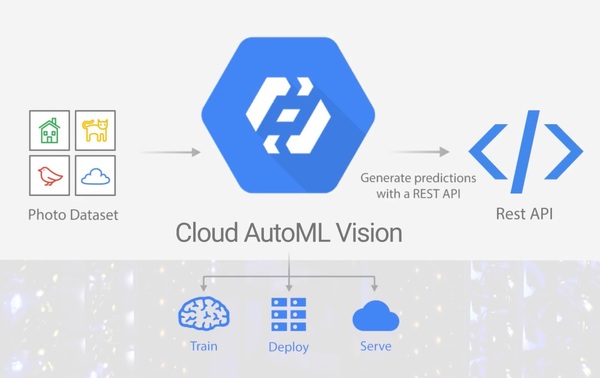

一方で、専門分野になると、Googleが用意している学習済モデルでは対応できないケースが多くなり、その分野に特化した学習モデルが必要になります。Cloud Machine Learning Engineなどで新たに機械学習モデルを作成することもできますが、GCPに2018年に登場した「Cloud AutoML」を使うと、機械学習に関する専門知識がなくても、GCPの学習済みモデルをベースに自社のサービスに合わせてカスタマイズを加えた機械学習モデルを構築できます。

Cloud AutoMLの第1弾としてリリースされた「Cloud AutoML Vision」は、画像認識の機械学習モデルを自社サービス向けにカスタマイズするものです。タグを付けた画像を一定数アップロードすると、数分~1日程度で性能評価のためのデモが可能になり、トレーニング済みモデルはGCP上に直接デプロイできます。

その後、Cloud AutoMLから自然言語処理用のGoogle Cloud AutoML Natural Language、機械翻訳のAutoML Translationがリリースされ、現在はベータ版が利用可能になっています。

おわりに

GCPの歴史をダイジェストに振り返りましたが、GCPの魅力は伝わったでしょうか。「GCPは他のクラウドサービスとどう違うのですか?」という質問をよく受けますが、ここにいくつかの答えがあったのではないかと思います。

Googleは、世界規模のクラウドインフラとスケーリング機能を独自開発し、自分たちの技術を論文やオープンソース化して世間に公開しています。GCPのパブリッククラウドとして提供しているサービスは、いずれもGoogleの自社サービスで十分な利用実績のあるものです。

それに対して他のパブリッククラウドはどうでしょうか。今、他のパブリッククラウドがビッグデータ分析やコンテナ管理に利用しているツールは、起源をたどると実はGoogleが関係していたりします。パブリッククラウドを比較するときに、「安い」「速い」「簡単」「情報が多い」などが比較材料に挙げられますが、少し違った視点で見ると、他のパブリッククラウドがすでに存在しているプロダクトを使っているのに対し、GCPは自分たちのプロダクトを使っている点が大きく異なるということに気づくはずです。

この記事でGCPの素晴らしさが少しでも伝わり、利用してみたいと思っていただけたら幸いです。