Snowflake Summit 2023で両社CEOが語った「AIとデータ・アプリの時代」

「未来の企業はDWHの隣に“AIファクトリー”を作る」SnowflakeとNVIDIAの提携発表

2023年07月04日 07時00分更新

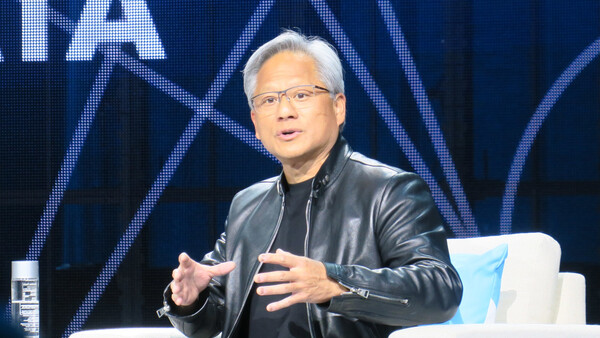

Snowflake 会長兼CEOのフランク・スルートマン(Frank Slootman、左)氏と、NVIDIAの創業者兼CEOのジェンスン・フアン(Jensen Huang、右)氏。「Snowflake Summit 2023」にて

Snowflakeが2023年6月26日、NVIDIAとの提携を発表した。NVIDIAの大規模言語モデル(LLM)開発用プラットフォーム「NVIDIA NeMo」とGPUを使い、Snowflakeデータクラウド内にあるデータを安全に活用した、自社向けの生成AIアプリケーションを開発できるというもの。

同日、米ラスベガスで開幕したSnowflakeの年次カンファレンス「Snowflake Summit 2023」で、Snowflakeの会長兼CEO、フランク・スルートマン氏とNVIDIA 創業者兼CEOのジェンスン・フアン氏が対談し、提携のメリットやAIのインパクトについて意見を交わした。

Snowflakeデータクラウドにあるデータを動かさずAIで活用する

2人の対談では、ベンチャーキャピタリストのサラ・グオ(Sarah Guo)氏がモデレーターを務めた。グオ氏がまずここ数カ月の生成AIをめぐる動きについて尋ねると、NVIDIA のフアン氏は「かつてないレベルのコンピューティングの革命」だと表現した。

「コンピュータがソフトウェアを書く。それも、他のコンピュータに対してもソフトウェアを書くことができる。その意味を考えてみると深い。こんなテクノロジーは見たことがない」「生成AIは、コンピューティングの歴史の中で『最も使いやすいアプリケーション』。期待以上のことをやってくれるし、万能な翻訳者だ」(フアン氏)

またSnowflakeのスルートマン氏は、データの観点から「データとの関係において、自然、かつ高い生産性で洞察のあるものにすることは難しかった。(生成AIにより)我々は突然、これまでとまったく違うステップを踏み出した」と述べた。

SnowflakeとNVIDIAとの提携によって何が起きるのか。これについてスルートマン氏は「生成AIの活用に必要なコンピューティング・ファブリックとサービススタック全体を組み合わせることで、誰もが生成AIを利用できるようになる」と語る。一方のフアン氏は「(NVIDIAの)世界最高の計算エンジンを、(Snowflakeにある)世界で最も価値あるデータに持ち込む」とし、「われわれの関係は“恋人”。競合ではない」と述べて会場を沸かせた。

両社提携による生成AI環境のポイントは「データを動かさないこと」にある。フアン氏は、顧客企業が保有するデータは「巨大かつ貴重」な資源であり、各国の法規制やセキュリティを考えると、データ(Snowflake)の側にコンピューティングエンジンを持ってくるのが良策だと説明する。

「われわれの提携を通じて、SnowflakeにAIを持ってくる。その中核はデータ、AIアルゴリズム、コンピュートエンジンの3つの組み合わせで構成される」(フアン氏)

企業は自ら開発したLLMをどのように使うのか。その活用例としてフアン氏が紹介したのは顧客サービスだ。たとえば「顧客が喜んでいる点」や「改善すべき点」を自然言語で尋ねれば、その答えを自社データから教えてくれる。さらに「顧客が解約する理由」なども回答可能だろう。

これらは企業が最も知りたいことばかりだが、ChatGPTに聞いてもその答えは出てこない。「答えは自社データの中にあるからだ」(スルートマン氏)。つまり一般的なモデルでは一般的な答えしか出すことができず、自社にとって重要な問いは、自社データを学習させたより深いモデルに応えてもらう必要があるわけだ。

フアン氏は「これからの企業は『AIファクトリー』を持つようになる。われわれはインテリジェンスの製造者になる」と持論を展開した。「(AIファクトリーでは)人も雇うが、大量のエージェントを作成する。こうしたエージェントはモデルやナレッジ、Snowflakeのデータに接続される」。こうしたAIアプリケーションやLLMそのものの構築を、SnowflakeとNVIDIAで支援していく狙いだ。

GPUは高価だが最もコスト効率が良い――アクセラレーションコンピューティングの時代へ

一般的に、GPUは高価なリソースと考えられている。ただし、これについてはそろそろ考えを改める必要があるかもしれない。

フアン氏は「1964年に(現在の形が)定まったコンピューティングプラットフォームが、60年ぶりに根本的な変化を起こしつつある」と指摘する。「CPUはもうスケールできない。そのことは、ソフトウェア側の変化によってしっかりと理解されるようになった」。

フアン氏は「CPUを購入し続けてもコンピューティングのスループットは向上しない」「コンピューティングの上にあるOS自体が大きく異なる」という2つの変化を挙げながら、今後は「アクセラレーションコンピューティングが必要」だという結論を導く。もちろんNVIDIAは、そのアクセラレーションコンピューティングのパイオニアだ。

各種パブリッククラウドで提供されているNVIDIA GPUのインスタンスは最も高価だ。ただし「実際にワークロードを動かして、90%の時間を節約できれば、90%の割引ということになる」とフアン氏は強調する。

「(NVIDIA GPUインスタンスは)コスト的には最も高価なインスタンスだが、最もコスト効率が良いインスタンスでもある。アクセラレーションは重要だ」(フアン氏)

フアン氏によると、NVIDIA社内には5台のスパコン(AIファクトリー)があり、そのうちの4つは「TOP 500」にランキングされている。これらのスパコンを使ってモデルの事前トレーニングを行っているため、LLM開発用プラットフォームであるNVIDIA NeMoでは最先端の事前学習済みモデルが提供できるという。

顧客企業は、事前学習済みモデルを利用することでトレーニングに要する時間を短縮でき、費用対効果も高くなる。「Snowflakeのデータに接続するAIアプリケーションを、数日で開発できるようになるだろう」(フアン氏)。

さらにスルートマン氏は、コンサンプションモデルからケーパビリティモデルに移行する必要があると付け加えた。

モデレーターのグオ氏は最後に「なぜSnowflakeとNVIDIAの組み合わせを選ぶべきなのか?」と質問した。スルートマン氏は「われわれがナンバー1だからだ」と即答、またフアン氏は「Snowflakeが人気である理由は、データを保存し処理するのに最適な場所だから。今回の提携により、DWHの隣にAIファクトリーを接続し、インテリジェンスを作ることが初めて実現する」と、あらためて両社の提携をアピールした。