今週お届けするのはKinaraなのだが、この会社は少なくとも2022年3月まではDeep Vision, Incという社名であった。ただインターネットアーカイブで調べると、2022年5月以降はKinaraにウェブページがリダイレクトされるようになっている。4月か5月あたりに社名変更をしたらしいが理由は不明である。なにしろ社歴を見ても社名変更の理由どころか、Deep Visionの名前すら出てこない有様である。

創業者はRehan Hameed博士(当初はCEO、現在はCTO)とWajahat Qadeer博士(Chief Architect)の2人。両博士とも、KinaraというかDeep Vision創業前はスタンフォード大学で研究助手を務めており、どうもこの頃に出会ったらしい。

実は両博士は共同でいくつかの論文を出しており、この論文で論じた仕組みを商用化するために作ったのがDeep Visionだったようだ。もっとも最初の論文である“Understanding sources of ineffciency in general-purpose chips”は筆頭著者がHameed博士、共著者がQadeer博士のものだが、これは文字通り汎用プロセッサーの不効率性を分析したもので、この際のターゲットはH.264のエンコードの際の効率を論じたものである。

ただこの後、2013年に出された“Convolution engine: balancing efficiency and flexibility in specialized computing”は、今度は筆頭著者がQadeer博士、共著者がHameed博士になっているが、文字通り畳み込み処理を効率的かつ柔軟に行なうための仕組みについて論じたものであり、これが同社のARA-1チップの基本になっている。

その論文の中身であるが、これもやはりH.264のエンコードを高速化するというテーマである。2013年に発表された論文なので、まさに論文を書いている最中に2012年のILSVRCでトロント大のImageNetが出てきたタイミングであり、まだこの時点ではAIを意識していなかったものと思われる。

そもそもH.264のエンコードで9割以上の作業はMotion Estimation(動き推定)である。これは前フレームの画像と現フレームの画像を比較して、その画面の中(あるいは画面全体)の動きベクトルを計算するものだが、通常は画像ブロック(4×4ピクセルや8×8ピクセルなどが一般的だが、もっと違うサイズのブロックの指定も可能)単位で、フレーム間でどこに動いたかを比較するわけで、比較というのは前画像のあるブロックと同じ(あるいは近い)構成のブロックがどこにあるかを現画像を舐めて推定するという、大変に手間のかかる作業である。

もちろんいろいろ高速化の技法はあるが、高速化と精度の低下がバーターの関係に近いため、あまり大胆な高速化は画質の劣化やデータ量の増大につながる。したがって画質を保ち、データ量を増やさないためには愚直に画像比較を行なうしかない。この画像比較が全体の9割を占めているというわけだ。

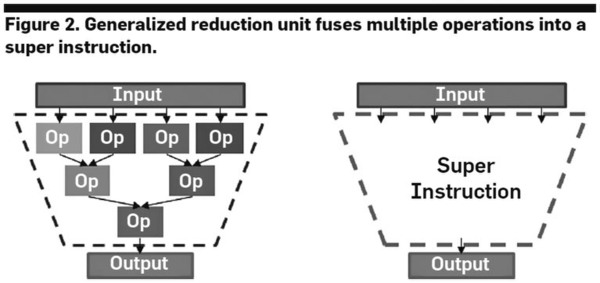

で、この画像比較に畳み込みを使うのだが、畳み込みと言うのは例えば下の画像の左側のような処理になるわけで、これを一気に行なえるような「超命令」を利用すれば処理量が減る、というのが論文の骨子である。

実際には畳み込み「だけ」で動き推定が行えるわけではないが、動き推定の中で畳み込みの処理量がかなり多いのは事実で、これを効率化することで高性能と低消費電力化が図れるとする。

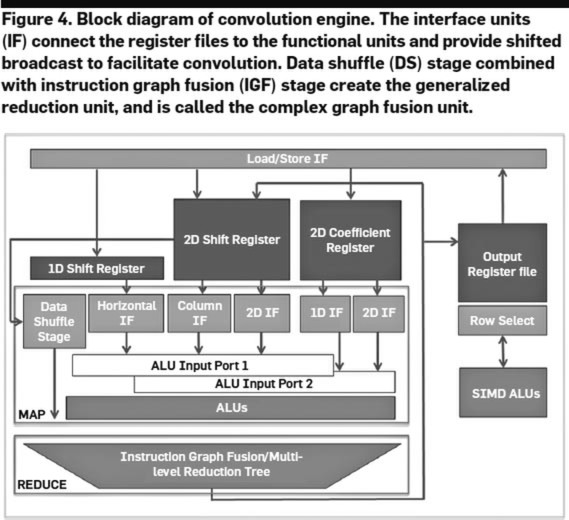

実際に8×8の2次元SAD(Sum of Absolute Difference:差分絶対値和)を計算するための構成が下の画像だ。

ちなみに動き推定というのは、あるブロック同士の比較をして終わるわけではなく、例えばSD映像(720×480)なら極端な話、34万5600回の比較することになる。この際に毎回前画像のブロックと現画像のブロックをロードするのは非効率なので、元画像のブロック(2D Register)と、現画像のブロック(2D Shift Register)のデータは再利用できるように工夫されている。

元画像は8×8ピクセルなのに、現画像は16×8ピクセルになっているのがそれで、この2D SADエンジンでは横8ピクセル分の移動のベクトルを4サイクルで算出できることになる。この2D SAD以外の動作にも対応した畳み込みエンジン(Convolution Engine)と呼ばれるものの全容が下の画像だ。

SADでいうなら、MAPが8×8で64個のピクセル単位の差の絶対値を計算する部分、REDUCEがその総和を取る部分で、畳み込みなら乗加算をMAPで、その後の活性化やサブサンプリングがREDUCEに当たる部分になる。

実際に論文の中では、(ちょうどこの論文が出たころにCadenceに買収された)CPU IPのベンダーであるTensilicaがリリースしていたシミュレーションプラットフォームを利用してこの畳み込みエンジンを実装した場合の評価をしており、専用のASICに比べれば効率はやや落ちるものの、SIMDを利用した場合に比べると大幅に効率が良かったことを報告している。

この論文が出た頃には第3次AIブームが巻き起こっており、しかもそこで利用されている技術は、両博士が得意としていた畳み込み演算が主体である。であれば当然利用できるはず、と考えたのは不思議でもなんでもない。そこで、AIプロセッサーの構築に向けて立ち上げたのがDeep Visionというわけだ。

ちなみに冒頭で当初のCEOはHameed博士と書いたが、スタートアップ企業のCEOにはさまざまなビジネス上の面倒ごとが降りかかってくる。それもあってか、2015年3月からはAppleでGroup Product Managerを務めていたJason Copeland氏がCEOとして参加した。

同氏は、複数のベンチャーからの出資を受けたり、ビジネスプランの策定やスタンフォード大のStartXというベンチャー支援プログラムへの参加、最初のプロトタイプチップ作成あたりまでに付き合い、2017年1月に離職している。

この連載の記事

-

第768回

PC

AIアクセラレーター「Gaudi 3」の性能は前世代の2~4倍 インテル CPUロードマップ -

第767回

PC

Lunar LakeはWindows 12の要件である40TOPSを超えるNPU性能 インテル CPUロードマップ -

第766回

デジタル

Instinct MI300のI/OダイはXCDとCCDのどちらにも搭載できる驚きの構造 AMD GPUロードマップ -

第765回

PC

GB200 Grace Blackwell SuperchipのTDPは1200W NVIDIA GPUロードマップ -

第764回

PC

B100は1ダイあたりの性能がH100を下回るがAI性能はH100の5倍 NVIDIA GPUロードマップ -

第763回

PC

FDD/HDDをつなぐため急速に普及したSASI 消え去ったI/F史 -

第762回

PC

測定器やFDDなどどんな機器も接続できたGPIB 消え去ったI/F史 -

第761回

PC

Intel 14Aの量産は2年遅れの2028年? 半導体生産2位を目指すインテル インテル CPUロードマップ -

第760回

PC

14nmを再構築したIntel 12が2027年に登場すればおもしろいことになりそう インテル CPUロードマップ -

第759回

PC

プリンター接続で業界標準になったセントロニクスI/F 消え去ったI/F史 -

第758回

PC

モデムをつなぐのに必要だったRS-232-CというシリアルI/F 消え去ったI/F史 - この連載の一覧へ