最新パーツ性能チェック 第348回

NVIDIA Reflexでシステムレイテンシーを短縮

第11世代Core対第4世代Ryzen!ゲームの操作遅延が短いのはどっち?

2021年06月24日 11時00分更新

Core i9-11900KのABTの効果もテスト

改めて今回の検証の目的は、GeForce RTX 2060搭載グラボを使った場合、どのCPUを用いた環境でシステムレイテンシーが短くなるのかを調べることにある。1世代前のRTX 2060を使った理由は、システムレイテンシーはGPUの処理が間に合わなくなる(GPUバウンド)状態に時に発生しやすいからだ。そのため、ハイエンドGPUよりも性能が控えめなGPUのほうが都合が良く、そういったGPUほどReflexの効果が得やすい。メモリーやストレージなどの要素は極力同じものを使用した。

CPUの最大動作クロックはインテル側が若干高いが、コア数は8コアないし6コアな点はAMDも同じだ。さらに、Core i9-11900Kに関しては「Intel Adaptive Boost Technology」(以下、ABT)利用時と非利用時のデータも取得した。また、インテル側のマザーボードはゲームのレイテンシーを低減するとされる機能(Lightningゲームポート、CPUダイレクトソースLAN)を備えるASRockの「Z590 PG Velocita」を使っているが、Ryzen向けで同等の機能を搭載したマザーボードが検証時点では存在しなかったため、それらの機能は使用していない。

| 検証環境:インテル | |

|---|---|

| CPU | インテル「Core i9-11900K」(8C/16T、最大5.3GHz)、インテル「Core i5-11600K」(6C/12T、最大4.9GHz) |

| CPUクーラー | Corsair「iCUE H115i RGB PRO XT」(簡易水冷、280mmラジエーター) |

| マザーボード | ASRock「Z590 PG Velocita」(インテル Z590、BIOS 1.30) |

| メモリー | G.Skill「Trident Z RGB F4-3200C16D-32GTZRX」(DDR4-3200、16GB×2)×2 |

| グラフィックス | NVIDIA「GeForce RTX 2060 Founders Edition」 |

| ストレージ | Corsair「Force Series MP600 CSSD-F1000GBMP600」(NVMe M.2 SSD、1TB) |

| 電源ユニット | Super Flower「LEADEX Platinum 2000W」(80PLUS PLATINUM、2000W) |

| OS | Microsoft「Windows 10 Pro 64bit版」(October 2020 Update) |

| 検証環境:AMD | |

|---|---|

| CPU | AMD「Ryzen 7 5800X」(8C/16T、最大4.7GHz)、AMD「Ryzen 5 5600X」(6C/12T、最大4.6GHz) |

| CPUクーラー | Corsair「iCUE H115i RGB PRO XT」(簡易水冷、280mmラジエーター) |

| マザーボード | GIGABYTE「X570 AORUS MASTER」(AMD X570、BIOS F33i) |

| メモリー | G.Skill「Trident Z RGB F4-3200C16D-32GTZRX」(DDR4-3200、16GB×2)×2 |

| グラフィックス | NVIDIA「GeForce RTX 2060 Founders Edition」 |

| ストレージ | Corsair「Force Series MP600 CSSD-F1000GBMP600」(NVMe M.2 SSD、1TB) |

| 電源ユニット | Super Flower「LEADEX Platinum 2000W」(80PLUS PLATINUM、2000W) |

| OS | Microsoft「Windows 10 Pro 64bit版」(October 2020 Update) |

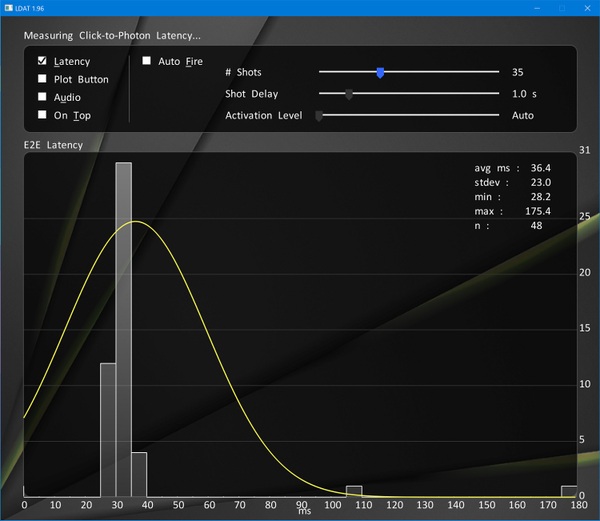

また、今回のテストはNVIDIAが開発したシステムレイテンシー計測ツール「LDAT」を使用したが、ディスプレー環境も超高リフレッシュレートモデルが必要になる。そこで、ASUS製フルHDゲーミング液晶ディスプレー「ROG Swift 360Hz PG259QNR」を準備した。RG259QNRはディスプレー単体でシステムレイテンシー計測が実施できる「Reflex Latency Analyzer(RLA)」対応モデルになるが、今回RLAはまったく使用していない。

リフレッシュレート360HzかつG-SYNC、応答速度1msのIPSパネルを搭載したASUSのゲーミング液晶ディスプレー「ROG Swift 360Hz PG259QNR」。姉妹モデル「同PG259QN」との違いは、RLA対応の有無だけ。今回の検証ではPG259QN相当の機能だけを使っている

NVIDIAはReflexをゲーム開発メーカーに採用してもらうにあたり、システムレイテンシーを手軽に計測できるハードを作った。それがこの「LDAT(Latency Display Analysis Tool)」だ。左の小さなボックスがLDAT本体だ。右のロジクール製マウス「G203」の左ボタンと電気的に接続され、クリックの瞬間を検知できるようになっている

LDATはこのようにディスプレー表面に取り付ける。LDATに接続したマウスのクリック、もしくはLDATとUSBケーブルでつながったPCからの指令を検知した瞬間から、LDATの光センサーが反応した時間を計測する

(c)2021 Square Enix Limited. All rights reserved. Developed by PCF Group S.A. SQUARE ENIX and the SQUARE ENIX logo are registered trademarks or trademarks of Square Enix Holdings Co., Ltd. OUTRIDERS is a registered trademark or trademark of Square Enix Ltd. People Can Fly and the PeopleCan Fly logo are registered trademarks of PCF Group S.A.

アクションシューティングゲーム「Overwatch」は、レイテンシーフラッシュ機能を有効にすると、発砲が描画されると同時に画面左端に白い四角が描画される。銃口にLDATを合わせるよりも確実に発砲の瞬間を捉えられる。ちなみに、「Rainbow Six Siege」や「Fortnite」も同様の機能を実装している

(c)2021 BLIZZARD ENTERTAINMENT, INC.

各CPUごとにRelfexのあり/なしで500発射撃で検証

計測データの考察に入る前に、今回のレギュレーションについて説明しておこう。CPU4機種+α(11900K+ABT、11900K、11600K、5800X、5600X)によるシステムレイテンシーの差異を計測するが、各CPUごとにゲーム側でReflexを“有効+ブースト”設定にした時と、Reflexを無効にした時の2パターンを測る。CPUがシステムレイテンシーに影響を及ぼす場合、Reflexを使った時よりも効果があるのか否かも確認するためである。

そして、各CPUと設定の組み合わせごとに、ゲーム内で銃を500発撃ち、その際のシステムレイテンシーを計測する。もちろん、計測時は同じシーン・同じ銃を使用しているが、背景描写の影響でフレームレートが大きく変動しにくいシーンを選んでいる。

計測したデータは基本統計量(平均値や標準偏差など)を求めるだけではなく、500回の射撃でどのぐらいのレイテンシーがどの程度発生したかなどの観点で検証を進める。最終的には「t検定」を利用し、統計的に各CPU/Reflex設定間に差はあるのか、またはないのかまで調べることとしたい。

この連載の記事

-

第439回

自作PC

暴れ馬すぎる「Core i9-14900KS」、今すぐ使いたい人向けの設定を検証! -

第438回

デジタル

中国向け「Radeon RX 7900 GRE」が突如一般販売開始。その性能はWQHDゲーミングに新たな境地を拓く? -

第437回

自作PC

GeForce RTX 4080 SUPERは高負荷でこそ輝く?最新GeForce&Radeon15モデルとまとめて比較 -

第436回

デジタル

環境によってはGTX 1650に匹敵!?Ryzen 7 8700G&Ryzen 5 8600Gの実力は脅威 -

第435回

デジタル

VRAM 16GB実装でパワーアップできたか?Radeon RX 7600 XT 16GBの実力検証 -

第434回

自作PC

GeForce RTX 4070 Ti SUPERの実力を検証!RTX 4070 Tiと比べてどう変わる? -

第433回

自作PC

GeForce RTX 4070 SUPERの実力は?RTX 4070やRX 7800 XT等とゲームで比較 -

第432回

自作PC

第14世代にもKなしが登場!Core i9-14900からIntel 300まで5製品を一気に斬る -

第431回

デジタル

Zen 4の128スレッドはどこまで強い?Ryzen Threadripper 7000シリーズ検証詳報 -

第430回

デジタル

Zen 4世代で性能が爆上がり!Ryzen Threadripper 7000シリーズ検証速報 -

第429回

自作PC

Core i7-14700Kのゲーム性能は前世代i9相当に!Raptor Lake-S Refreshをゲーム10本で検証 - この連載の一覧へ