一週開いてのAIプロセッサーだが、今回はCompute-in-Memoryタイプのプロセッサーの話だ。Compute-in-Memoryというと連載591回で紹介したMythicが出てくるが、ここはフラッシュメモリーをそのままアナログ演算器として使うという、分類としてはアナログコンピューターに分類される(そう分類せざるを得ない)構造で、その意味では他と比較できない製品である。

対して今回紹介するのはもっと力業である。今年2月16日、Samsung Electronicsはプレスリリースを出し、HBM(High Bandwidth Memory:高帯域幅メモリー)にAIプロセッサーを組み込んだHBM-PIM(Processing-In-Memory)を開発したことを発表した。このHBM-PIM、今年のISSCC(International Solid-State Circuits Conference:半導体業界最大級の国際学会)でその概略が紹介されたので、これをもとに説明しよう。

プロセッサーが消費電力を費やすのは

6割が演算で4割がデータアクセス

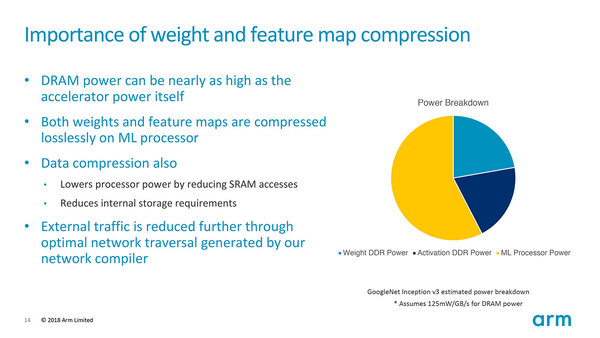

Mythicの時にも説明したが、現在のプロセッサーにおいて少なくない消費電力を費やしているのは、演算ユニットそのものではなくデータアクセスである。下の画像はArmがEthos-N57の発表に先立ち、まだProject Trilliumとして説明されていたころの説明資料である。

機械学習における推論処理を行なうにあたって、全体の6割がプロセッサーそのもので、2割が重み(Weight)を格納するデータアクセス、残りがアクティベーションのためのアクセスに費やされているとしている。

実はAIプロセッサーの場合、相対的に演算処理の比率が高い。なにせ処理がほぼ固定されており、また演算データ量が相対的に少ない(推論では8bit幅ということも多い)ため効率が上がるという話であり、これが倍精度のFPUなどになると演算処理に費やす消費電力と同等以上をデータアクセスに費やすという報告もあったりする。

これはDRAMから遠い所に演算器があるから悪い、という話でもある。要するにDRAM Cell→DRAMチップ内のI/F→ホストへの配線→ホスト側DRAM I/F→内部バス→プロセッサーのデータキャッシュ→レジスターファイル、という遠い道のりを経てDRAMのデータをプロセサーで扱えるようになるから、それは消費電力が増えるのも無理もない。

ArmのEthosの場合は、このDRAMアクセスへの消費電力の多さ、それとレイテンシーを嫌って大容量のSRAMを突っ込んでカバーした形だ。これはCerebras SystemsのWSEなども同じで、AIプロセッサーとしては定番であるのだが、これの欠点はエリアサイズの肥大化である。

そもそもDRAMの場合、1bitの記録にはトランジスタ1個で済むのに対し、SRAMは最低でも4個(ただ4T SRAMは信頼性などの問題もあるため、通常は6つ以上のトランジスタを使う)必要になる。同じサイズの容量を確保するのに、DRAMに比べて最低4倍(実際には6倍以上)の面積を喰う格好だ。DRAMとSRAMで製造プロセスが異なる(SRAMの方が微細化できる)ことを考えても、まだ2~3倍の差は軽くある。

加えてDRAMの場合は大量生産に特化しているためコストそのものは安いが、SRAMは(特にAIプロセッサー向けの先端プロセスの場合)、結構なコストになる。容量あたりのコストを比較すると、SRAMはDRAMよりもおそらく1桁上がることになるだろう。このコスト面の不利さをどう補うか、がテクニックの見せどころになっていたわけだ。

この連載の記事

-

第865回

PC

1400WのモンスターGPU「Instinct MI350」の正体、AMDが選んだ効率を捨ててでも1.9倍の性能向上を獲る戦略 -

第864回

PC

なぜAMDはチップレットで勝利したのか? 2万ドルのウェハーから逆算する経済的合理性 -

第863回

PC

銅配線はなぜ限界なのか? ルテニウムへの移行で変わる半導体製造の常識と課題 -

第862回

PC

「ビル100階建て相当」の超難工事! DRAM微細化が限界を超え前人未到の垂直化へ突入 -

第861回

PC

INT4量子化+高度な電圧管理で消費電力60%削減かつ90%性能アップ! Snapdragon X2 Eliteの最先端技術を解説 -

第860回

PC

NVIDIAのVeraとRubinはPCIe Gen6対応、176スレッドの新アーキテクチャー搭載! 最高クラスの性能でAI開発を革新 -

第859回

デジタル

組み込み向けのAMD Ryzen AI Embedded P100シリーズはZen 5を最大6コア搭載で、最大50TOPSのNPU性能を実現 -

第858回

デジタル

CES 2026で実機を披露! AMDが発表した最先端AIラックHeliosの最新仕様を独自解説 -

第857回

PC

FinFETを超えるGAA構造の威力! Samsung推進のMBCFETが実現する高性能チップの未来 -

第856回

PC

Rubin Ultra搭載Kyber Rackが放つ100PFlops級ハイスペック性能と3600GB/s超NVLink接続の秘密を解析 -

第855回

PC

配線太さがジュース缶並み!? 800V DC供給で電力損失7~10%削減を可能にする次世代データセンターラック技術 - この連載の一覧へ