Lake Crestの後継となる

深層学習用プロセッサーSpring Crest

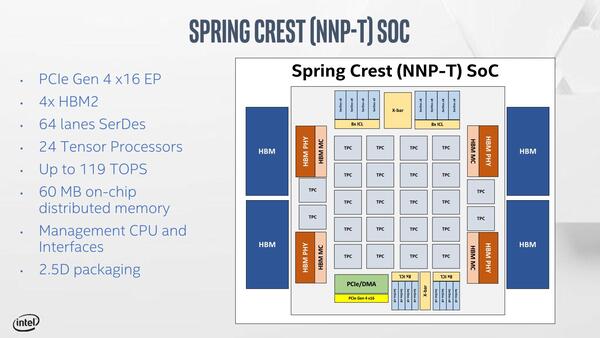

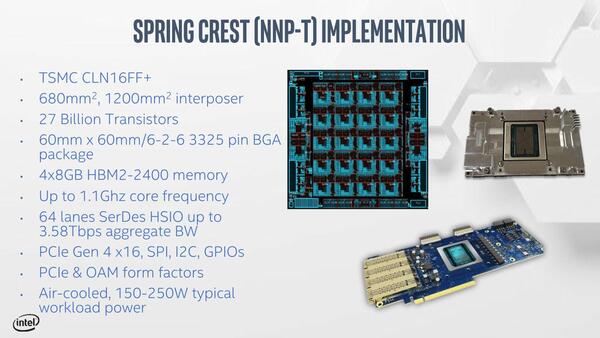

さてそのSpring CrestことNNP-Tは、2つのTensor Coreを組み合わせたTensor Core Cluster(TPC)を24個搭載。PCI ExpressもGen4としたほか、メモリーを2.5MBに増やしている。製造プロセスはTSMCの16FF+を利用、ダイサイズは680mm2とされる。

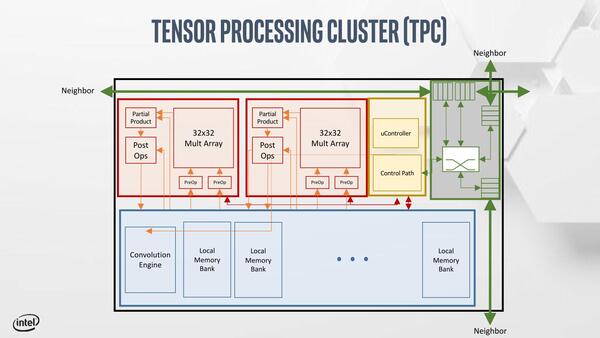

下の画像はTPCの内部構造で、2つのTensor Processorとローカルメモリー、Convolution Engineなどを共有する構造になっている。

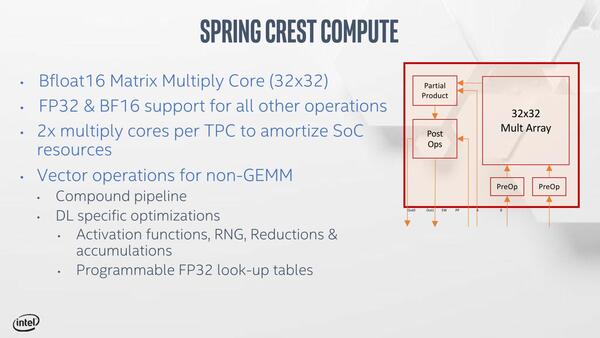

個々のTensor ProcessorはBFloat16の演算ユニットを32×32個アレイ状に配した構成で、1サイクルあたり2048演算(乗算+加算)が可能である。

1TPCあたりなら1サイクルあたり4096演算。これが24個で、1.1GHz駆動ということで 1.1GHz×24×4096=108.1344TOPsとなる。

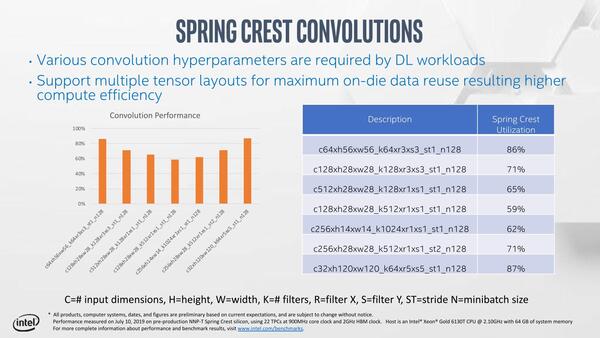

さらに、TPCの共有部にはConvolution Engineが専用に搭載されており、これは上の画像のCompute Unitとは並行して稼働するようなので、これの処理分も含めると119TOpsという数字になるのだと思われる。

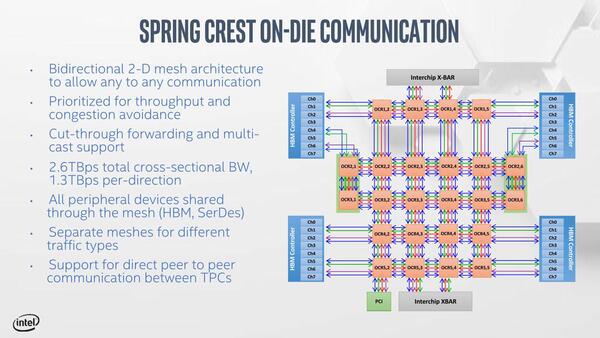

なおそれぞれのTPCは2Dメッシュ構成での接続になっており、すべての周辺機器やI/Oに均一にアクセス可能になっている。

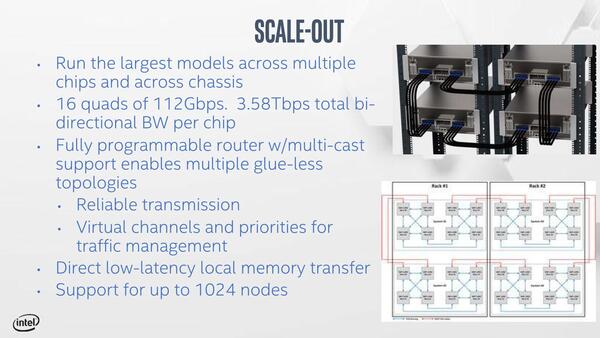

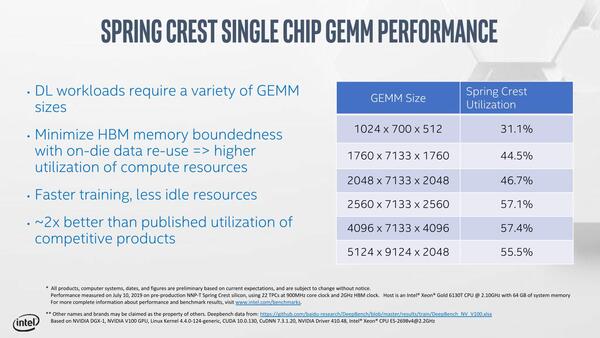

またスケーラビリティーにも配慮されており、最大1024ノードまでの接続が可能とされる。ちなみに性能の一端も公開された。

この連載の記事

-

第863回

PC

銅配線はなぜ限界なのか? ルテニウムへの移行で変わる半導体製造の常識と課題 -

第862回

PC

「ビル100階建て相当」の超難工事! DRAM微細化が限界を超え前人未到の垂直化へ突入 -

第861回

PC

INT4量子化+高度な電圧管理で消費電力60%削減かつ90%性能アップ! Snapdragon X2 Eliteの最先端技術を解説 -

第860回

PC

NVIDIAのVeraとRubinはPCIe Gen6対応、176スレッドの新アーキテクチャー搭載! 最高クラスの性能でAI開発を革新 -

第859回

デジタル

組み込み向けのAMD Ryzen AI Embedded P100シリーズはZen 5を最大6コア搭載で、最大50TOPSのNPU性能を実現 -

第858回

デジタル

CES 2026で実機を披露! AMDが発表した最先端AIラックHeliosの最新仕様を独自解説 -

第857回

PC

FinFETを超えるGAA構造の威力! Samsung推進のMBCFETが実現する高性能チップの未来 -

第856回

PC

Rubin Ultra搭載Kyber Rackが放つ100PFlops級ハイスペック性能と3600GB/s超NVLink接続の秘密を解析 -

第855回

PC

配線太さがジュース缶並み!? 800V DC供給で電力損失7~10%削減を可能にする次世代データセンターラック技術 -

第854回

PC

巨大ラジエーターで熱管理! NVIDIA GB200/300搭載NVL72ラックがもたらす次世代AIインフラの全貌 -

第853回

PC

7つのカメラと高度な6DOF・Depthセンサー搭載、Meta Orionが切り開く没入感抜群の新ARスマートグラス技術 - この連載の一覧へ