AIの大まかな話は前回説明した通りだが、もう少し細かく「なにをやっているか」を今回説明したい。

やや古い話であるが、GTC 2015においてFacebookのRob Fergus氏が“Visual Object Recognition Using Deep Convolutional Neural Networks”というトレーニングコースを実施しており、現在もGTC オンデマンドで視聴できる。

25分ほどの短いセッションで、英語も平易なのでわかりやすいが、こちらのスライドをもとに、そもそもConvolutional Neural Networkではどんな計算処理が必要かを細かく説明していこう。

コンピューターに文字や画像を認識させる

畳み込みニューラルネットワーク

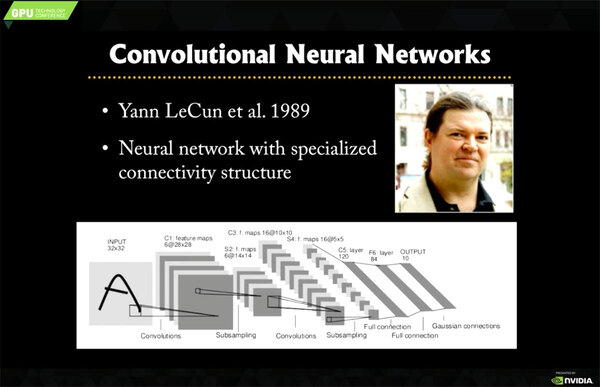

そもそも畳み込みを使うConvolutional Neural Networkを最初に提唱したのは、Facebookに在籍しているYann LeCun氏らによる“Backpropagation Applied to Handwritten Zip Code Recognition”という1989年の論文である。

これは手書きの郵便番号を認識するシステムで、0~9の数字が認識できればいいわけだが、これの認識に下の画像の下側のようなネットワークを考案した。

このネットワークは学習の完了後に1%程度のエラー率で手書きの数字を認識でき、またAT&TのDSP-32Cという汎用DSP(性能はピークで25MFlops)に実装したところ、毎秒30回の認識できたとする。アメリカの場合は郵便番号が5桁なので、つまり毎秒6つの郵便番号を認識できることになる。

前回紹介したAlexNetに比べるとだいぶシンプルではあるが、10種類の文字の認識程度であればこれでも十分、という話である。

LeCun氏のネットワークの場合、まず畳み込みを2回繰り返し、その後で3層の全結合が行なわれる。意味合い的には、最初の2層の畳み込み層で、入力画像をいわば部品に分解、続く3層でその部品の結果を組み合わせて最終的な判断をする形になる。

画像を調べて特徴を抽出する

「畳み込み」

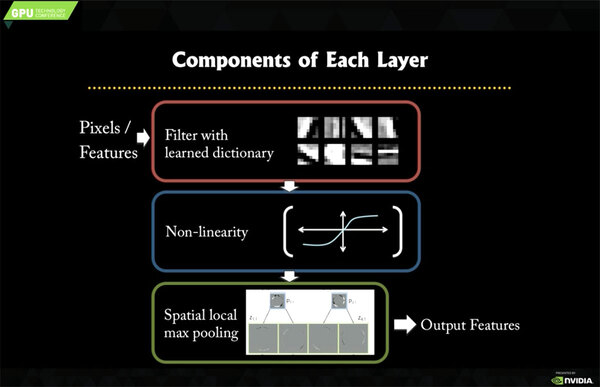

そこでまずは畳み込み層の説明をしよう。ここは畳み込み→非線形関数→サブサンプリングという3つの作業からなる。

さてその畳み込み、確か高校までの数学には出てこなかった「気がする」(なにしろ高校卒業なんてもう40年近く前なので……)。おそらく大学の教養課程の数学で学んだか、物理数学の時間だったかもしれないと思うのだが。

数学的に言えば、2つの関数の重ね合わせのことを畳み込みと表現する。ただここで数式を並べても意味がないので実例で説明したい。

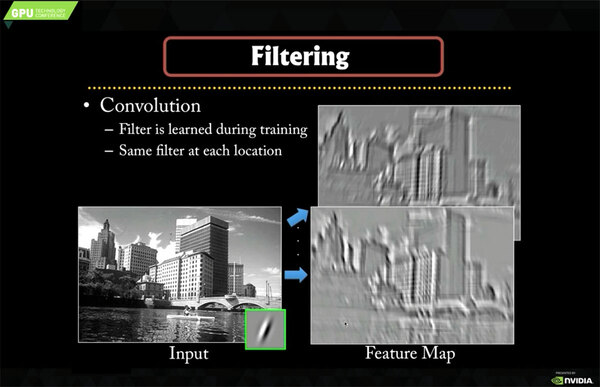

下の画像は、入力画像(左側)とフィルター(Inputの右下:Kernelとも呼ばれる)の畳み込みを行なった出力(Feature Map)を示したものだ。

ここでどんな処理をしているかというのが下図である。要するに左上から右下まで、フィルターの位置を少しずつずらしながら、入力画像とフィルターを重ね合わせ、合計値をFeature Mapとして出力する形になる。

図の例で言えば、Feature Mapの1ピクセルを出力するのに乗算と加算がそれぞれ9回必要になるので、1枚(図の例なら6×6pixel)を生成するのに324回の乗算と加算が必要になる計算だ(*1)。

(*1) ここの例ではFeature Mapのサイズを入力画像より小さい6×6にしているが、精度を上げるために同じ8×8にするといったことも当然可能である。この場合は計算回数が576回に増えることになる。

ちなみにフィルターは1種類ではない。したがって、複数のフィルターを掛け、複数のFeature Mapを生成する必要がある。

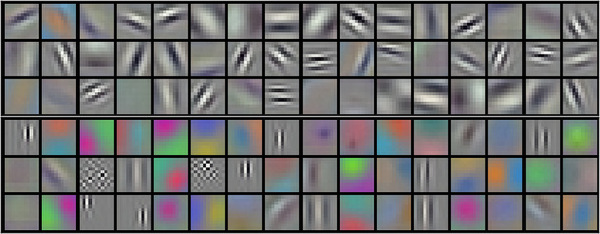

下の画像は2012年のAlexNetで利用されたもので、合計96種類のフィルターが利用された。

- 入力画像は224×224pixel×24bit(RGB)

- フィルターは11×11pixel×24bit(RGB)

このAlexNetの場合、1枚のFeature Mapを生成するのに必要な計算数は1662万3948回。しかもフィルターは96種類あるので、15億9589万9008回の乗算と加算が必要ということになる。

もうこのあたりで、だいぶ桁が大きくなっている。ちなみにこれはあくまで1層分である。冒頭のLeCun氏のネットワークでも畳み込みは2層、AlexNetでは5層もあるので、それは計算量が多いわけだ。

この連載の記事

-

第865回

PC

1400WのモンスターGPU「Instinct MI350」の正体、AMDが選んだ効率を捨ててでも1.9倍の性能向上を獲る戦略 -

第864回

PC

なぜAMDはチップレットで勝利したのか? 2万ドルのウェハーから逆算する経済的合理性 -

第863回

PC

銅配線はなぜ限界なのか? ルテニウムへの移行で変わる半導体製造の常識と課題 -

第862回

PC

「ビル100階建て相当」の超難工事! DRAM微細化が限界を超え前人未到の垂直化へ突入 -

第861回

PC

INT4量子化+高度な電圧管理で消費電力60%削減かつ90%性能アップ! Snapdragon X2 Eliteの最先端技術を解説 -

第860回

PC

NVIDIAのVeraとRubinはPCIe Gen6対応、176スレッドの新アーキテクチャー搭載! 最高クラスの性能でAI開発を革新 -

第859回

デジタル

組み込み向けのAMD Ryzen AI Embedded P100シリーズはZen 5を最大6コア搭載で、最大50TOPSのNPU性能を実現 -

第858回

デジタル

CES 2026で実機を披露! AMDが発表した最先端AIラックHeliosの最新仕様を独自解説 -

第857回

PC

FinFETを超えるGAA構造の威力! Samsung推進のMBCFETが実現する高性能チップの未来 -

第856回

PC

Rubin Ultra搭載Kyber Rackが放つ100PFlops級ハイスペック性能と3600GB/s超NVLink接続の秘密を解析 -

第855回

PC

配線太さがジュース缶並み!? 800V DC供給で電力損失7~10%削減を可能にする次世代データセンターラック技術 - この連載の一覧へ