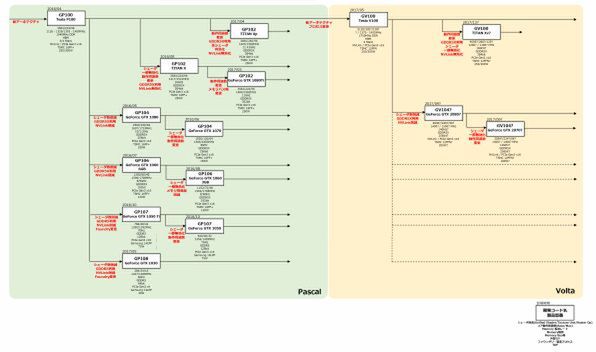

Volta世代のGV100コア製品を発表

Volta世代最初の製品がTesla向け、というのは予定通りであり、今年5月のGTCでTesla V100としてGV100コア製品が発表された。

とりあえずTesla V100は連載373回で解説したように、Power9と組み合わせる形でオークリッジ国立研究所のSummitとローレンス・リバモア国立研究所のSierraに納入が予定されている。まずはこれ向けの量産が最優先となる。

Summitの場合では、トータル4600ほどのノード1つあたり2つのPower 9と6つのVoltaが搭載されるので、まずは2万8000枚弱のVoltaカードをNVIDIAは量産せねばならない。Sierra向けも合わせると4万枚弱といったあたりで、これが一段落するまで少なくともGV100コアに関しては派生型などを考えるのは難しいだろう。

Tesla V100の12nm FFNプロセスは

16FF+に6トラックのスタンダードセルを適用

このGV100でもう1つ問題になるのはプロセスである。GTCの基調講演では“TSMC 12nm FFN”とあったが、実はこれはNVIDIA専用のカスタムプロセスである。まずこの話を改めてしておこう。

TSMCは16nm世代で大きく3種類のプロセスを用意した。16FF、16FF+、16FFCである。最初のものが16FFでFinFETの第1世代である。ただこれは量産前の試行とでもいうべきもので、量産製品のほとんどは16FF+という16FFの改良版を利用している。NVIDIAのPascal世代が全部これである。

この16FF+のコストを下げたコンパクト版が16FFCとなる。なぜか最新のTSMCの16nmのページでは説明が省かれているのだが、Googleのキャッシュに残された以前の説明によれば“TSMC also introduced a more cost-effective 16nm FinFET Compact Technology (16FFC). This process maximizes die cost scaling by simultaneously incorporating optical shrink and process simplification”と説明がなされている。

プロセス構成をやや簡単化するとともに、Optical Shrinkをかけて若干エリアサイズを小型化した、低コスト版の16nm FinFETプロセスである。

さてこれに続き、今年3月にTSMCがアナウンスしたのが12FFCである。これは、プロセスの物理的なパラメーターそのものは16FFCそのままである。もともと16FF+→16FFCの際にOptical Shrinkを実施しているが、これはたかだか数%という比率でしかないらしい。

つまりトランジスタのサイズそのものは、ほとんど16FF+と違いがない。例えば縦横1%縮小しても面積比では2%の縮小、寸法を5%縮められれば面積で1割削減になるため効果的ではあるのだが、一方でFinFETの世代では寸法をいじると急激に物理特性が変わってしまうので、いじるといっても影響のない範囲にとどめる場合、そんなに大きく変更はできないことになる。

しかも16FF+→16FFNで一度Optical Shrinkを行なっているので、さらなる縮小はかなり厳しい。実際には少しだけ余分にShrinkの度合いが増えているらしいが、ほとんど違わないそうだ。

ところが12FFCでは、16FFCと比較して9~12%の面積削減と15%の消費電力削減が可能、というのがTSMCの説明である。これは、スタンダードセルを6トラックにしたことで実現した。

スタンダードセルのサイズを縮小して小型化と省電力化、というのはかつてAMDがCarrizoでやった方法である。Carrizoの場合は12トラックのセルを9/7.5トラックで再設計しなおすことで面積を30%削り、消費電力を下げることにも成功したが、その代わり性能が上がらなくなっている。

この「性能が上がらない」は12FFCにも言えることで、したがって12FFCはメインストリーム向けのモバイルSoC向け、という位置づけになっていた。

ということで話を12FFNに戻す。こちらは端的に言えば16FF+に6トラックのスタンダードセルを適用した構造になっている。一応こちらにもOptical Shrinkをかけてはいるが、性能を犠牲にしないために、あまり大きく寸法をいじれなかったようで、結果トランジスタの寸法は16FFCよりも大きいらしい。つまり、サイズ縮小の効果は主にスタンダードセルに6トラックのものを利用したことに起因する。

その効果はあったのか?といわれれば、おそらくあったのだろう、という答えになる。Tesla V100のホワイトペーパーによれば、以下のようになっている。

| 各コアのスペック | ||||||

|---|---|---|---|---|---|---|

| コア名 | GP100 | GV100 | ||||

| アーキテクチャー | Pascal | Volta | ||||

| ダイサイズ(mm2) | 610 | 815 | ||||

| トランジスタ数 | 153億 | 211億 | ||||

| SM数 | 60 | 80 | ||||

ここから以下のように算出できる。

| ダイサイズの算出 | ||||||

|---|---|---|---|---|---|---|

| コア名 | GP100 | GV100 | ||||

| SMあたりのダイサイズ | 10.17mm2 | 10.19mm2 | ||||

| 1億トランジスタ当たりのダイサイズ | 3.986mm2 | 3.863mm2 | ||||

1億トランジスタあたりのダイサイズは微減、というあたりだがSMあたりのダイサイズは微増である。ただ実際にはVolta世代ではSMの中にTensor Coreと呼ばれるテンソル演算用のユニットが追加されている。

さらに共有メモリーサイズも若干増やされており、この増分を吸収してほぼPascalと同等のエリアサイズを実現するには、12FFNの採用が必須だった、ということだと思われる。逆に言えば、12FFNを使ってもそう大きくエリアが削減できるわけではない、ということでもある。

この連載の記事

-

第864回

PC

なぜAMDはチップレットで勝利したのか? 2万ドルのウェハーから逆算する経済的合理性 -

第863回

PC

銅配線はなぜ限界なのか? ルテニウムへの移行で変わる半導体製造の常識と課題 -

第862回

PC

「ビル100階建て相当」の超難工事! DRAM微細化が限界を超え前人未到の垂直化へ突入 -

第861回

PC

INT4量子化+高度な電圧管理で消費電力60%削減かつ90%性能アップ! Snapdragon X2 Eliteの最先端技術を解説 -

第860回

PC

NVIDIAのVeraとRubinはPCIe Gen6対応、176スレッドの新アーキテクチャー搭載! 最高クラスの性能でAI開発を革新 -

第859回

デジタル

組み込み向けのAMD Ryzen AI Embedded P100シリーズはZen 5を最大6コア搭載で、最大50TOPSのNPU性能を実現 -

第858回

デジタル

CES 2026で実機を披露! AMDが発表した最先端AIラックHeliosの最新仕様を独自解説 -

第857回

PC

FinFETを超えるGAA構造の威力! Samsung推進のMBCFETが実現する高性能チップの未来 -

第856回

PC

Rubin Ultra搭載Kyber Rackが放つ100PFlops級ハイスペック性能と3600GB/s超NVLink接続の秘密を解析 -

第856回

PC

1400WのモンスターGPU「Instinct MI350」の正体、AMDが選んだ効率を捨ててでも1.9倍の性能向上を獲る戦略 -

第855回

PC

配線太さがジュース缶並み!? 800V DC供給で電力損失7~10%削減を可能にする次世代データセンターラック技術 - この連載の一覧へ