電通大宮脇准教授に聞く、視覚に関する脳研究の最新事情

わたしたちの脳は、目にしたものをどのように認識しているのか

2014年06月19日 11時00分更新

photo : dierk schaefer CC-BY 2.0

私たちの大脳の中では、どんな処理が、どのように行われているのでしょうか?

かつては、脳の神経細胞に実際に電極を刺さなければ、脳の活動状況を調べることができませんでした。しかし、最近では、体内の水分子を強力な磁場で測定して画像化するfMRI(機能的磁気共鳴画像法)などで、被験者に大きな負担をかけることなく脳内の活動状況を調べられるようになってきています。

得られた最新の研究状況のうち、特に「視覚」について、電通大で最先端の研究に取り組まれている宮脇先生に聞いてみました。

宮脇 陽一──お話を聞いた人

国立大学法人電気通信大学 先端領域教育研究センター 准教授

2001年3月、東京大学大学院工学系研究科先端学際工学専攻博士課程を修了。2001年4月より理化学研究所脳科学総合研究センターの研究員、NICT/ATR脳情報研究所研究員を経て、2012年3月より現職。人間が見ている画像を脳内の信号パターンから再現するなど、主に視覚に関する脳の研究を行っている。手に持っているのは、3Dプリンターで出力した、ご自身の脳!

脳のマクロな活動パターンを、機械学習で分析

遠藤 1年半ほど前に『週刊アスキー』で、脳や身体についての連載をやったときに、宮脇先生のご研究のことを教えてもらったんです。人間が見ている文字を、脳から読み取ってしまうというのでとても驚いて、脳のマイニングというような話もあって「これはぜひ一度お話をうかがわなければ」と思っていました。

宮脇 私は電通大に移ってくる前は、ATR(国際電気通信基礎技術研究所/Advanced Telecommunications Research Institute International)に5~6年ほどいたのですが、そこの室長の神谷さん(神谷之康教授)が、この分野のパイオニアなんです。

遠藤 脳の中の情報を読み出すというのって、米NBCの『CHUCK』('09~'13年)というドラマみたいじゃないですか? あのドラマにあったような、国家が人々の情報を集めまくって管理しているという部分はWikiLeaksでも出てきたわけですが、ストーリー上重要なもう1つのこととして、脳の中の情報を扱う部分はどうなのか? 視覚的に見た文字がコンピューター上でほぼ再現されているのを拝見したのですが、どうやって読み出しているんでしょうか?

宮脇 情報を読み出すというのは、わりとスローガン的に言っているところがあります。技術的には「機械学習」(多数のデータをコンピューターに与えて規則性などを見いださせ、その規則によってデータの内容を判別させる手法)を使います。

遠藤 動物のようには調べられないから、やっている手法にポイントがあると。

宮脇 人間の場合どうやるかというと、fMRIや脳波など、脳を傷つけずに見る方法しかありません。ですが、それだとどうしても粗いデータしか取れない。1個1個の脳細胞の活動までは見られないという問題が、ずっとあったんです。ではどう調べるかというと、1個1個にアクセスはできないですが、この辺にはこういうパターンがある、隣にはちょっと違うパターンとか、表現している情報の違いを調べるやり方を工夫しています。

遠藤 脳細胞は、n個の入力を受けて、1本出ている軸索にパルスが走るという、ある意味とてもデジタルっぽいわけですけれど、マクロ的に引いたところから見るしかないということですか。

宮脇 ええ、たとえば「車」の絵を見ているときの活動パターンと、「バイク」の絵を見ているときのパターンを比べれば、当然違ってくるわけです。今まではそういう発想がなくて、脳のどのあたりが活動したぐらいしか見ていなかった。

遠藤 脳の図にボンヤリと色をつけて、ここが活動しましたとかいうのがよくありましたよね。

宮脇 一部が赤くなっていたりする写真。あれは活動量しか見ていなくて、そこにある情報の内容や違いまでは見分けていなかったんです。

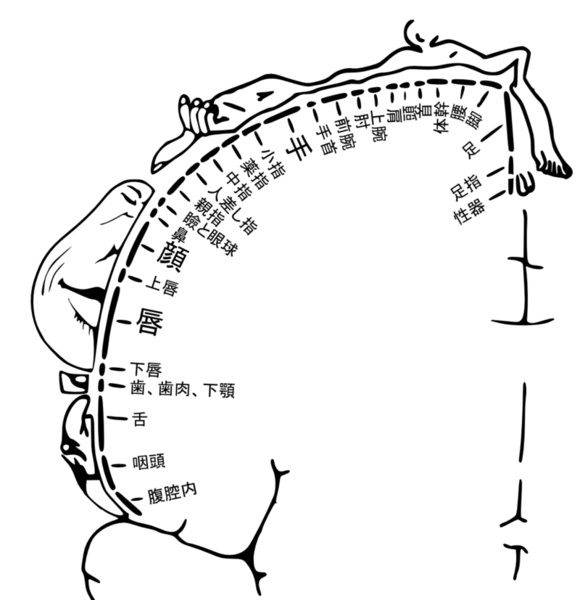

遠藤 すごく有名な昔の図があるじゃないですか。体の部位が脳のどこにマッピングされているかとか。あれとたいして変わらないような。

ホムンクルスの図、ペンフィールドの地図などと呼ばれる図。大脳新皮質のどの部分に体の各部からの信号が来るのかを表している(Wikipedia「体性感覚」から引用)。

宮脇 まったく同じです。

ですので2003年ぐらいに、OCRソフトの文字認識で使われているのと似たようなやりかたで、脳の活動パターンを見分ける研究が始まりました※1 。画像や文字を見たときの脳の活動パターンは、人ごとに微妙に違うんですが、「2」なら「2」の独特のパターンがあるし、「6」なら「6」の独特のパターンがあります。あるモノを見ているときの脳の活動パターンと、別のモノを見ているときの脳の活動パターンを対応付けさせて、機械学習しています。

遠藤 統計的にやっているんですね。

宮脇 そうです。そして、ここから話を発展させれば、その人が見ているものだったり考えているものを読み出せるよね、ということになってきます。

遠藤 パターンと時間軸ですか?

宮脇 時間軸はまだそれほどうまくはいっていません。成功しているのはfMRIを使う場合なんですけれど、fMRIは遅いんです。血流の変化を見ているので、平均的には大体2秒とか3秒に1回のデータしか取れません。神経細胞の活動は電気的で、さささっと進むにも関わらず、fMRIは3秒に1回しか取れませんから。

別のやり方として、たとえば脳磁場。磁場が出てくるのを捉えると、これは速いので時間のプロセスを追えるのですが、逆に空間がダメになってしまう。そこで、いまはあまり時間のほうは見ないで、fMRIで空間パターンとして捉えるのが主流です。

この連載の記事

-

第2回

デジタル

正解主義から脱却し、20年、30年先の時代を逆算した教育を -

第1回

デジタル

ITとともに生まれた産業革命に匹敵する本質的な方法論 - この連載の一覧へ