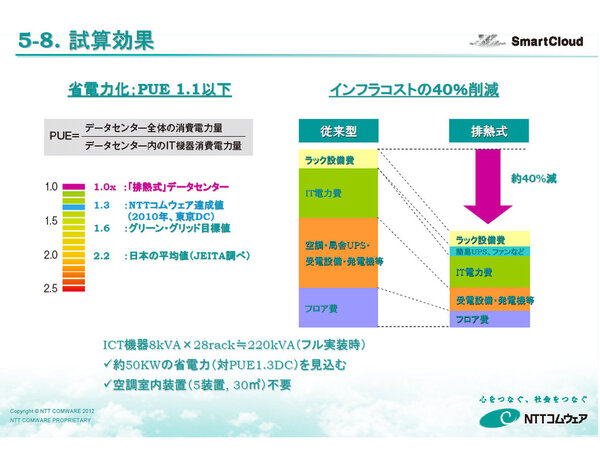

省エネ効果は年間でPUE1.02キープ

インフラコストは45%削減!

同社は、この排熱式データセンターのラックに60台のサーバーとヒーターを搭載し、2011年11月から実証実験を開始し、シミュレーションと実態があっているかを検証した。そして、この結果、厳寒期や酷暑期においても、PUE1.02の安定したサービスが提供可能であることを確認したという。

冬期は外気と排熱を混気させたことで、ICT機器の吸気温度は最適値内を維持した。「外気最高気温が32℃を超えた日数は気象台観測で43日あったが、いずれもファンの制御で、外気温度以上には上がらなかった」(尾西氏)とのことで、夏期も許容範囲で乗り切った。

注目したいのはコストだ。空調機を用いるPUE1.3のデータセンターに比べ、PUE1.02となった排熱式データセンターの空調電力はなんと1/30に激減した。また、DC12Vの直流給電を用いることで、ICT電力自体も5%程度減っているという。

また、インフラコストも45%削減されている。電力コストが減ったほか、空調機器や大型UPSなどを排除。高密度実装を実現しているため、フロア費も下がっているためだ。排熱式データセンターはコストインパクトもかなり大きいといえるだろう。

ハウジングやホットアイルでの作業が課題

さて、省エネやコスト面で大きな効果を得られる排熱式データセンターだが、課題もある。1つめは、顧客がICT機器を預け入れるハウジングにおける排熱式データセンターの利用だ。

クラウドやホスティングの場合、利用するICT機器はNTTコムウェア側で選択できるが、ハウジングの場合はそうはならない。つまり、顧客が40℃対応のサーバー以外を持ち込む可能性があるわけだ。

そこで、同社では第2サイトを構築し、空調機と外気冷却を効率的に併用する方法を模索している。具体的には、夏期は空調機でホットアイル側の空気を組み込むのではではなく、より低温の外気を用いることで省エネを実現しようというものだ。夏期を乗り越えれば、あとは外気冷却と排熱と外気の混気を用いれば大丈夫という目論見である。

もう1つの課題は、ホットアイル側での作業だ。尾西氏は、「排熱式データセンターでは、ホットアイル側が常時30℃を超えるため、オペレーターの作業は厳しい」と語る。そこで、前面のコールドアイル側で配線でき、大口径ファンを用いるモジュール型サーバーを採用していく予定。ファシリティだけではなく、機器の選定にまで細かく配慮することで、省エネや作業効率をより追求していくわけだ。とはいえ、「12V対応のストレージも、ホットプラグの低価格UPSもない」(尾西氏)とのことで、排熱式データセンターに配慮したICT機器は、今後も課題となるようだ。

見学会を通じて、強調されたのは「ローコストへのこだわり」だ。PUEにこだわった省エネデータセンターを一棟まるごと建てる事業者も多いが、NTTコムウェアの取り組みはあくまで既存設備の「リノベート」。低価格な汎用品を用いたDIYの取り組みが印象的だった。