AI学習向け/AI推論向けデータセンターとネットワーク、コンサルティングまでサービス提供

生成AI特化のデータセンターもまとめて提供 オプテージの“AIデータセンター戦略”

2025年02月26日 09時00分更新

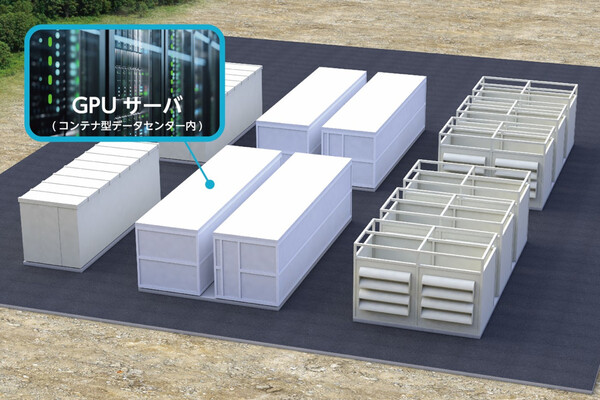

関西電力グループの総合情報通信事業者、オプテージは、2026年1月に大阪市内で運用開始する「曽根崎データセンター(以下、OC1)」と並行して、もうひとつのデータセンター新設プロジェクトを進めている。生成AIに対応する高性能GPUサーバーに特化した「生成AI向けコンテナ型データセンター(仮称)」だ。こちらは福井県の美浜町で、2026年度中の運用開始を予定している。

OC1が「コネクティビティ(接続性)」を重視したコンセプトのデータセンターであることは前回記事でお伝えしたとおりだが、福井県美浜町の生成AI向けデータセンターは、OC1では対応が困難なニーズをカバーする目的で設計、構築される。すなわち、両データセンターは相互補完的な役割を担うことになるという。

この生成AI向けコンテナ型データセンター(以下、AIデータセンター)は、ユーザーにどのようなメリットをもたらすのか。そして、OC1との組み合わせでオプテージはどんな相乗効果を狙うのか。オプテージでデータセンターとクラウドビジネスの責任者を務める津田和佳氏に、その戦略を詳しく聞いた。

AI/GPUデータセンターの電源容量という課題を解決する「役割分担」

はじめに、オプテージが考える「AIデータセンターとOC1の役割分担」を簡単にまとめると、次のようになる。

・AIデータセンター:大容量の電源と冷却設備が必要なAI学習用GPUサーバー向けデータセンター

・曽根崎データセンター(OC1):低遅延のネットワーク環境が必要なAI推論用GPUサーバーや汎用的なサーバー向けデータセンター

オプテージ「曽根崎データセンター(OC1)」は、2026年1月に運用を開始する“コネクティビティデータセンター”だ(関連記事)

そもそもAIデータセンターのプロジェクトが立ち上がったのは、顧客企業にOC1を紹介していく中で、「AI学習用途のGPUサーバーを設置したい」という多くのニーズを聞いたためだと、津田氏は説明する。

「OC1は、標準で1ラックあたり8kVA、最大で12kVA程度までの給電容量を考えて設計しています。しかし、お話をうかがっていくうちに、ラックあたり20kVA、30kVAを使いたいというお客さまが非常に多くいらっしゃることが分かりました。しかも、それを数十ラック規模で展開し、とにかく早く利用したいと」

LLMなど、大規模なAIモデルの学習処理に使われるGPUサーバーは、従来の汎用的なサーバーとはケタ違いの電力を消費する。たとえば、NVIDIAのGPUサーバー「DGX H100/H200」の最大消費電力は1台あたり10.2kW、「DGX B200」は同14.3kWだ(数値はASCII.jp調べ)。さらに、消費電力量に比例して発熱量も大きくなるため、冷却設備もそれに見合ったものが必要である。つまり、高性能なGPUサーバーを数十ラック規模で導入しようと考えると、データセンター全体の電源容量や冷却能力から設計を見直さなければならない。

だがその一方で、顧客企業側ではAIのビジネス活用が日増しに本格化しつつあり、自社専用のAIインフラを、クラウドではなくオンプレミスで利用したいというニーズは高まりつつある。OC1の新たなターゲットである、動画配信サービスやゲームなどのコンテンツサービス提供企業、クラウドサービス企業などでも、生成AIなどの高度なAI活用は必須になるだろう。

そこでオプテージが考えたのが、データセンターを分散配置する構成だ。実行場所を問わないAIモデルの学習処理は、大容量の電源が確保できる場所で行う。その学習済みAIモデルを使った推論処理は、ユーザー(インターネット)に近い場所で行う。この2つの場所(データセンター)が安定したネットワークで結ばれていれば、学習と推論を同じ場所で行う必要はない。

こうした背景から、前述したデータセンターの「役割分担」が生まれることになった。AIデータセンターで学習させたAIモデルを、オプテージが自社保有する光ファイバー網経由でOC1に送り、推論処理を組み込んだサービスはOC1から低遅延でユーザーに提供する。まさに適材適所の理想的な役割分担ができるわけだ。

「AI学習用特化型」データセンターとして、液冷方式のGPUサーバーにも対応

今回のAIデータセンターはコンテナ型で建設される。これについて津田氏は、「すでに急増しつつあるる顧客ニーズに対して、迅速に対応するため」だと説明する。コンテナ型であれば短期間で建設が済み、顧客の需要を見ながら増設することも容易である。オプテージによると、1コンテナあたりの設置面積は約500㎡で、最大32台のGPUサーバーを収容する計画だ。

また、AIデータセンターでは液体冷却(液冷)方式のGPUサーバーに対応する。最新のGPUサーバーでは、発熱量が大きいために従来の空冷方式では冷却がまかなえなくなってきている。あらかじめ液冷設備を備え、そうした最新のGPUサーバーの設置に対応している点も特徴である。

「OC1でも、一部のエリアではGPUサーバーをお預かりできるように電力容量を増やし、液冷にも対応できるよう進めています。ただし、ニーズはこれからどんどん大きくなりますので、その場合はやはり、GPUサーバーに特化したAIデータセンターが必要になると考えています」

建設地である福井県の美浜町には、関西電力の美浜発電所があり、用地取得に加えて電源確保も容易にできるメリットがあったという。今回のAIデータセンターは、原子力由来100%の“CO2フリー”電源を用いて稼働する予定であり、ゼロカーボン社会の実現に貢献するものとなる。

そして、美浜町にはオプテージの広帯域な光ファイバー網も敷設されている。これを活用して、閉域接続からインターネット接続まで、ユーザーニーズに応じたネットワークサービスの提供が可能だ。もちろんOC1と接続して、学習用データや学習済みAIモデルのやり取りをシームレスに行うことも可能である。

生成AIのビジネス活用支援に向けて、多様なサービスを提供していく

このAIデータセンターで提供するサービスの第一弾として、オプテージでは、顧客占有型でのGPUサーバー(ベアメタル)サービスを提供すると発表している。GPUサーバーの調達や保守運用はオプテージが行うので、遠隔地であっても足を運ぶ必要はなく、利用しやすいはずだ。

このサービスで導入するGPUサーバーの機種やスペックはまだ公開されていないが、データセンター設備としては、「NVIDIAのH100/H200だけでなく、B200にも対応できるスペックで検討しています」(津田氏)と説明する。また、利用価格については、メガクラウドの同等サービス(1台単位の占有型サービス)と比べて「半額以下の料金でご提供したいと考えています」と話した。

「コンテナ型データセンターとGPUサーバー、それを利用する際のネットワーク、さらに推論処理に適した都心型データセンターのOC1まで、オプテージがすべてワンストップでご提供できます。この点が大きな強みだと考えています」

将来的には、さらに幅広いサービス形態での提供も検討しているという。GPUサーバーを1台単位で利用する占有型だけでなく、“時間貸し”のような従量制サービス、あるいは顧客が保有するGPUサーバーのハウジングなど、顧客ニーズに応じてさまざまなパターンが考えられる。

さらには、顧客企業の業務課題に対して、生成AIとデータをどう活用すべきかをコンサルティングするサービスも用意するという。津田氏は「オプテージのコンサルティング部門、社外のコンサルティングパートナー企業とも連携して、お客さまのニーズに応える提案を増やしていきたい」と語った。

「生成AIのビジネス活用は、日本ではまだ一部の業界や企業にとどまっていますが、米国を中心とした海外ではかなり進んできており、日本に浸透することも時間の問題だと思います。具体的なユースケースが登場すれば、その動きは一気に進む可能性がありますから、お客さまが必要になったときにすぐに使えるよう準備できていることが大切です。2026年度中の運用開始に向けて、オプテージのAIデータセンターに引き続きご注目いただければ幸いです」

この連載の記事

-

第5回

データセンター

伸びしろしかない成長株 新興外資系と地方の注目データセンター4選 -

データセンター

2025年からのデータセンター選びは「5つのトレンド」を押さえよう -

データセンター

これぞスタンダード 専業データセンター3選 -

データセンター

信頼のブランド ネットワークと省エネに強いデータセンター4選 -

sponsored

クラウド時代に選ばれるデータセンターへ オプテージ「曽根崎データセンター」はネットワークへの接続性が強み - この連載の一覧へ

お気に入り

お気に入り