ロードマップでわかる!当世プロセッサー事情 第795回

AI性能を引き上げるInstinct MI325XとPensando Salina 400/Pollara 400がサーバーにインパクトをもたらす AMD CPUロードマップ

2024年10月28日 13時00分更新

前回に引き続きAMDのAdvancing AI 2024イベントの詳細であるが、まずは前回宿題にした質問の返答が返ってきたのでお伝えしよう。

第5世代EPYCのMRDIMM対応はJEDEC次第との返答

Zen 5cはGMI3-Wideの接続をサポートしていた

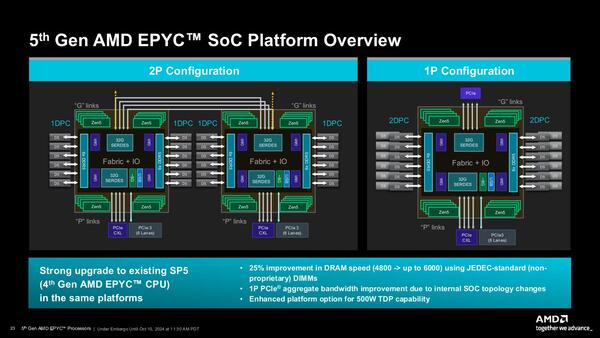

画像の下の方に"25% improvement in DRAM speed (4800 -> up to 6000) using JEDEC-standard (nonproprietary) DIMMs"という表現がある。ではJEDECでMRDIMMの標準化が完了したら、第5世代EPYCでもMRDIMMをサポートするのか? という質問をAMDに投げていた

MRDIMMのサポートについてだが、返答は「MRDIMMは、本質的にはインテルが市場で使用したマーケティング名です。MRDIMMは独自のテクノロジーであるため、現在サポートされていないのは正しいことです。JEDECが技術の標準化を決定した場合は、その時点で決断します。ただし、ご存知のとおり、当社にはデータセンターのエコシステム全体でオープンな標準ベースのテクノロジーをサポートしてきた長い歴史があります」だそうだ。もっともこれには事実誤認(あえて知らないふりをしてると言うべきか)があり、インテルが提唱しているのはMCRDIMMである。

そして連載723回でも触れたが、MRDIMMはもともとHB-DIMMという名前でAMDが開発を始め、これがMRDIMMに改称されたという経緯があるし、そのMRDIMMをJEDECに標準規格化する提案をしているメンバーにはAMDも当然含まれている。

したがって「本質的にはマーケティング名」という返事は間違ってこそいないものの正確ではないと思うのだが、それはさておき。AMDによればJEDECがMRDIMMの標準化を完了したら「決断する」としているあたりは、おそらく準備はできていそうだ。ただそれを公式にサポートするのは標準化完了後になるだろう。水面下ではベンダーを巻き込んでの事前Validation/Certification(検証/認証)は行なっていそうだが。

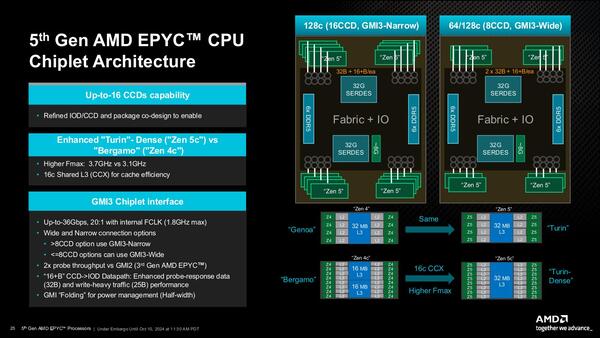

メモリーについてはもう1つ、1 DIMM/chであればDDR5-6000まで可能だが、2 DIMM/chだとDDR4-4400に落ちるのでは? と確認したところ、その通りとの話であった。また、Zen 5cのCCDでGMI Wideを利用可能かどうか判断つかなかったのだが、返答によれば「CCDの種類は問いません。パッケージ上のCCDが8つ以下である限り、GMI Wideを使用できます」とのことで、Zen 5cのCCDもGMI Wideをサポートできることになる。

ということでZen 5cベースの製品のうち、EPYC 9965(192core/12CCD)/EPYC 9845(160core/10CCD)/EPYC 9825(144core/12CCD)の3製品はいずれもGMI Narrowでの接続であるが、8CCD以下となるEPYC 9745(128core/8CCD)およびEPYC 9645(96core/8CCD)の2製品はGMI Wideでの接続になるわけだ。

カタログ性能はあまりMI300Xと差がないが、実際の性能は期待できそうな

AIアクセラレーターInstinct MI325X

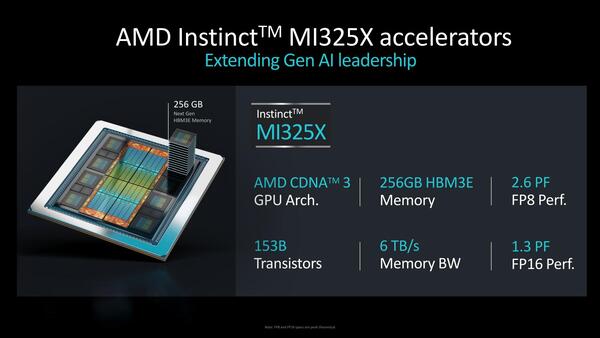

さて今週の最初の話はInstinct MI325Xとその後継製品の話である。まずInstinct MI325Xについて。6月のCOMPUTEXの際にアナウンスはされていたInstinct MI325Xが、今回正式に発表になった。

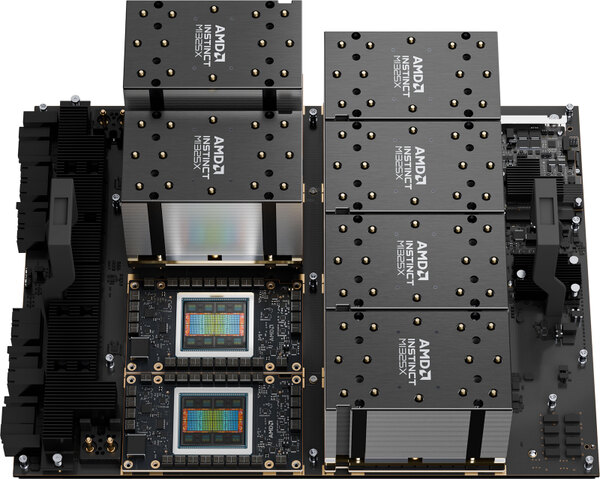

Instinct MI325X。MI300Xの時にはHBMを黒で表現していたのだが、今回はDRAM Cell(?)のパターンを上に貼っている

Instinct MI300Xとの最大の違いはメモリー容量で、Instinct MI300Xが192GB、つまりHBM 1スタックあたり24GBだったのに対し、Instinct MI325Xでは256GB、つまり1スタックあたり32GBに強化されている。おそらくInstinct MI300Xの時は、3GBのDRAMダイを8Hiで積層したのに対し、MI325Xでは4GBのDRAMダイを8Hiで積層したものに変更したのだと思われる。

またHBM3の速度も、MI300Xが5.3TB/秒(*1)、つまりHBM3Eの信号速度は5.18Gbpsほどに抑えられていたが、MI325Xでは6TB/秒になっており、5.86Gbpsほどに引き上げられている。連載749回でもこの話には少し触れたが、まだ6.4Gbpsを達成できるHBM3Eのスタックの入手は難しいようだ。それでもだいぶ6Gbpsに近づいた感はある。

(*1) AMDのプレゼンテーションでは5.2TB/秒になっているが、Instinct MI300Xのホワイトペーパーでは5.3TB/秒になっているので、ここではホワイトペーパーの数字を採用した。

さて一方XCDの方であるが、スペックはまったくMI300Xと変化がない。有効CU(XCU)数は304(つまりXCD 1つあたり38個)なのに変化はないし、動作周波数も2.1GHzのまま据え置きになっている。上の画像で示されたピーク性能もMI300Xと違いがない。にもかかわらずMaximum TBPはMI300Xが750Wだったのに、MI325Xでは1000Wに増えている。

HBM3の転送速度が5.18Gbps→5.86Gbpsまで引きあがったから当然この分で多少のTBP増加は発生するが、さすがにこれで250Wも上るわけがない。これはメモリー帯域の向上にともない、若干ながら実効動作周波数も引き上げられることになったものと考えられる。

そもそも2.1GHzという動作周波数はピークで、実際には温度や消費電力の範囲内で動作周波数を動的に変化させながら稼動させることになるが、この消費電力の範囲を少し緩めた、ということかと思う。変な言い方だが、NVIDIAのBlackwellが1000Wの定格で製品を発表し、これに向けてSuperMicroその他のサーバーベンダーが、この1000W向けの液冷ソリューションを提供し始めている。

こうしたベンダーは当然AMD向けにも同じソリューションを提供するわけで、BlackwellのおかげでモジュールのTBPに1000Wが許容範囲となったので、これにあわせて上限を1000Wまで広げた、というあたりが正しいところだろう。AMDの提供するInstinct MI325Xの写真は空冷ソリューションになっているが、実際には1000Wを使い切ろうと思ったら液冷ソリューションが必須になりそうだ。

ちなみに現時点ではピーク性能ベースの数字しか示されておらず、また実際のベンチマーク結果などもNVIDIAのH200との比較しかないので、これでどの程度性能が上がったのか、は不明である(10%もあがったりはしないと思われる。せいぜいが数%のオーダーだろう)。

むしろ最近は、モデルの規模が大きくなり、パラメーター数が億を超えて兆の単位に膨れ上がり始めた。こうした状況ではオンチップメモリーの容量そのものが性能のボトルネックになりやすいわけで、大規模LLMではGPUがどの程度の利用率なのかという数字を見てみたいものだが、実際にどうかというのはわからない。

1つの目安として、Weights & Biasesの"Monitor & Improve GPU Usage for Model Training"という記事によれば、GPUの利用率が15%未満のケースが全体の30%超えであり、半数は45%以下。90%超えのケースは10%に満たないそうだ。

こんな状況では演算側の性能を引き上げても(カタログ性能はともかく)実際のアプリケーション性能にはほぼつながらないわけで、むしろボトルネックになるメモリーアクセスの帯域や容量を引き上げる方がはるかに性能の底上げに効果的というのは理解しやすい。その意味では、カタログ性能はあまりMI300Xと差がないが、実際のアプリケーション性能はそこそこに改善されることが期待できそうである。

「そこそこ」というのは、帯域の向上率が13%程度(5.18Gbps→5.86Gbps)に留まるからで、良くてこの帯域の向上率程度だろうか。あと、パラメーター数が兆を超え、MI300Xでも収まらないような規模のものでもMI325Xでは収まる場合は考えられるから、こうしたケースでは効果的であろう。

この連載の記事

-

第864回

PC

なぜAMDはチップレットで勝利したのか? 2万ドルのウェハーから逆算する経済的合理性 -

第863回

PC

銅配線はなぜ限界なのか? ルテニウムへの移行で変わる半導体製造の常識と課題 -

第862回

PC

「ビル100階建て相当」の超難工事! DRAM微細化が限界を超え前人未到の垂直化へ突入 -

第861回

PC

INT4量子化+高度な電圧管理で消費電力60%削減かつ90%性能アップ! Snapdragon X2 Eliteの最先端技術を解説 -

第860回

PC

NVIDIAのVeraとRubinはPCIe Gen6対応、176スレッドの新アーキテクチャー搭載! 最高クラスの性能でAI開発を革新 -

第859回

デジタル

組み込み向けのAMD Ryzen AI Embedded P100シリーズはZen 5を最大6コア搭載で、最大50TOPSのNPU性能を実現 -

第858回

デジタル

CES 2026で実機を披露! AMDが発表した最先端AIラックHeliosの最新仕様を独自解説 -

第857回

PC

FinFETを超えるGAA構造の威力! Samsung推進のMBCFETが実現する高性能チップの未来 -

第856回

PC

Rubin Ultra搭載Kyber Rackが放つ100PFlops級ハイスペック性能と3600GB/s超NVLink接続の秘密を解析 -

第855回

PC

配線太さがジュース缶並み!? 800V DC供給で電力損失7~10%削減を可能にする次世代データセンターラック技術 -

第854回

PC

巨大ラジエーターで熱管理! NVIDIA GB200/300搭載NVL72ラックがもたらす次世代AIインフラの全貌 - この連載の一覧へ